Initialement justifiée par une promesse de prix plus bas pour les consommateurs français, la libéralisation du secteur de distribution de l’électricité aux particuliers s’est finalement traduite par une envolée des tarifs réglementés de vente (TRV) d’EDF et des prix du marché privé au cours de la décennie 2010. Le 1er août dernier, les TRV ont encore augmenté de 1,23%, cette hausse faisant suite à un renchérissement spectaculaire de 5,9% intervenu le 1er juin dernier. La libéralisation est également responsable d’une explosion des abus des fournisseurs d’énergie à l’encontre des ménages français, dont s’alarme aujourd’hui le Médiateur National de l’Énergie. Elle nous enjoint à questionner la pertinence de la privatisation et de la mise en concurrence systématiques des anciens marchés dits « de monopole public ».

Mauvaise nouvelle pour le portefeuille des ménages français. Le 1er août dernier, les tarifs réglementés de vente (TRV) qui déterminent les montants des factures d’électricité domestique d’EDF, dont s’acquittent encore 28 millions de ménages français, ont augmenté de 1,23%[1]. En juin dernier, ils avaient déjà bondi de 5,9%, soit la plus forte augmentation depuis 20 ans[2]. Une telle hausse équivalait à 90 euros de facture par an pour un foyer se chauffant à l’électricité, soit une part considérable du reste-à-vivre des ménages appartenant aux trois premiers déciles de revenus. Or, un tiers d’entre eux est déjà en situation de précarité énergétique en France[3].

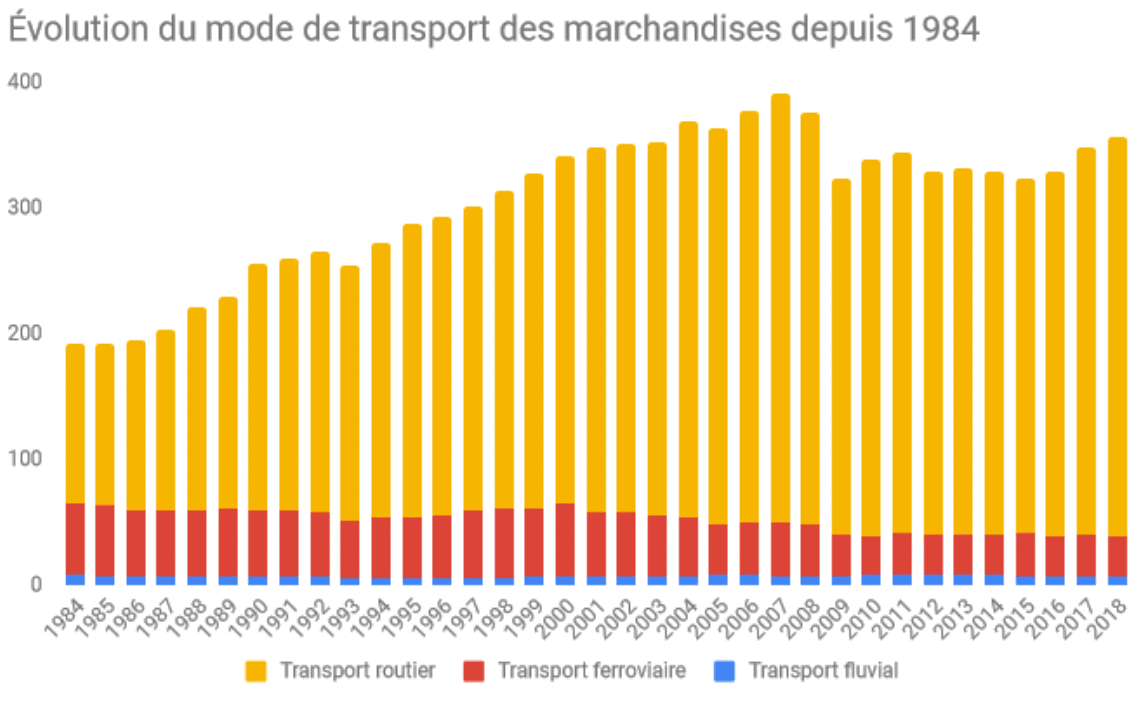

Sous la pression du mouvement des « Gilets jaunes », le Gouvernement avait pourtant annoncé vouloir différer leur augmentation. Après avoir connu une envolée entre 2010 et 2018, les TRV devaient temporairement se stabiliser. Un tel répit aurait été bienvenu car leur revalorisation annuelle avait abouti à une augmentation des prix de l’électricité de plus de 20%[4][5]. Las, la Commission de Régulation de l’Énergie (CRE) en a décidé autrement. Elle a rappelé en février dernier qu’une hausse de 5,9% devait intervenir au mois de juin 2019 au plus tard.

Dans le même temps, le phénomène de précarité énergétique se développe en France et touche aujourd’hui 12% des ménages[6]. La hausse des prix de l’électricité et du gaz fait courir le risque à une part croissante d’entre eux de basculer dans des situations d’insolvabilité ou de grave privation énergétique, dont plusieurs organisations comme la Fondation Abbé Pierre[7], le CREAI[8] ou le CLER[9] soulignent les effets dévastateurs sur l’état de santé physique et psycho-sociale des personnes concernées.

La hausse des prix de l’électricité et du gaz fait aujourd’hui courir le risque à de nombreux ménages français de basculer dans des situations d’insolvabilité ou de grave privation énergétique.

Au-delà d’être excessive, la hausse actuelle des prix de l’électricité est en grande partie la conséquence de la politique de privatisation et de mise en concurrence dans le secteur de la distribution de l’électricité et du gaz. La principale justification politique apportée par la Commission européenne à cette mise en concurrence était pourtant de permettre aux consommateurs de bénéficier de prix bas[10].

Genèse de la libéralisation

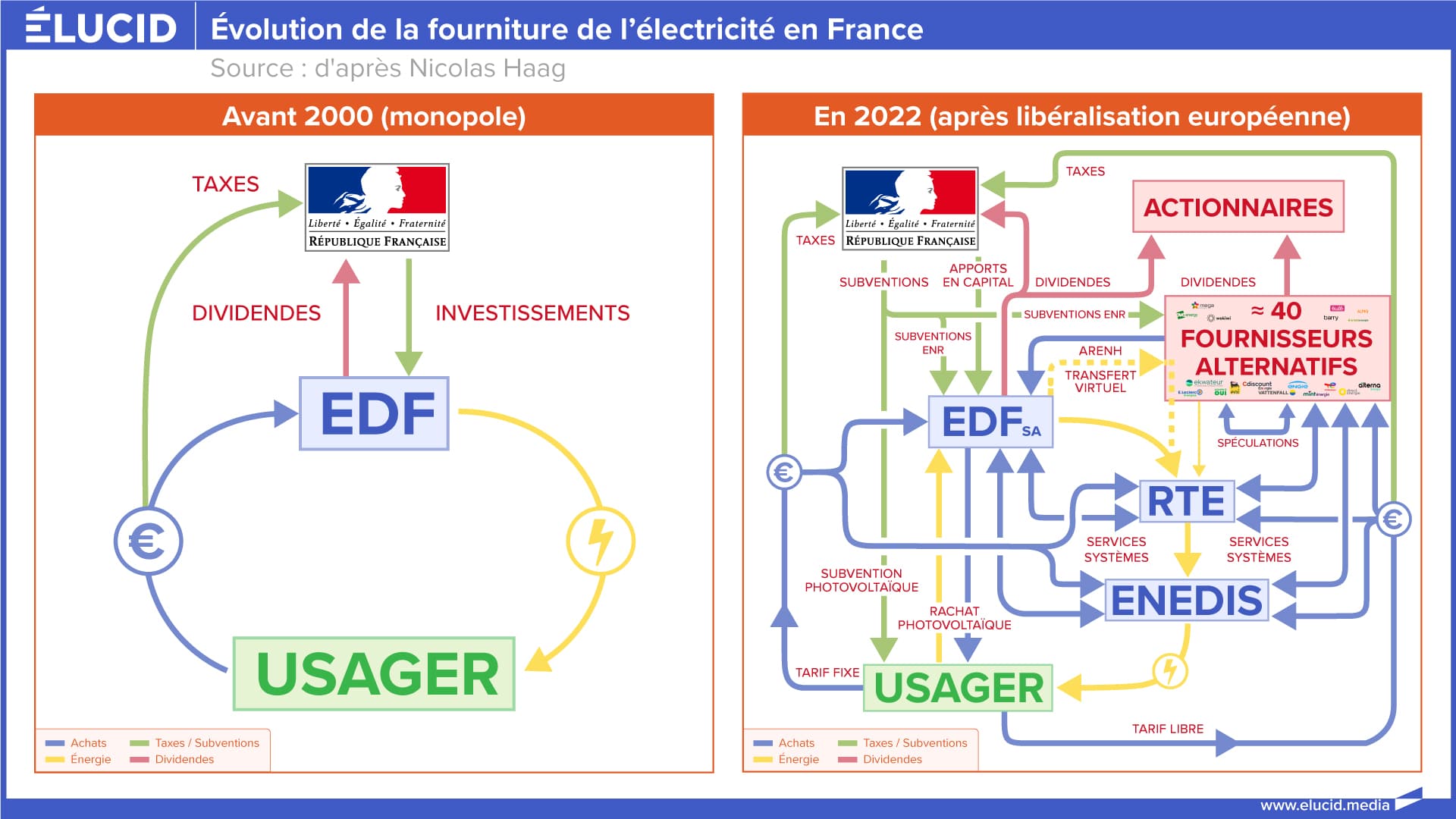

En France, sous l’effet de la transposition des directives européennes de libéralisation des marchés de fourniture de l’électricité et du gaz aux particuliers[11], ces derniers se sont ouverts à la concurrence. En 2000, la CRE était créée afin de veiller au fonctionnement du marché en voie de libéralisation de l’énergie et d’arbitrer les différends entre opérateurs et consommateurs[12]. En 2004, EDF perdait son statut d’établissement public à caractère industriel et commercial (EPIC) pour devenir une société anonyme (SA) [13][14]. Ce choix fut effectué afin de réduire l’entreprise à l’état de simple concurrent au sein du futur marché privé de distribution énergétique. Enfin, début 2007, les marchés de distribution du gaz et de l’électricité aux ménages ont été définitivement libéralisés[15]. À cette date, les ménages français ont pu souscrire un contrat de fourniture auprès d’opérateurs privés concurrents.

Conformément aux exigences de Bruxelles, Paris a ainsi mis en place un système de fonctionnement de marché privé dont il était attendu qu’il favorise la concurrence entre distributeurs, et par là, une baisse des prix des énergies dont les consommateurs devaient être les bénéficiaires[16]. Il s’agissait également de permettre à tout opérateur privé de s’installer sur le marché de distribution de l’énergie et à ces nouveaux utilisateurs des réseaux de distribution de bénéficier, selon les termes de la Commission, d’un droit d’accès « libre, transparent et non-discriminatoire »[17].

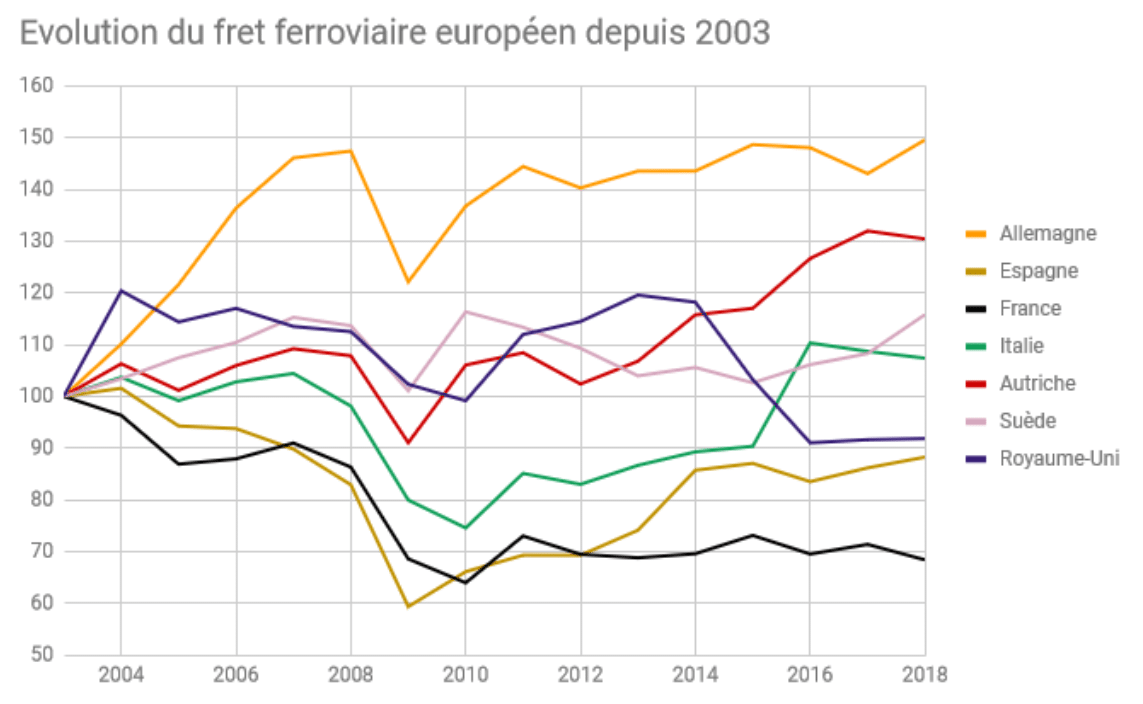

Dans la réalité, le démantèlement des monopoles publics de distribution en vigueur dans de nombreux pays européens a eu un effet exactement inverse. Les prix de vente des énergies aux particuliers se sont littéralement envolés. La libéralisation du marché de l’électricité a abouti à une hausse à trois chiffres des prix de l’électricité en Espagne[18][19]. Elle a également été particulièrement douloureuse au Danemark, en Suède et au Royaume-Uni[20] tandis que dans l’Hexagone, les prix de l’électricité connaissent aujourd’hui un plus haut historique et continuent d’augmenter à un rythme sans précédent depuis le Second Choc pétrolier[21]. Comment a-t-on pu en arriver à une telle situation ?

Dans certains pays européens, la libéralisation a abouti à une hausse à trois chiffres des prix de l’électricité.

Dans le sillage de la libéralisation du marché national de distribution de l’électricité en 2007, le législateur fait voter le 7 décembre 2010 la loi NOME[22], portant sur une nouvelle organisation des marchés de l’électricité. Cette loi est à l’origine de la création d’un mécanisme dit d’« accès régulé à l’énergie nucléaire historique» ou « ARENH », mécanisme par lequel EDF se voit obligé de céder une part de son électricité produite grâce au nucléaire à ses concurrents pour des tarifs « représentatifs des conditions économiques de production » selon les termes de la loi [23]. En France, le secteur du nucléaire permet de produire de l’électricité à prix faible, car inférieur aux sources de production autres que l’hydraulique[24]. L’objectif était donc de stimuler la concurrence, afin que les fournisseurs alternatifs s’approvisionnent en électricité au même coût qu’EDF et abaissent leurs tarifs de distribution.

Concrètement, avec l’ARENH, EDF devait céder un quart de sa production nucléaire à la concurrence privée, à un prix fixé par arrêté ministériel de 42€/MWh[25]. Les concurrents d’EDF avaient ainsi accès à 100 TWh/an d’électricité nucléaire. Cependant, dans un contexte de mondialisation du marché des énergies, ces sociétés sont également amenées à se fournir sur des marchés étrangers au sein desquels les cours de l’électricité, soumis à la conjoncture internationale, sont fortement instables. Parfois, comme en 2016, les prix du marché mondial s’effondrent. Durant cette période, EDF n’a par conséquent vendu aucun kilowatt à ses concurrents qui préféraient s’approvisionner ailleurs. D’autres fois, au contraire, dans un contexte de crise de l’offre ou d’inflation de la demande, les prix augmentent et l’ARENH devient compétitif. Ce mécanisme offrait ainsi aux opérateurs concurrents d’EDF une opportunité d’arbitrage : ils pouvaient se fournir sur le marché mondial quand les prix étaient bas ou via l’ARENH quand ils étaient élevés.

Au cours des années 2010, cependant, en raison de l’appétit du marché asiatique, les prix de gros internationaux ont beaucoup augmenté, de sorte que l’ARENH est devenu hyper-compétitif au regard du marché mondial. Les fournisseurs privés internationaux se sont alors rués vers l’ARENH et ont fait exploser son plafond de vente. 132,98 TWh d’électricité ont été demandés pour l’année 2019, soit 33 TWh de plus que la limite fixée par la Loi[26], forçant le Gouvernement et le Parlement à considérer en urgence, et contre l’avis d’EDF, une augmentation du plafond de vente [27][28][29][30]. En attendant, pour continuer à fournir leurs clients, les opérateurs privés ont été contraints de se tourner vers le marché international[31].

Le mythe de l’auto-régulation

L’histoire aurait pu s’arrêter là. EDF aurait ainsi vu sa compétitivité-prix accrue sur le marché de distribution aux particuliers, aux dépens des autres opérateurs privés soumis aux prix élevés et peu concurrentiels du marché international. Cependant, adoptant l’interprétation « hard line » du principe de concurrence de la Commission européenne, la CRE a estimé que l’accroissement des écarts de prix de vente entre ceux d’EDF et des autres opérateurs privés représentait une menace à l’encontre du principe de libre concurrence. Elle a alors décidé d’intervenir afin d’affaiblir par la force l’avantage concurrentiel d’EDF. Dans une délibération datant de février dernier, elle a préconisé au Gouvernement français de mettre en oeuvre une augmentation des TRV afin de respecter le principe de « contestabilité » des tarifs[32].

Selon cet anglicisme qui constitue désormais une notion de droit économique européen, le niveau des TRV doit être fixé afin que tout fournisseur privé soit en mesure de les concurrencer afin de garantir son maintien sur le marché[33]. En clair, la contestabilité suppose une inversion totale du paradigme de réglementation des marchés. Elle protège les intérêts de l’offre (les fournisseurs) plutôt que ceux de la demande (les ménages). À ce titre, 40% de l’augmentation du prix proposée par la CRE au Gouvernement — 3,3€/MWh sur 8,3€/MWh — n’est pas liée à la hausse objective des coûts d’exploitation d’EDF. Elle provient d’un choix méthodologique consistant à faire correspondre le prix de vente de l’électricité produite par le nucléaire d’EDF à celui fixé dans le cadre de l’ARENH[34]. L’objectif de la CRE était ainsi de limiter les effets négatifs que des TRV bas pouvaient avoir sur la capacité de pénétration et de maintien sur le marché des opérateurs privés concurrents d’EDF.

La contestabilité suppose une inversion totale du paradigme de réglementation des marchés : elle protège les intérêts de l’offre plutôt que de la demande.

Par ailleurs, Bruxelles ne s’est pas contentée d’affaiblir la position d’EDF sur le marché de distribution aux particuliers. La Commission a également ordonné à la France de supprimer définitivement son système de réglementation tarifaire. Adoptée le 11 avril dernier, la loi PACTE a d’ores et déjà programmé la suppression des TRV pour les particuliers et copropriétés au 1er juillet 2023[35]. Elle constitue la suite logique d’un arrêt du Conseil d’État où ce dernier estimait que le maintien des TRV était « contraire au droit de l’Union européenne », constituant « une entrave à la réalisation de marchés de l’électricité et du gaz naturel libres et concurrentiels »[36].

Concurrence(s) et guerre civile

La suite de l’histoire a fait la une de la presse au cours des derniers mois, sur fond de tensions sociales et politiques brutalement ravivées par le mouvement des Gilets jaunes, mais aussi d’inquiétude grandissante exprimée par les ménages françaises quant à l’acquittement de leurs factures énergétiques en explosion.

La validation par le Gouvernement des préconisations de la CRE a d’abord fait bondir les associations de consommateurs. En avril, la CLCV et UFC-Que Choisir adressaient une lettre ouverte au Président de la République, lui enjoignant de renoncer à la hausse du tarif[37]. Selon elles, « approuver cette augmentation reviendrait à tourner le dos aux attentes des Français en termes de pouvoir d’achat et à la logique de dialogue mise en place avec ces derniers depuis le Grand Débat National ». La lettre est restée sans réponse.

À l’annonce de l’augmentation effective des tarifs en juin dernier, les deux associations décident de saisir le Conseil d’État[38]. Le secrétaire général de la CLCV, François Carlier, justifiait cette saisine sur RTL : « cela fait dix ans que le marché français de distribution de l’énergie a été libéralisé. Le fait que les autorités prétendent aujourd’hui être obligées d’augmenter les tarifs de vente du fournisseur historique afin de stimuler la concurrence est complètement paradoxal. (…) C’est en tout cas une décision injustifiable si l’on se place du point de vue de l’intérêt des consommateurs pour lesquels la seule chose qui compte est de bénéficier de prix abordables. La proposition de hausse de la CRE pose donc des problèmes de droit et en la suivant, le Gouvernement commet une faute »[39].

EDF se retrouve dans une situation déloyale et insensée, que ce soit du point de vue de la mission d’intérêt général des services publics ou d’un fonctionnement concurrentiel de marché. L’entreprise se retrouve confrontée à des concurrents qui ne produisent aucune valeur ajoutée dans l’économie, mais vivent d’une rente énergétique.

Les associations de consommateurs n’ont pas été les seules à réagir à l’augmentation des TRV. L’Autorité de la Concurrence l’a elle-même contestée. Dans un avis du 25 mars, l’AAI (Autorité Administrative Indépendante) en charge de la réglementation des marchés en France a estimé que la hausse proposée « conduirait à faire payer aux consommateurs les effets du plafonnement de l’accès régulé à l’électricité nucléaire. Le surcoût serait de 600 millions d’euros pour ces derniers. (…) La hausse des tarifs apparaît dès lors comme contraire à la volonté du Parlement de proposer des tarifs permettant de restituer aux consommateurs le bénéfice de la compétitivité du parc nucléaire historique. (…) Une telle régulation conduirait à transformer, sur le marché de détail aux particuliers, le prix plafond réglementé en prix plancher pour EDF, avec pour effet d’offrir aux clients restés fidèles aux TRV la garantie pour le moins paradoxale de « bénéficier des prix les plus élevés du marché ».[40]

Ces derniers mois, Jean-Bernard Lévy, directeur d’EDF, alertait l’opinion publique sur la position de faiblesse dans laquelle EDF est actuellement mise par la faute de la CRE et de la doctrine libérale du « marché privé de l’électricité » défendue par la Commission. Dans une tribune parue dans Le Figaro en mai dernier[41], c’est le principe de fonctionnement même de l’ARENH qu’il dénonçait, permettant selon lui à des acteurs privés d’accroître considérablement leurs marges sur le dos d’investissements publics, en se dédouanant des charges et risques financiers liés à l’entretien matériel du réseau. En juin dernier, il tirait la sonnette d’alarme : « depuis des années, EDF est victime du système actuel de régulation de l’accès à l’énergie nucléaire. On ne peut pas obliger EDF, entreprise qui a à sa charge l’ensemble des investissements infrastructurels, à subventionner d’autres distributeurs d’électricité privés qui ne font, eux, aucun investissement dans le réseau public (…). Nos concurrents attendent que nous leur fournissions à un prix ultra-compétitif une énergie qu’ils ne produisent même pas afin d’accroître leurs marges. Aujourd’hui, des grands groupes s’implantent sur le marché de la distribution d’électricité et viennent faire beaucoup d’argent aux dépens d’EDF»[42].

Il est vrai que le principe de séparation des gestionnaires de réseau et des fournisseurs de services voulu par Bruxelles produit aujourd’hui un tel niveau d’incohérence que même des think-tanks ultra-libéraux et minarchistes comme la Fondation IFRAP reconnaissent qu’il n’est pas viable, voire même absurde. Selon l’IFRAP, EDF est : « victime d’un système qui contraint l’entreprise à subventionner ses propres concurrents privés alors que dans un fonctionnement de marché libéralisé, ces derniers devraient plutôt réaliser les investissements pour produire eux-mêmes de l’électricité »[43]. EDF se retrouve ainsi dans une situation déloyale et insensée, que ce soit du point de vue de la mission d’intérêt général des services publics ou d’un fonctionnement concurrentiel de marché. L’entreprise se retrouve confrontée à des concurrents qui ne produisent aucune valeur ajoutée dans l’économie, et donc virtuellement aucune richesse, mais vivent malgré tout d’une rente énergétique.

Il est dès lors permis d’acquiescer aux propos d’Henri Guaino, ancien Commissaire général du Plan qui, dès 2002 dans les colonnes du Monde, alertait l’opinion publique sur « l’absurdité économique et technique de la séparation des secteurs de production et de distribution de l’énergie ». Selon lui, « la privatisation voulue par la Commission est un leurre, compte tenu des besoins considérables de financement qu’appellent le renouvellement des équipements de production et la diversification des modes de production énergétique. (…) Comme celle de la SNCF, la réorganisation d’EDF est porteuse de conséquences graves, que les institutions européennes s’efforcent de dissimuler derrière de pseudo-impératifs d’efficacité concurrentielle »[44].

Leçons d’un mirage idéologique

En résumé, le cas de la libéralisation et de la privatisation du marché de l’électricité en France est instructif à plusieurs égards. Premièrement, il nous offre un cas d’étude des incohérences folles auxquelles tout raisonnement logique trop dogmatique peut conduire. De ce point de vue, le paralogisme ultra-libéral — ou plutôt néolibéral — de la concurrence artificiellement stimulée avancé par la Commission européenne et la CRE est digne d’un enseignement scolastique sur les syllogismes. En bref, la puissance publique prétend intervenir en augmentant les TRV, et en sacrifiant ainsi l’intérêt des consommateurs, « au nom du principe de concurrence ». Or, aux yeux de la Commission européenne elle-même, un tel principe est légitimé par le fait que « seule la concurrence permet de défendre l’intérêt des consommateurs »[45]. Marcel Boiteux et les économistes de la Fondation Robert Schuman n’ont pas manqué de s’amuser de ce savoureux paradoxe[46]. Dans un article intitulé « Les ambiguïtés de la concurrence », l’auteur du problème de Ramsey-Boiteux, maître à penser des politiques de tarification publique, déclarait : « avec la suppression des tarifs régulés, il ne s’agit plus d’ouvrir la concurrence pour faire baisser les prix, mais d’élever les prix pour favoriser la concurrence! »[47].

Avec la suppression des tarifs régulés, il ne s’agit plus d’ouvrir la concurrence pour faire baisser les prix, mais d’élever les prix pour favoriser la concurrence!

Deuxièmement, cette affaire nous permet de constater que derrière la prétendue neutralité axiologique du « jeu pur et parfait de la concurrence » avancé par la Commission, se cache une entreprise politique visant à démanteler le monopole de distribution du secteur public de nombreux États membres[48]. On voit se dessiner ici ce qui constitue le cœur d’une idéologie politique en même temps que sa quadrature du cercle. Afin de faire basculer le maximum de ménages clients du système public réglementé vers le marché privé, les fournisseurs concurrents doivent être capables de concurrencer les TRV d’EDF. Or, en France, ces derniers en sont actuellement tout bonnement incapables. La Commission et la CRE multiplient alors les initiatives politiques afin d’altérer les règles du jeu de façon plus ou moins conforme à leurs dogmes, osant pour cela user de méthodes coercitives[49] ou même renier certains postulats idéologiques originels quant au fonctionnement des marchés[50].

Ce constat nous amène à notre troisième point. Le cas de figure dans lequel nous sommes plongés remet en question l’illusion selon laquelle la mise en concurrence tendrait systématiquement à un lissage optimal des tarifs pour le consommateur et devrait à ce titre constituer l’unique horizon de fonctionnement des marchés[51]. Comme le résume l’économiste Paul de Grauwe, « il existe bel et bien des limites au marché »[52][53]. De ce point de vue, la première observation pragmatique qui s’impose est que si la CRE en est réduite à demander au Gouvernement d’intervenir afin de fixer artificiellement à la hausse les prix de la ressource électricité, le marché est faillible et il est très loin d’être autorégulé[54].

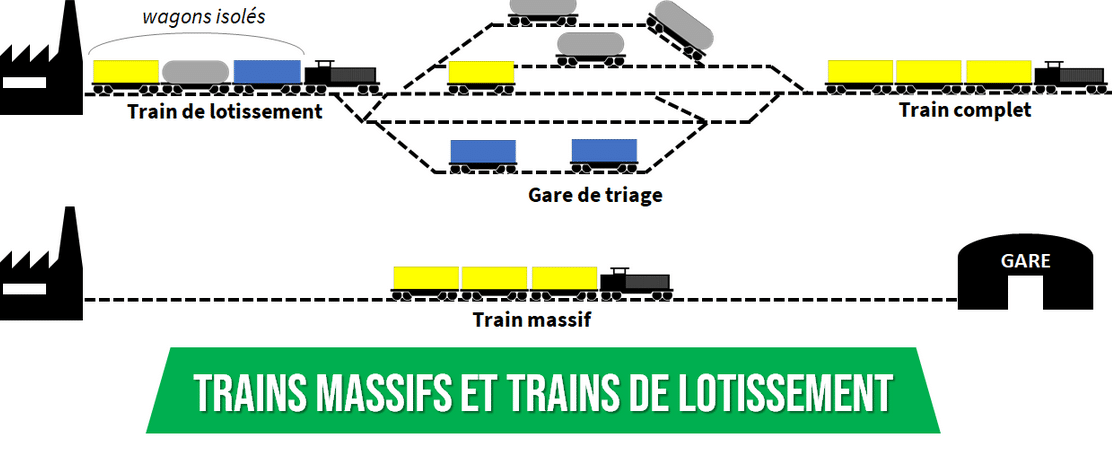

Par ailleurs, certains secteurs, et notamment les activités de réseau (trains, distribution énergétique), constituent des « monopoles naturels ». Cela veut dire qu’ils ont traditionnellement été organisés comme tel parce qu’ils y ont naturellement intérêt[55]. En effet, ce sont des activités où les économies d’échelle et les coûts d’entrée sur le marché sont si considérables que la collectivité publique doit contrôler ce dernier afin d’empêcher qu’il ne tombe aux mains d’un nombre limité d’opérateurs privés. Comme cela a déjà été le cas par le passé dans des secteurs comme le transport ferroviaire au début du XXe siècle aux États-Unis[56] ou la distribution d’électricité en Californie au début des années 2000 (scandale Enron), les acteurs privés pourraient profiter de leur position dominante afin de soutirer une rente d’oligopole en pratiquant des prix trop élevés auprès de leurs clients ou en évinçant une demande jugée trop coûteuse à satisfaire. Une telle dynamique emporte des implications dramatiques en termes d’accroissement des inégalités entre les consommateurs, et donc d’érosion du fonctionnement démocratique des marchés[57][58][59][60][61].

À ce titre, comme le disent Jean-Pierre Hansen et Jacques Percebois, « le marché de distribution de l’électricité n’est pas un marché comme les autres » parce que « l’électricité doit à la fois être perçue comme une marchandise qui peut s’échanger et un service public qui requiert une intervention de l’État » [62]. L’observation est a fortiori justifiée compte tenu du fait qu’un phénomène de monopolisation est actuellement à l’œuvre dans des pans entiers des économies développées[63][64]. Sont notamment concernées les activités de réseaux et celles qui nécessitent des investissements infrastructurels ou informationnels considérables[65][66]. Or, le phénomène d’hyper-concentration aux mains d’un secteur privé sur-consolidé génère une dégradation de la diversité, du prix et de la qualité des biens et services proposés aux consommateurs[67][68].

Le marché de l’électricité n’est pas un marché comme les autres. L’électricité doit à la fois être perçue comme une marchandise qui peut s’échanger et un service public qui requiert une intervention de l’État.

Dans le cadre d’un fonctionnement de marché privé du secteur de l’électricité, un autre risque est lié au fait que certains usagers périphériques pourraient être purement et simplement exclus des services de distribution en raison des coûts d’accès à l’offre que représentent le raccordement et l’entretien du réseau électrique pour ces derniers, notamment dans des territoires mal desservis[69]. De ce point de vue, le service public de l’électricité permet la péréquation tarifaire, en subventionnant les coûts d’accès des ménages[70][71][72]. La loi du 10 février 2000, relative à la modernisation et au développement du service public de l’électricité, avait consacré cette notion de service public de l’électricité dans le droit français, qui « a pour objet de garantir l’approvisionnement en électricité sur l’ensemble du territoire national, dans le respect de l’intérêt général (…) des principes d’égalité et de continuité du territoire, et dans les meilleures conditions de sécurité, de qualité, de coûts, de prix et d’efficacité économique, sociale et énergétique »[73].

Il est donc pertinent de considérer le marché de l’énergie comme un service d’intérêt général, a fortiori compte tenu du fait que notre territoire national est vecteur d’inégalités potentielles en raison de ses nombreux espaces ruraux, d’altitudes variées, insulaires ou ultra-marins[74][75]. Ces réalités sont à mettre en comparaison avec celles d’autres pays européens comme l’Allemagne ou les Pays-Bas, dont les populations sont réparties de manière plus homogène et sur des territoires beaucoup plus densément peuplés et imposant beaucoup moins de contraintes physiques. Cet argument élémentaire de géographie économique[76] semble n’avoir jamais été entendu par la Commission européenne qui estime qu’il n’existe aucune spécificité géographique ou institutionnelle dans le fonctionnement des marchés nationaux.

Par ailleurs, la théorie néoclassique du marché adopte le postulat d’une offre homogène et ignore la question de l’inégale qualité des biens et services fournis aux consommateurs. Or, la libéralisation du secteur de la distribution aux particuliers s’est traduite par une dégradation spectaculaire et à géométrie variable de la qualité des services de distribution d’énergie aux particuliers. En France, on constate notamment une envolée du nombre de plaintes pour harcèlement lié au démarchage téléphonique, de litiges portant sur des contestations de souscriptions abusives, ou encore de dénonciations de pratiques commerciales trompeuses. À tel point que Jean Gaubert, Médiateur National de l’Énergie (MNE), s’en est inquiété dans son rapport annuel, publié en mai dernier[77][78].

Selon l’enquête menée par le MNE, 56% des Français interrogés ont déclaré avoir été démarchés de manière intempestive par au moins un distributeur au cours de l’année 2018, soit une augmentation de plus de 50% en un an. Afin d’augmenter leur clientèle, plusieurs fournisseurs ont aussi eu recours à des pratiques de tromperie aggravée. Le MNE a souligné la multiplication des démarchages téléphoniques visant à informer de fausses mesures législatives en vertu desquelles le changement de fournisseur serait obligatoire. Plus grave encore, le nombre de ménages saisissant le MNE pour changement de fournisseur de gaz ou d’électricité à leur insu s’est lui aussi envolé, en augmentation de 40% sur un an. Plusieurs fournisseurs d’électricité ont même eu recours à des stratégies de souscriptions de contrats cachées, notamment à l’occasion de la vente de produits électroménagers dans des magasins grand public[79].

Enfin, comme les travaux des théoriciens britanniques de la welfare economics l’ont démontré[80], le secteur public doit prendre en compte le coût environnemental des activités de production d’énergie, passé sous silence dans le cadre du fonctionnement de marché privé[81][82]. La question est cruciale en ce qui concerne le secteur énergétique, non seulement s’agissant du nucléaire et de ses déchets radioactifs aux demies-vies de millions d’années[83][84], mais également des déchets engendrés par les infrastructures de production d’autres énergies dont l’État ne détient pas le monopole de production, comme le solaire[85]. De telles externalités environnementales ne sont en principe pas assumées par les acteurs privés [86][87], a fortiori dans le cadre d’un paradigme de fonctionnement séparant les activités de production (publiques) et de distribution (privées) d’électricité.

Une réglementation à réinventer

En ce qui concerne le marché de distribution d’électricité en France, il semble donc que les bienfaits des politiques de libéralisation et de privatisation soient davantage un horizon idéologique qu’une réalité empirique. Si réalité il y a, elle est plutôt liée à la façon dont ces politiques se traduisent aujourd’hui sur le portefeuille des ménages. 12% d’entre eux sont aujourd’hui en situation de précarité énergétique[88]. Dans les régions françaises les plus touchées par ce phénomène, comme le Grand-Est ou la Bourgogne-Franche-Comté, ce pourcentage s’élève d’ores-et-déjà à 25% de la population ou plus[89][90]. Il devrait encore s’accroître, compte tenu de l’inflation des prix des énergies et de la stagnation des revenus des trois premiers déciles, parmi lesquels se trouve l’essentiel des ménages énergétiquement précaires. Le coût social du « paralogisme de la concurrence » est donc considérable. Il conduit des millions de Français à envisager avec moins de confiance leur niveau de vie futur.

Comme le résume le juriste Alain Supiot, « il y a donc de bonnes raisons de soustraire à la toute puissance du Marché des produits ou services qui, comme l’électricité, le gaz, la poste, les autoroutes ou les chemins de fer, reposent sur un réseau technique unique à l’échelle du territoire, répondent à des besoins partagés par toute la population et dont la gestion et l’entretien s’inscrivent dans le temps long qui n’est pas celui, micro-conjoncturel, des marchés. En ce domaine, la France s’était dotée de structures juridiques particulièrement adaptées, hybrides de droit privé et de droit public, qui avaient fait la preuve de leur capacité à conjuguer efficacité économique et justice sociale. Le bilan particulièrement désastreux de la privatisation de ces services doit inciter à faire évoluer ces structures plutôt qu’à les privatiser »[91]. En France comme ailleurs en Europe, il est urgent de changer le paradigme de réglementation du secteur de l’électricité.

[1]Le Monde. Les prix de l’électricité augmentent encore, ceux du gaz baissent légèrement. 29 juillet 2019. https://www.lemonde.fr/economie/article/2019/07/29/les-prix-de-l-electricite-augmentent-encore-ceux-du-gaz-baissent-legerement_5494698_3234.html

[2]La Croix. Électricité, pourquoi les tarifs réglementés augmentent de 5,9%. 31 mai 2019. https://www.la-croix.com/Economie/France/Electricite-pourquoi-tarifs-reglementes-augmentent-59-2019-05-31-1201025744

[3]Observatoire National de la Précarité Énergétique, Centre Scientifique et Technique du Bâtiment. Analyse de la précarité énergétique à la lumière de l’Enquête Nationale Logement (ENL) 2013. 8 novembre 2016. https://onpe.org/sites/default/files/pdf/ONPE/onpe_cstb_indicateurs_pe_enl_2013.pdf

[4]INSEE Première n°1746. Les dépenses des Français en électricité depuis 1960. 4 avril 2019. https://www.insee.fr/fr/statistiques/3973175

[5]Le Monde. Le prix réglementé de l’électricité augmente depuis le début des années 2000. 31 mai 2019. https://www.lemonde.fr/les-decodeurs/article/2019/05/31/des-prix-reglementes-de-l-electricite-qui-augmente-depuis-le-debut-des-annees-2000_5470021_4355770.html

[6]Observatoire National de la Précarité Énergétique. Tableau de bord de la précarité énergétique, édition 2018. 6 mai 2019. https://onpe.org/sites/default/files/tableau_de_bord_2018_v2_1.pdf

[7]Fondation Abbé Pierre (2017). La précarité énergétique en infographie. Focus sur la précarité énergétique en France. https://www.fondation-abbe-pierre.fr/nos-publications/etat-du-mal-logement/les-infographies-du-logement/la-precarite-energetique-en-infographie

[8]CREAI-ORS Languedoc-Roussillon (2013). Liens entre précarité énergétique et santé : analyse conjointe des enquêtes réalisées dans l’Hérault et le Douaisis. https://www.fondation-abbe-pierre.fr/documents/pdf/rapport_precarite_energetique_sante_conjoint_vf.pdf

[9]CLER – Réseau pour la transition énergétique. Comment en finir avec la précarité énergétique? 12 mars 2019. https://cler.org/tribune-comment-en-finir-avec-la-precarite-energetique%E2%80%89/

[10]Commission Européenne (2012). Effets positifs de la politique de concurrence : en quoi la politique de concurrence est-elle importante pour les consommateurs? http://ec.europa.eu/competition/consumers/why_fr.html

[11]Voir directives 1996/92/CE, 1998/30CE, 2003/54/CE et 2003/55/CE. (1. Commission Européenne. Directive 1996/92/CE of the European Parliament and of the Council of 19 December 1996 concerning common rules for the internal market in electricity ; 2. Commission Européenne. Directive1998/30/CE of the European Parliament and of the Council of 22 June 1998 concerning common rules for the internal market in natural gas ; 3. Commission Européenne. Directive 2003/54/EC of the European Parliament and of the Council of 26 June 2003 concerning common rules for the internal market in electricity and repealing Directive 96/92/EC – Statements made with regard to decommissioning and waste management activities ; 4. Commission Européenne. Directive 2003/55/CE du Parlement européen et du Conseil du 26 juin 2003 concernant des règles communes pour le marché intérieur du gaz naturel et abrogeant la directive 98/30/CE).

[12]Légifrance. Loi n° 2000-108 du 10 février 2000 relative à la modernisation et au développement du service public de l’électricité.

[13]Légifrance. Loi n° 2004-803 du 9 août 2004 relative au service public de l’électricité et du gaz et aux entreprises électriques et gazières.

[14]EDF France (2018). Statuts juridico-légaux d’EDF. https://www.edf.fr/groupe-edf/espaces-dedies/investisseurs-actionnaires/statuts-d-edf

[15]Légifrance. Loi n° 2006-1537 du 7 décembre 2006 relative au secteur de l’énergie.

[16]Commission Européenne (2012). Effets positifs de la politique de concurrence : en quoi la politique de concurrence est-elle importante pour les consommateurs ? http://ec.europa.eu/competition/consumers/why_fr.html

[17]Commission Européenne. Directive 2003/55/CE du Parlement européen et du Conseil du 26 juin 2003 concernant des règles communes pour le marché intérieur du gaz naturel et abrogeant la directive 98/30/CE.

[18]El País. ¿Ha funcionado la liberalización del mercado eléctrico en España? 15 novembre 2018. https://cincodias.elpais.com/cincodias/2018/11/14/mercados/1542207624_665776.html

[19]El Correo. La liberalización del sector eléctrico: dos décadas de luces y sombras. 10 décembre 2018. https://www.elcorreo.com/economia/tu-economia/liberalizacion-sector-electrico-20181207175056-nt.html

[20]Le Monde. Le marché et l’électricité, le dogme perd l’Europe. 4 septembre 2017. https://www.lemonde.fr/blog/huet/2017/09/04/le-marche-et-lelectricite-le-dogme-perd-leurope/

[21]INSEE Première n°1746. Les dépenses des Français en électricité depuis 1960. 4 avril 2019. https://www.insee.fr/fr/statistiques/3973175

[22]Légifrance. Loi n° 2010-1488 du 7 décembre 2010 portant nouvelle organisation du marché de l’électricité.

[23]Slate. Nucléaire, éolien… quelle est l’énergie la moins chère en France ? 30 novembre 2011. http://www.slate.fr/story/46785/nucleaire-eolien-energie-moins-chere-france

[24]Connaissance des énergies (2013). Coûts de production de l’électricité en France. https://www.connaissancedesenergies.org/fiche-pedagogique/couts-de-production-de-l-electricite-en-france

[25]Le Monde, AFP. L’arrêté ministériel fixant les tarifs pour la vente de l’électricité nucléaire publié au JORF. 20 mai 2011. https://www.lemonde.fr/economie/article/2011/05/20/l-arrete-ministeriel-fixant-les-tarifs-pour-la-vente-de-l-electricite-nucleaire-publie-au-jo_1524752_3234.html

[26]Commission de Régulation de l’Énergie. Les demandes d’ARENH pour 2019. 29 novembre 2018. https://www.cre.fr/Actualites/Les-demandes-d-ARENH-pour-2019

[27]Assemblée Nationale. Am. n°CD153. 1erjuin 2019.

[28]Assemblée Nationale. Am. n°CE357. 14 juin 2019.

[29]Les Échos. Électricité : comment le Gouvernement veut stabiliser la facture. 18 juin 2019. https://www.lesechos.fr/industrie-services/energie-environnement/electricite-comment-le-gouvernement-veut-stabiliser-la-facture-1029981

[30]Sénat. Am. n°200 rect. bis. 16 juillet 2019.

[31]Le Point. Électricité : ce marché où la concurrence ne marche pas. 16 mai 2019. https://www.lepoint.fr/economie/electricite-ce-marche-ou-la-concurrence-ne-marche-pas-16-05-2019-2313063_28.php

[32]Commission de Régulation de l’Énergie. Délibération de la CRE portant proposition des tarifs réglementés de vente d’électricité. 7 février 2019. https://www.cre.fr/Documents/Deliberations/Proposition/Proposition-des-tarifs-reglementes-de-vente-d-electricite

[33]Transposée en droit français, cette notion a été précisée par le Conseil d’État dans un arrêt de 2015, étant définie comme : « la faculté pour un opérateur concurrent d’EDF de proposer des offres à des prix égaux ou inférieurs aux tarifs réglementés ». Voir CE, juge des référés, 7 janvier 2015, Association nationale des opérateurs détaillants d’énergie (ANODE), n° 386076.

[34]Commission de Régulation de l’Énergie (2018). Marché de détail de l’électricité. https://www.cre.fr/Electricite/Marche-de-detail-de-l-electricite

[35]Légifrance. Loi n°2019-486 du 22 mai 2019 relative à la croissance et la transformation des entreprises.

[36]CE, Ass., 19 juillet 2017, Association nationale des opérateurs détaillants d’énergie (ANODE), n°370321.

[37]CLCV, UFC-Que-Choisir. Lettre ouverte au président de la République. 11 et 12 avril 2019. http://www.clcv.org/images/CLCV/Lettre_ouverte_Emmanuel_Macron_11042019.pdf; https://www.quechoisir.org/action-ufc-que-choisir-hausse-du-tarif-de-l-electricite-au-president-de-la-republique-de-la-court-circuiter-n65619/

[38]CLCV. Hausse du prix de l’électricité : la CLCV et UFC-Que-Choisir vont saisir le Conseil d’État. 15 mai 2019. http://www.clcv.org/energies/hausse-du-prix-de-l-electricite-la-clcv-va-saisir-le-conseil-d-etat-pour-demander-son-annulation.html

[39]RTL. Électricité : « augmenter les tarifs d’EDF pour faire vivre la concurrence ». 31 mai 2019. https://www.rtl.fr/actu/conso/tarifs-de-l-electricite-comment-expliquer-une-telle-hausse-de-5-9-7797743600

[40]Autorité de la concurrence. Avis n°19-A-07 du 25 mars 2019 relatif à la fixation des tarifs réglementés de vente d’électricité.

[41]Le Figaro. Jean-Bernard Lévy: « Des fortunes privées se sont construites sur le dos du parc d’EDF ». 15 mai 2019. http://www.lefigaro.fr/societes/jean-bernard-levy-des-fortunes-privees-se-sont-construites-sur-le-dos-du-parc-d-edf-20190515

[42]BFMTV. Jean-Bernard Lévy : « Tout est organisé pour qu’EDF perde des clients! ». 13 juin 2019. https://bfmbusiness.bfmtv.com/mediaplayer/video/jean-bernard-levy-tout-est-organise-pour-qu-edf-perde-des-clients-1168130.html

[43]IFRAP. Prix de l’électricité : pourquoi ça ne va pas. 25 avril 2019. https://www.ifrap.org/agriculture-et-energie/prix-de-lelectricite-pourquoi-ca-ne-va-pas

[44]Le Monde. Tribune : Henri Guaino : « EDF : vers le démantèlement? ». 8 février 2002. https://www.lemonde.fr/archives/article/2002/02/08/edf-vers-le-demantelement_4209384_1819218.html

[45]Commission européenne (2012). Effets positifs de la politique de concurrence : en quoi la politique de concurrence est-elle importante pour les consommateurs? http://ec.europa.eu/competition/consumers/why_fr.html

[46]Fondation Robert Schuman (2008). Ivoa Alavoine, Thomas Veyrenc : « Idéologie communautaire vs. Réalisme national ? L’épineux problème des tarifs d’électricité ». https://www.robert-schuman.eu/fr/doc/questions-d-europe/qe-95-fr.pdf

[47]Futuribles. Marcel Boiteux : « Les ambiguïtés de la concurrence. Électricité de France et la libéralisation du marché de l’électricité ». 1er juin 2007. https://www.futuribles.com/fr/revue/331/les-ambiguites-de-la-concurrence-electricite-de-fr/

[48]Le Monde Diplomatique. Aurélien Bernier : « Électricité, le prix de la concurrence ». Mai 2018. https://www.monde-diplomatique.fr/2019/05/BERNIER/59843

[49]Voir procédures d’infraction susmentionnées, engagées par la Commission européenne à l’encontre de la République Française.

[50]Dans la théorie économique néoclassique, le principe de concurrence pure et parfaite n’admet pas que des acteurs privés de l’offre bénéficient de situation de rentes de profitabilité, qui sont considérées comme un élément de concurrence déloyale et un coin (« wedge ») dans la réalisation de l’équilibre de marché. Voir : Union Européenne – Europa EU (2019). Concurrence : préserver et promouvoir des pratiques de concurrence loyale. https://europa.eu/european-union/topics/competition_fr

[51]La Documentation Française. État, marché et concurrence : les motifs de l’intervention publique. In Concurrence et régulation des marchés. Cahiers français n°313. https://www.ladocumentationfrancaise.fr/var/storage/libris/3303330403136/3303330403136_EX.pdf

[52]Paul de Grauwe (2015). Les limites du marché : l’oscillation entre l’État et le capitalisme. Préfacé par Jean-Paul Fitoussi. Bruxelles. De Boeck Supérieur.

[53]Financial Times. The Limits of the Market by Paul de Grauwe — from excess to redress. 7 avril 2017. https://www.ft.com/content/6e07ebe2-19eb-11e7-bcac-6d03d067f81f

[54]Confère l’expression « market failure » employée par Yves Croissant et Patricia Vornetti, économistes enseignant à l’Université de la Réunion et à l’Université Paris-I Panthéon-Sorbonne. Voir : La Documentation Française. État, marché et concurrence : les motifs de l’intervention publique. In Concurrence et régulation des marchés. Cahiers français n°313. https://www.ladocumentationfrancaise.fr/var/storage/libris/3303330403136/3303330403136_EX.pdf

[55]Ibid.

[56]Stanford University – Stanford CS (1996). Rise of Monopolies: the development of the railroad monopoly in the United States. In Andy Conigliaro, Joshua Elman, Jeremy Schreiber, Tony Small: « The danger of corporate monopolies ».

[57]The Commonwealth Club of California. Harvard University Professor Tim Wu: Inside Tech Monopolies. San Francisco. 22 février 2019. https://www.youtube.com/watch?v=pQVRP3-8yhQ

[58]The New Yorker. Opinion: Tim Wu: « The Oligopoly Problem ». 15 avril 2013. https://www.newyorker.com/tech/annals-of-technology/the-oligopoly-problem

[59]The New York Times. The Opinion Section: Tim Wu: « Be Afraid of Economic Bigness. Be Very Afraid. 10 novembre 2018. https://www.nytimes.com/2018/11/10/opinion/sunday/fascism-economy-monopoly.html?login=facebook

[60]The Washington Post. Opinion: Felicia Wong: « Why monopolies are threatening American democracy ». 8 décembre 2017. https://www.washingtonpost.com/news/democracy-post/wp/2017/12/08/why-monopolies-are-threatening-american-democracy/?noredirect=on&utm_term=.41c2a742748c

[61]The Washington Post. Opinion: Tim Wu: « A call to save democracy by battling private monopolies ». 28 décembre 2018. https://www.washingtonpost.com/gdpr-consent/?destination=%2foutlook%2fa-call-to-save-democracy-by-battling-monopolies%2f2018%2f12%2f27%2f949cf8f4-06fe-11e9-a3f0-71c95106d96a_story.html%3f&utm_term=.6d7239a41cd1

[62]Jean-Pierre Hansen, Jacques Percebois (2017). Transition(s) électrique(s). Ce que l’Europe et les marchés n’ont pas su vous dire. Préfacé par Gérard Mestrallet. Paris. Odile Jacob.

[63]The Atlantic. The Return of the Monopoly: An Infographic. April 2013. https://www.theatlantic.com/magazine/archive/2013/04/the-chartist/309271/

[64]The Guardian. Joseph Stiglitz: The new era of monopoly is here. 13 mai 2016. https://www.theguardian.com/business/2016/may/13/-new-era-monopoly-joseph-stiglitz

[65]Stanford University – Stanford CS (1996). Rise of Monopolies: the making of Microsoft. In Andy Conigliaro, Joshua Elman, Jeremy Schreiber, Tony Small: « The danger of corporate monopolies ».

[66]The London School of Economics – LSE Blog. Patrick Barwise: « Why tech markets are winner-take-all ». 14 juin 2018. https://blogs.lse.ac.uk/mediapolicyproject/2018/06/14/why-tech-markets-are-winner-take-all/

[67]The New York Times. The opinion section: David Leonhardt: « The monopolization of America ». 25 novembre 2018. https://www.nytimes.com/2018/11/25/opinion/monopolies-in-the-us.html

[68]Robert Reich. The monopolization of America ». 6 mai 2018. https://www.youtube.com/watch?v=KLfO-2t1qPQ

[69]La Documentation Française. État, marché et concurrence : les motifs de l’intervention publique. In Concurrence et régulation des marchés. Cahiers français n°313. https://www.ladocumentationfrancaise.fr/var/storage/libris/3303330403136/3303330403136_EX.pdf

[70]Frank P. Ramsey (1927). A contribution to the Theory of Taxation. The Economic Journal. Vol. 37, n°145.

[71]Marcel Boiteux (1956). Sur la gestion des monopoles publics astreints à l’équilibre budgétaire. Econometrica, n°24.

[72]Observatoire de l’Industrie électrique (2017). Une histoire de la péréquation tarifaire. https://observatoire-electricite.fr/IMG/pdf/oie_-_fiche_pedago_perequation_072017.pdf

[73]Légifrance. Loi n°2000-108 du 10 février 2000 relative à la modernisation et au développement du service public de l’électricité. https://www.legifrance.gouv.fr/affichTexte.do?cidTexte=JORFTEXT000000750321

[74]France Stratégie. 2017/2027 – Dynamiques et inégalités territoriales. 7 juillet 2016. https://www.strategie.gouv.fr/publications/20172027-dynamiques-inegalites-territoriales

[75]Pierre Veltz (1996). Mondialisation, villes et territoires. L’économie d’archipel. Paris. Presses Universitaires de France.

[76]The Atlantic (2005). Richard Florida: « The World in numbers: The World is spiky ». https://www.theatlantic.com/past/docs/images/issues/200510/world-is-spiky.pdf

[77]Médiateur National de l’Énergie (2018). Rapport annuel d’activité 2018. https://www.energie-mediateur.fr/wp-content/uploads/2019/05/RA-MNE-2018-interactif.pdf

[78]Marianne. Électricité : l’hérésie de l’ouverture à la concurrence. 1erjuillet 2017. https://www.marianne.net/debattons/tribunes/energie-electricite-edf-heresie-concurrence

[79]Ibid.

[80]Arthur Cecil Pigou (1920). The Economics of Welfare. London. Macmillan.

[81]International Monetary Fund. Thomas Helbling : « Externalities: Prices Do Not Capture All Costs ». 18 décembre 2018. https://www.imf.org/external/pubs/ft/fandd/basics/external.htm

[82]Paul de Grauwe (2015). Les limites du marché : l’oscillation entre l’État et le capitalisme. Préfacé par Jean-Paul Fitoussi. Bruxelles. De Boeck Supérieur.

[83]OCDE (2003). Électricité nucléaire : quels sont les coûts externes ? https://www.oecd-nea.org/ndd/reports/2003/nea4373-couts-externe.pdf

[84]Institut de Radioprotection et de Sûreté Nucléaire (2013). Quelle est la durée de vie d’un déchet radioactif à haute activité ? https://irsn.libcast.com/dechets/dechets_quelle_est_la_duree_de_vie_d_un_dechet_radioactif_a_haute_activite-mp4/player

[85]Greenpeace (2019). Quel est l’impact environnemental des panneaux solaires ? https://www.greenpeace.fr/impact-environnemental-solaire/

[86]Elinor Ostrom (1990). Governing the commons: The evolution of institutions for collective action. Cambridge University Press. https://wtf.tw/ref/ostrom_1990.pdf

[87]Garrett Hardin (2018). La tragédie des communs. Préfacé par Dominique Bourg. Presses Universitaires de France.

[88]Observatoire National de la Précarité Énergétique. Tableau de bord de la précarité énergétique, édition 2018. 6 mai 2019. https://onpe.org/sites/default/files/tableau_de_bord_2018_v2_1.pdf

[89]INSEE Dossier Grand-Est, n°10. Vulnérabilité énergétique dans le Grand Est. Le Grand Est, région la plus touchée par la vulnérabilité énergétique pour se chauffer. 25 janvier 2019. https://www.insee.fr/fr/statistiques/3703441

[90]INSEE Flash Bourgogne, n°31. Un ménage sur trois exposé à la vulnérabilité énergétique en Bourgogne-Franche-Comté. 15 décembre 2015. https://www.insee.fr/fr/statistiques/1304080

[91]Alain Supiot (2010). L’esprit de Philadelphie : la justice sociale face au marché total. Paris. Seuil.