Chaque jour, des milliards de données sont extraites de nos outils digitaux et réutilisées par les géants du numérique à des fins de ciblage publicitaire. La critique de ce capitalisme de surveillance a été popularisé dans les médias, notamment par Shoshana Zuboff, professeur émérite à la Harvard Business School, et auteur d’un ouvrage éponyme. Elle dénonce inlassablement les dangers que font courir les GAFAM sur l’autonomie des citoyens. Mais faut-il s’indigner de la soif insatiable de Google ou d’Amazon pour les données personnelles ? Ou simplement y voir la conséquence prévisible de l’extension du capitalisme vers de nouveaux marchés ? Evgeny Morozov, auteur de nombreux ouvrages consacrés au numérique (dont Le mirage numérique : Pour une politique des big data, publié en 2015), répond à Shoshana Zuboff dans cet article.

Si l’utilisation par Zuboff de l’expression « capitalisme de surveillance » est apparue pour la première fois en 2014, les origines de sa critique remontent plus loin. On peut en trouver la trace dès la fin des années 1970, à l’époque où Zuboff commençait à étudier l’impact des technologies de l’information sur les lieux de travail – un projet de quarante ans qui, en plus de donner lieu à de nombreuses publications, l’a également nourrie d’espoirs utopiques et de déceptions amères. Le décalage entre le possible et le réel a informé le contexte intellectuel dans lequel Zuboff – auparavant prudemment optimiste à la fois sur le capitalisme et la technologie – a construit sa théorie du capitalisme de surveillance, l’outil le plus sombre et le plus dystopique de son arsenal intellectuel à ce jour.

De la naïveté à l’indignation : les promesses déçues du capitalisme numérique

Les conclusions déprimantes de son dernier livre sont très éloignées de ce que la même Zuboff écrivait il y a seulement dix ans. En 2009 encore, elle affirmait que des sociétés comme Amazon, eBay et Apple « libéraient des quantités massives de valeur en donnant aux gens ce qu’ils voulaient, selon leurs propres conditions et dans leur propre espace ». Mme Zuboff est arrivée à ce lumineux diagnostic grâce à son analyse globale de la manière dont les technologies de l’information modifiaient la société. À cet égard, elle faisait partie d’une cohorte de penseurs qui soutenaient qu’une nouvelle ère – que certains qualifiaient de « post-industrielle », d’autres de « postfordiste » – était à nos portes.

« Le calcul prend le pas sur la vie politique de la communauté comme base de la gouvernance », conclut Zuboff. Au lieu de fonder un journal fasciste, un Benito Mussolini contemporain serait probablement en train de courir après le capital-risque, de créer des applications et de se lancer dans la maîtrise de l’art martial du piratage de la croissance…”

C’est de cette analyse – et des attentes initialement positives qu’elle a engendrées – qu’est née la critique contemporaine de Zuboff sur le capitalisme de surveillance. C’est également à partir d’elle que l’on comprend pourquoi son dernier livre s’aventure souvent, tant sur le plan du contenu que du langage, sur le terrain du mélodrame : Zuboff, à l’unisson de l’ensemble de la classe dirigeante américaine, assoiffée par les promesses de la nouvelle économie, s’attendait à ce que quelque chose de très différent se profile à l’horizon.

Son premier livre, In the Age of the Smart Machine, publié en 1988, a été bien accueilli. Zuboff y déployait un appareil conceptuel et une série de questions qui allaient refaire surface dans tous ses écrits ultérieurs. S’appuyant sur un travail ethnographique de plusieurs années dans l’industrie et les bureaux, le livre prévoit un avenir ambigu. Selon Zuboff, la technologie de l’information pourrait exacerber les pires caractéristiques de l’automatisation, priver les travailleurs de leur autonomie et les condamner à des tâches indignes. Mais utilisée à bon escient, elle pourrait avoir l’effet inverse : renforcer la capacité des travailleurs en matière de pensée abstraite et imaginative et inverser le processus de déqualification décrié par de nombreuses critiques marxistes du travail sous le capitalisme.

Avec les technologies de l’information, les entreprises modernes ont dû choisir, selon Zuboff, entre « automatiser » et « informer ». Ce dernier terme renvoie à leur capacité, nouvellement acquise, à rassembler des données – le « texte électronique » – liées au travail sur ordinateur. Sous l’ère antérieure de la direction scientifique de Frederick W. Taylor [à l’origine du taylorisme NDLR], ces données étaient recueillies manuellement, par l’observation et l’étude du temps et des mouvements. En extrayant les connaissances tacites des travailleurs sur le processus de travail, les gestionnaires, aidés par les ingénieurs, pouvaient le rationaliser, ce qui réduisait considérablement les coûts et augmentait le niveau de vie.

Grâce aux progrès des technologies de l’information, la rédaction du « texte électronique » devenait bon marché et omniprésente. Si ce texte était mis à la disposition des travailleurs, il pourrait même saper le fondement du contrôle managérial, fondé sur la croyance selon laquelle le manager est « celui qui sait le mieux ». Le « texte électronique » a engendré ce que Zuboff, à la suite de Michel Foucault, a décrit comme un « pouvoir panoptique ». Issu des pratiques autoritaires de l’ancien lieu de travail fortement centralisé, ce pouvoir était susceptible de renforcer les hiérarchies existantes ; les cadres se cachaient derrière les chiffres et gouvernaient à distance, au lieu de se risquer aux aléas de la communication personnelle. S’il s’accompagnait d’une structure démocratique sur le lieu de travail et d’une égalité dans l’accès au « texte électronique », ce pouvoir pourrait toutefois permettre aux travailleurs de contester les interprétations que les dirigeants font de leurs propres activités et de s’approprier un certain pouvoir institutionnel.

À l’ère de la machine intelligente, un livre sur l’avenir du travail et aussi, inévitablement, sur son passé, était ainsi remarquablement silencieux sur le capitalisme. Si l’on passe outre sa vaste bibliographie, cet ambitieux tome de près de cinq cents pages ne mentionne le mot « capitalisme » qu’une seule fois, par l’entremise d’une citation de Max Weber. Cela ne peut que surprendre, étant donné que Zuboff ne faisait nullement l’apologie des entreprises qu’elle étudiait. Elle ne se faisait aucune illusion sur la nature autoritaire du lieu de travail moderne, qui constituait rarement un espace de réalisation de soi pour les travailleurs, et elle prenait plaisir à s’attaquer aux managers égocentriques et avides de pouvoir.

En dépit de ces occasionnelles remarques critiques, c’est autour du savoir et de son rôle dans la perpétuation ou l’affaiblissement des hiérarchies organisationnelles que Mme Zuboff a structuré son cadre analytique. La propriété privée, la classe sociale, la propriété des moyens de production – les éléments qui structuraient les conflits autrefois liés au travail – ont été pour la plupart exclus de sa grille de lecture. Après tout, l’objectif de l’étude était de comprendre l’avenir du lieu de travail tel qu’il est médiatisé par les technologies de l’information. L’approche ethnographique de Zuboff était davantage adaptée pour interroger les managers et les travailleurs sur ce qui les séparait, que pour esquisser les impératifs économiques qui reliaient chaque entreprise à l’ensemble de l’économie mondiale. Ainsi, la machine intelligente imaginée par Zuboff fonctionnait largement en-dehors des contraintes invisibles que le capitalisme imposait aux dirigeants et aux propriétaires.

Alors que le « capital » voyait sa propriété s’accroître – le livre l’a mentionné une douzaine de fois -, Zuboff ne l’a pas perçu, à l’instar des marxistes, comme une relation sociale ou l’éternel antagoniste du travail. Au lieu de cela, elle a marché dans les pas des économistes néoclassiques en le considérant comme une machine – ou de l’argent – lié à des investissements. Le « travail », à son tour, était surtout traité comme une activité physique. Bien que Zuboff ait également mentionné le rôle historique des syndicats, ses lecteurs ne saisiront pas nécessairement le caractère antagoniste du « travail » et du « capital » – au lieu de cela, ils entendent surtout parler de conflits situationnels au sein des lieux de travail individuels, entre travailleurs et managers.

Cela n’est guère surprenant : Zuboff n’est pas marxiste. En outre, elle aspirait à devenir professeur à la Harvard Business School. Cependant, son plaidoyer en faveur de lieux de travail plus équitables et plus dignes suggère qu’elle pourrait être, au moins sur certaines questions, un compagnon de route pour les causes progressistes. Ce qui la distinguait des voix les plus radicales dans ces débats était son insistance constante sur les effets ambigus des technologies de l’information. Le choix entre « automatiser » et « informer » n’était pas seulement un sous-produit analytique de son cadre de travail ou un simple accessoire rhétorique. Elle l’a plutôt présenté comme un choix réel, existentiel, auquel sont confrontées les entreprises modernes aux prises avec la technologie de l’information.

De tels choix binaires – entre « capitalisme réparti» (distributed capitalism) et « capitalisme managérial » (managerial capitalism), entre « capitalisme d’information » (advocacy-oriented capitalism) et « capitalisme de surveillance » (surveillance capitalism) – animeront également les livres ultérieurs de Zuboff. Mais même à ce stade précoce, il n’est pas clair qu’elle ait été justifiée à faire le saut analytique consistant, sur la base d’observations ethnographiques en vertu desquelles certaines entreprises étaient effectivement confrontées au choix entre « informer » et « automatiser », de conclure plus largement que les conditions extérieures du capitalisme moderne high-tech universalisaient ce choix pour toutes les entreprises, ce qui représente une nouvelle étape dans le développement capitaliste lui-même.

Amazon et Google ont-ils trahi leurs fondements originels ?

Acceptée telle quelle, la possibilité d’un choix entre « automatiser » et « informer » a sapé les critiques traditionnelles du capitalisme en tant que système d’exploitation structurelle (et donc inévitable) ou de déqualification. Dans la nouvelle ère numérique de Zuboff, une alliance agile et harmonieuse entre travailleurs et managers pourrait permettre à des entreprises intelligentes et éclairées de libérer le pouvoir émancipateur de « l’information ».

Nous pourrions ici entrevoir les contours plus larges de l’approche de Zuboff à l’égard du capitalisme : ses maux, dont elle reconnaît bien volontiers l’existence de certains, ne sont pas le sous-produit inévitable de forces systémiques, telles que la quête de profit. Ils sont plutôt la conséquence évitable de certaines dispositions organisationnelles particulières qui, bien qu’ayant été utilisées à des époques antérieures, peuvent maintenant être rendues obsolètes par les technologies de l’information. Cette conclusion pleine d’espoir a été tirée presque entièrement de l’observation des entreprises capitalistes, car le capitalisme lui-même – considéré comme une structure historique, et non comme une simple agrégation d’acteurs économiques – était dans son ensemble absent de l’analyse.

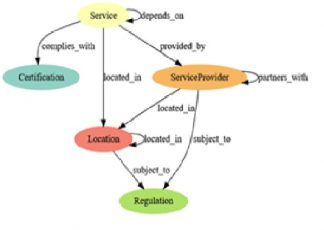

La clef de la dernière théorie de Zuboff sur le capitalisme de surveillance est la notion de « surplus comportemental » (behavioral surplus), un raffinement de l’expression plus vulgaire « d’épuisement des données » utilisé par beaucoup dans l’industrie technologique. Elle renvoie à la distinction entre « information » et « automatisation » exposée dans son premier livre. Rappelons que le « texte électronique », qui renaît dans le dernier livre sous le nom de « texte fantôme », a une valeur immense pour différents acteurs, souvent antagonistes. Lorsque certaines entreprises l’utilise pour donner du pouvoir aux consommateurs – comme le fait, par exemple, Amazon avec des recommandations de livres tirées des achats de millions de clients – le texte électronique suit la voie idyllique de l’information, alimentant ce que Zuboff appelle le « cycle de réinvestissement comportemental ». Lorsque les entreprises technologiques utilisent les données extraites pour cibler les publicités et modifier le comportement, elles créent un « surplus comportemental » – et cette percée clé crée un « capital de surveillance ».

Google constitue un archétype pour la théorie de Zuboff. Au cours de ses premières années d’existence, alors qu’il avait encore besoin d’un modèle commercial, Google avait du potentiel pour devenir l’entreprise favorite de Zuboff, au service du « capitalisme d’information » : sa seule motivation pour recueillir des données était l’amélioration du service. Une fois qu’elle a adopté la publicité personnalisée, les choses ont changé. Aujourd’hui, Google souhaite davantage de données sur les utilisateurs pour vendre des annonces, et pas seulement pour améliorer les services. Les données que cette plateforme recueille au-delà du besoin objectivement déterminé de servir les utilisateurs – un seuil important que L’ère du capitalisme de surveillance introduit mais ne théorise jamais explicitement – constituent le « surplus comportemental » de Zuboff. En tant qu’entreprise capitaliste, Google veut maximiser ce surplus, en l’élargissant en profondeur – en pénétrant toujours plus profondément dans les données de nos âmes et de nos ménages – mais aussi en largeur, en offrant de nouveaux services dans de nouveaux domaines et en diversifiant ses « actifs de surveillance ».

Sur plus de sept cents pages, Zuboff décrit ce « cycle de dépossession » dans toute son ignominie : nous sommes régulièrement volés, nos expériences enlevées et expropriées, nos émotions pillées, par des « mercenaires de la personnalité ». Elle dépeint avec force l’insupportable « engourdissement psychique » induit par les capitalistes de surveillance. Oubliez le cliché selon lequel si c’est gratuit, « vous êtes le produit », exhorte-t-elle. « Vous n’êtes pas le produit, vous êtes la carcasse abandonnée. Le produit provient du surplus qui est arraché à votre vie ». Le pire, cependant, est encore à venir, affirme-t-elle, alors que les géants de la technologie passent de la prédiction du comportement à l’ingénierie. « Il ne suffit plus d’automatiser les flux d’informations nous concernant », prévient-elle ; « le but est maintenant de nous automatiser ».

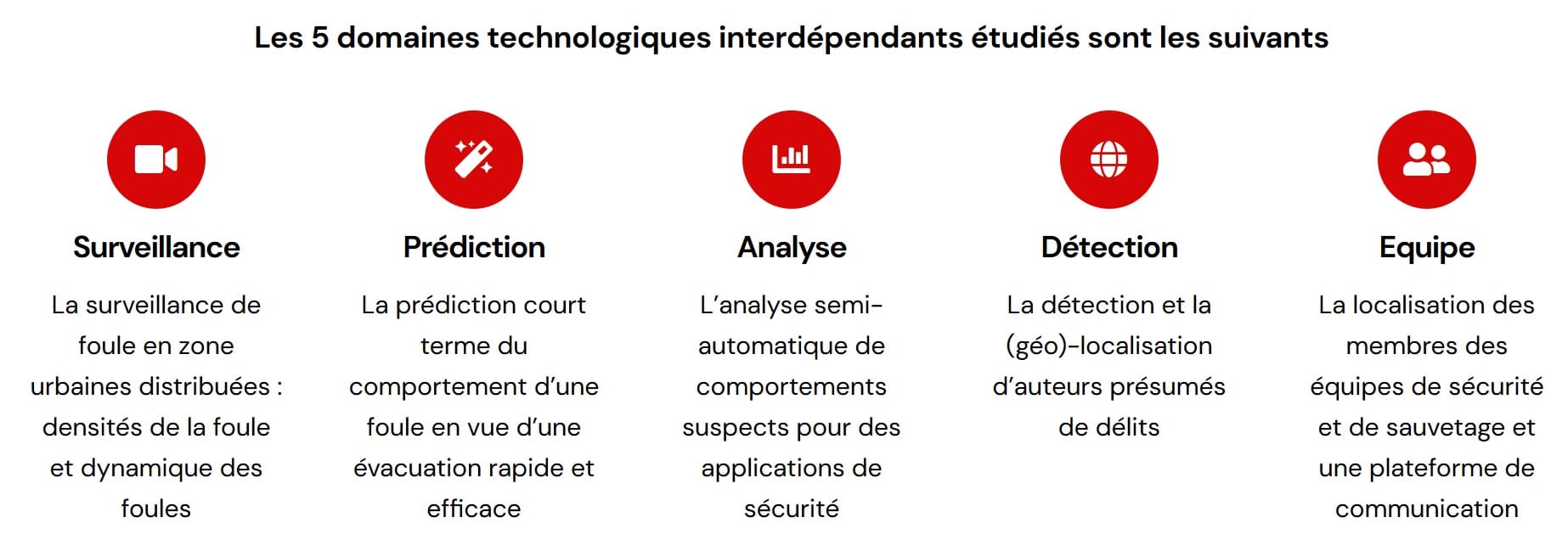

Cette nouvelle infrastructure mondiale destinée à la manufacture des comportements produit une « puissance instrumentale », car la « puissance panoptique » du premier livre de Zuboff transcende les murs de l’usine et pénètre l’ensemble de la société. Contrairement au pouvoir totalitaire, il évite la violence physique ; inspiré par les idées comportementalistes brutales de B.F. Skinner, il nous conduit plutôt vers les résultats souhaités (pensez aux compagnies d’assurance qui font payer des primes plus élevées aux clients les plus risqués). « Le calcul prend le pas sur la vie politique de la communauté comme base de la gouvernance », conclut Zuboff. Au lieu de fonder un journal fasciste, un Benito Mussolini contemporain serait probablement en train de courir après le capital-risque, de créer des applications et de se lancer dans la maîtrise de l’art martial du piratage de la croissance.

Zuboff choisit de se battre, rejetant la responsabilité de cette « tyrannie » émergente sur les intellectuels de la Silicon Valley, une étrange bande d’idiots utiles et d’entrepreneurs véreux hauts perchés sur des institutions quasi-académiques comme le Media Lab du MIT. Nommer ce système de destruction des âmes pour ce qu’il est, affirme-t-elle, est la condition préalable à une contre-stratégie efficace, car « sa normalisation nous laisse chanter dans nos chaînes ». Ce n’est pas une mince affaire, car le pouvoir idéologique exercé par le Big Tech – avec ses groupes de réflexion, ses lobbyistes, ses conférences technologiques – est immense.

Les débats politiques actuels, cependant, ne parviennent pas à saisir la dimension systémique du problème, selon elle. Qu’importe que notre comportement soit modifié par deux « capitalistes de la surveillance » ou une dizaine. Insister sur « le cryptage avancé, l’amélioration de l’anonymat des données ou la propriété des données » est une erreur, affirme Zuboff, car « de telles stratégies ne font qu’avaliser le caractère inévitable de la surveillance commerciale ».

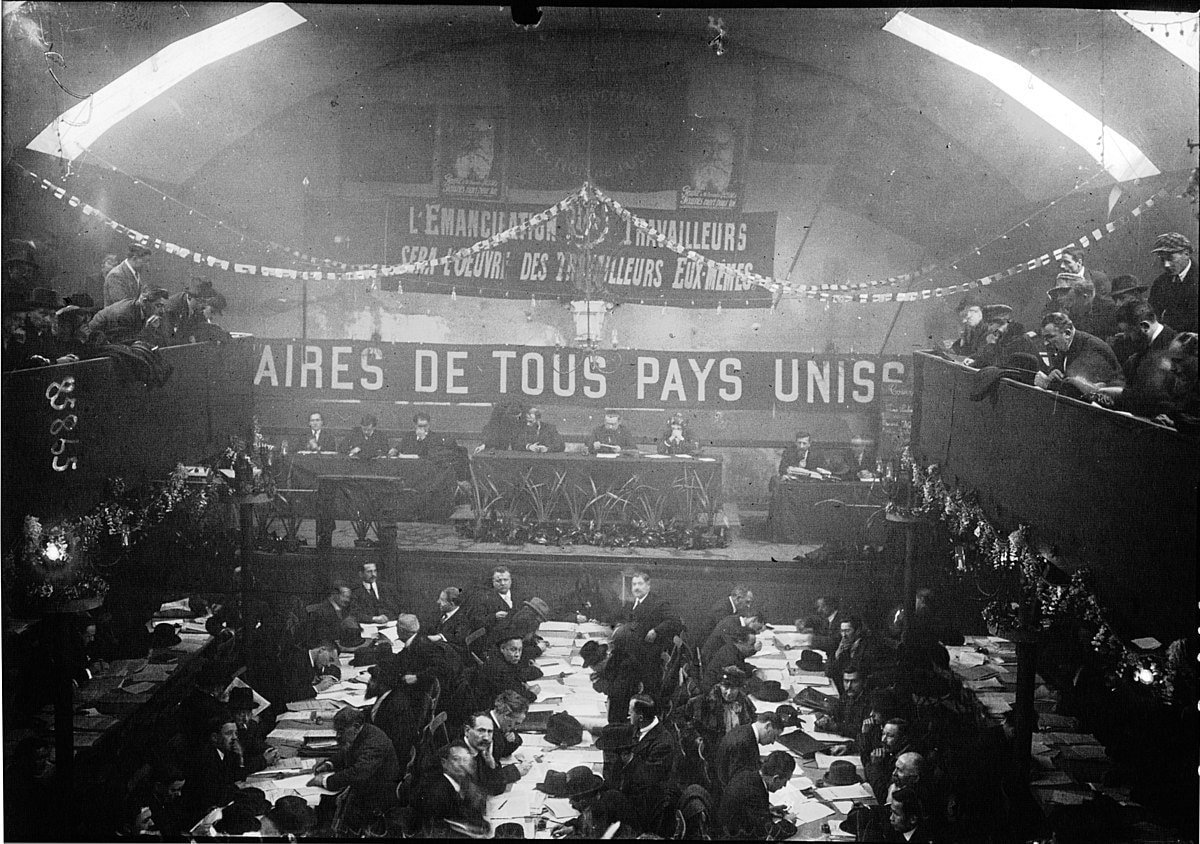

Zuboff propose néanmoins un certain nombre d’issues politiques, reproduisant la demande de son précédent livre pour un « droit de sanctuaire » (right to sanctuary), insistant également sur un droit au « futur ». Le droit de l’Europe à être oubliée – qui permet aux utilisateurs de demander que des informations périmées ou erronées disparaissent des résultats de recherche – s’inscrit dans cette perspective. Zuboff espère également qu’un nouveau mouvement social fera pression pour des institutions démocratiques plus fortes et veillera à ce que l’expérience humaine ne soit pas réduite à une « marchandise fictive » – comme les précédents « doubles mouvements », décrits par Karl Polanyi dans La grande transformation, qui ont remis en question la marchandisation du travail, de la terre et de l’argent. Les capitalistes éclairés, comme Apple, feraient le reste.

Les présupposés de base de l’argumentation de Zuboff peuvent maintenant être énoncés plus explicitement : le « capitalisme managérial », cimenté par un pacte social entre les capitalistes et la société a eu son utilité, mais au début des années 2000, il était temps d’essayer quelque chose de nouveau. Le « capitalisme réparti » – imaginé comme un « capitalisme d’information » dans son dernier livre – en était l’héritier naturel. Apple aurait pu être le fer de lance d’un nouveau pacte social, mais elle a échoué dans cette mission. Google, à son tour, a bénéficié des inquiétudes liées aux données de l’après-11 septembre, tandis que des décennies de victoires du néolibéralisme lui ont permis d’éviter la réglementation.

“Zuboff semble identifier l’extraction de données et la modification des comportements non pas comme des conséquences de la concurrence capitaliste, mais comme les causes sous-jacentes qui propulsent l’émergence du nouvel ordre économique (…) Elle augure une révolution copernicienne, Mais qui repose sur des fondements assez délicats.”

Alors que le capitalisme de surveillance sur le capitalisme d’information, un double mouvement devrait émerger pour créer les conditions institutionnelles qui permettraient à l’apple-isme de combler les espaces politiques et économiques laissés vacants par le fordisme.

Quête d’efficacité contre quête de maximisation du taux de profit comme moteurs du capitalisme

Avant d’évaluer la validité et l’importance de ces arguments, il est important de se rappeler ce qu’ils doivent au cadre conceptuel d’Alfred Chandler [historien américain, qui s’est attaché à l’étude de l’organisation au sein de l’entreprise, et aux moyens de maximiser son efficacité NDLR]. Le récit de Zuboff est cohérent parce qu’il est capable de poser l’existence de trois régimes différents, chacun avec son propre ensemble d’impératifs et d’économies distincts. Ces régimes décrivent les opérations des grands acteurs économiques : General Motors et Ford dans le cas du « capitalisme managérial » ; Google et Facebook dans le cas du « capitalisme de surveillance » ; Apple et l’Amazon d’avant Alexa dans le cas du « capitalisme d’information ».

En elles-mêmes, cependant, ces descriptions ont peu d’importance, car nous pouvons trouver de nombreuses autres façons de lire la réalité économique et politique. Le cadre de Chandler, fondé sur des explications fonctionnalistes, n’admet pas facilement l’existence de récits alternatifs. Son pouvoir explicatif aigu découle en partie de la posture de fonctionnalisme omniscient qu’il s’est lui-même imposée. Les chandleriens ne se donnent pas souvent la peine de chercher des explications alternatives, ne serait-ce que pour les rejeter comme étant inexactes. Par conséquent, les questions importantes qui déterminent normalement le choix des schémas explicatifs – le cadre analytique choisi explique-t-il mieux la réalité que les autres solutions ? a-t-il un grand pouvoir prédictif ? sont rarement posées.

Ainsi, les lecteurs de The Age of Surveillance Capitalism chercheront, en vain, le point de vue de Zuboff sur le « capitalisme de plateforme », le « capitalisme cognitif » ou le « biocapitalisme » – quelques-unes des méthodes alternatives bien établies pour encadrer le même ensemble de problèmes historiques et politiques. Que ces cadres rivaux n’expliquent pas le « capitalisme de surveillance » tel que Zuboff le définit est évident ; qu’ils ne décrivent pas certains des mêmes phénomènes qu’elle regroupe sous cette étiquette l’est beaucoup moins. Et pourtant, la discussion de Zuboff sur les explications alternatives n’arrive jamais. Sept cents pages n’ont pas dû suffire…

Le même problème se posait dans ses livres précédents. The Support Economy ne fait pas mention des débats de longue date sur le post-fordisme (un terme qui n’apparaît jamais dans le livre lui-même). In the Age of the Smart Machine, de même, ignore les critiques de l’automatisation ainsi que les nombreuses suggestions pour utiliser les technologies de l’information de manière plus humaine et non-automatique – des suggestions qui avaient déjà été faites par la discipline désormais oubliée de la cybernétique de gestion. Zuboff travaille dans un style très différent : elle expose ce qu’elle croit être un phénomène unique, en le décrivant en profondeur, mais sans construire de ponts (ne serait-ce que pour les brûler) vers des conceptions alternatives de ce même phénomène.

Le monde a-t-il besoin d’un nouveau Chandler pour comprendre la transformation du capitalisme à l’ère numérique ? Si oui, Zuboff est un candidat de premier plan. Mais les grands courants de changement historique indiquent clairement que nous avons plutôt moins besoin de Chandler. Le cadre chandlerien, malgré toutes ses intuitions analytiques, est structurellement aveugle aux relations de pouvoir – le résultat de son manque de curiosité inné envers les explications non fonctionnalistes. Ceci, à son tour, limite les possibilités pour les chandleriens de déceler les impératifs souvent tacites mais fatalement imposés par le système capitaliste. Par conséquent, toutes ces théories – « capitalisme managérial », « capitalisme d’information », « capitalisme de surveillance » – ont beaucoup à dire sur chacun des adjectifs qui les qualifient, mais sont muettes sur les questions relatives au capitalisme lui-même, le réduisant généralement à quelque chose de relativement banal, comme le fait qu’il existe des marchés, des marchandises et, occasionnellement, des pactes sociaux entre les capitalistes et le reste de la société.

La réception de l’œuvre de Chandler est éloquente. Pour ses détracteurs, le récit de Chandler sur le « capitalisme managérial » n’était qu’un conte de fées savamment élaboré, qui permettait aux élites américaines de légitimer leur pouvoir par des mythes rivalisant avec ceux qui jaillissent aujourd’hui de la Silicon Valley. Chandler a loué les cadres américains, les champions présumés de l’efficacité, pour avoir servi non pas les intérêts du capital, mais ceux de la société. Zuboff a avalisé d’importants aspects du récit de Chandler, n’ergotant que sur la durabilité du capitalisme managérial face au changement technologique, ses conséquences sur le monde intérieur des consommateurs et sa culture organisationnelle hautement sexiste, narcissique et hiérarchique.

Les critiques de Chandler, en revanche, l’ont accusé du crime méthodologique consistant à inverser la causalité de l’explication historique. Ce qui a motivé l’expansion de l’industrie américaine, c’est la recherche du profit et du pouvoir, et non la recherche de l’efficacité ; cette dernière, là où elle s’est produite, découlait seulement de la première. Centrées sur la rentabilité à long terme, les entreprises ont essayé de gagner des parts de marché par des pratiques anticoncurrentielles, telles que les rabais, les ristournes et les contrats d’exclusivité. Les prix bas ont été obtenus non seulement ou même principalement grâce à l’efficacité, mais aussi en externalisant les coûts de production sur la société (par exemple la pollution), en supprimant les droits des travailleurs et en faisant obstacle aux modes alternatifs non commerciaux d’organisation sociale.

Pour les critiques, la principale question n’est pas de savoir si les mains de la coordination sociale sont visibles (à la Chandler) ou invisibles (à la Adam Smith), mais plutôt si elles sont sales. Et, pour la plupart, elles l’étaient – surtout lorsqu’il s’agissait d’obtenir un approvisionnement continu en matières premières de l’étranger. Dans ce contexte, les odes de Chandler au capitalisme managérial n’étaient que l’envers des théories du sous-développement avancées par les économistes critiques en Amérique latine : le bon fonctionnement du capitalisme managérial américain s’est fait au prix d’un dysfonctionnement et d’un retard de développement de nombreuses économies étrangères. Ces économies sont devenues de simples appendices du système de production américain, incapables de développer leur propre industrie.

Le désaccord le plus important portait sur la question de savoir qui construisait le capitalisme managérial. Pour Chandler, c’était l’attrait du développement technologique exogène et les impératifs de la société de masse. Pour ses critiques – qui préféraient des termes comme « libéralisme d’entreprise » – ce sont les capitalistes qui, trouvant des alliés dans l’appareil d’État, ont piégé les technologies ouvertes dans des programmes d’entreprise étroits. Les managers étaient la conséquence, et non la cause, de ces développements.

Zuboff, tout comme Chandler, n’avait pas à s’engager pleinement dans de telles critiques, elle pouvait se permettre d’être nostalgique des « réciprocités constructives producteurs-consommateurs » du capitalisme managérial dans ses travaux antérieurs. Elle n’était pas étrangère à la thèse du « libéralisme d’entreprise », citant même Martin Sklar, l’un de ses principaux partisans, dans The Support Economy. Et pourtant, elle n’a pas fait usage de ces critiques. Au lieu de cela, elle a continué à voir le capitalisme de gestion comme un compromis gagnant-gagnant entre les consommateurs, les travailleurs et les producteurs ; un compromis cimenté par des institutions démocratiques mais, malheureusement, toujours dépourvu de possibilités d’épanouissement individuel.

Une comptabilité complète des méthodes et des coûts du capitalisme managérial doit cependant regarder au-delà de l’axe consommateur-producteur-travailleur. Qu’est-ce que cela signifie pour les relations interculturelles, la structure familiale, l’environnement et le reste du monde ? Qu’en est-il de l’autodétermination des individus en dehors du marché ? Le régime qui lui succédera, qu’il soit fondé sur la défense des droits ou la surveillance, ne devrait-il pas être évalué sur cette échelle de coûts potentiels beaucoup plus grande ? Ces considérations supplémentaires n’entrent cependant jamais vraiment en ligne de compte, car la teneur fonctionnaliste globale de l’argument dicte déjà les critères mêmes sur lesquels l’attrait du nouveau régime doit être évalué.

Extraction des données, modification des comportements : la cause et la conséquence

Après ce prélude assez long – cet article aspire à rivaliser avec le livre en termes de prolixité ! – il est temps d’examiner dans quelle mesure le récit de Zuboff sur le capitalisme de surveillance tient la route en tant que théorie. L’un des avantages non avoués d’opérer dans le cadre de Chandler est que, si Zuboff réussit la tâche qu’elle s’est tacitement fixée, son livre produira un modèle analytique solide qui éclairera toutes les interprétations ultérieures de l’économie numérique. C’est, après tout, ce qui est arrivé à Chandler : son cadre est devenu le modèle dominant, bien que parfois contesté, pour penser l’ère de la production de masse.

Zuboff, cependant, ne déclare pas explicitement qu’elle propose un modèle analytique d’une ambition intellectuelle aussi vaste ; elle fait à peine mention de Chandler. En fait, elle laisse toujours la porte ouverte à une interprétation différente et se contente d’illustrer la bataille destructrice pour les données numériques dans le monde qui se déroule actuellement entre des entreprises telles que Google et Facebook, avec comme dommage collatéral l’autonomie des consommateurs individuels. Une explication détaillée des mouvements et des considérations tactiques qui façonnent cette bataille l’amène à introduire un phénomène appelé « capitalisme de surveillance », mais les ambitions théoriques de ce concept, selon l’interprétation actuelle, sont très modestes.

“Les récentes révélations sur les pratiques de partage de données par Facebook confirment que les impératifs du « capitalisme de surveillance », s’ils existent, ne sont que secondaires par rapport à ceux du capitalisme lui-même. L’entreprise, préoccupée par sa croissance, a traité les données comme un actif stratégique.”

Les récentes révélations sur les pratiques de partage de données par Facebook confirment que les impératifs du « capitalisme de surveillance », s’ils existent, ne sont que secondaires par rapport à ceux du capitalisme lui-même. L’entreprise, préoccupée par sa croissance, a traité les données comme un actif stratégique.

Par souci de clarté, appelons cette interprétation thèse I. N’offrant rien de plus qu’une description, la thèse I implique très peu sur la durabilité, l’importance globale et l’impact du capitalisme de surveillance sur le capitalisme lui-même. Il y a certainement de nombreux effets sociaux négatifs, mais la thèse I ne les considère pas comme pires que ceux des modèles alternatifs.

Zuboff fournit suffisamment d’avertissements pour suggérer que l’illustration de la thèse I – un ensemble d’observations, et non une hypothèse – résume ses intentions. Alors que le capitalisme de surveillance semble révolutionnaire – pourquoi sinon le qualifier de « nouvel ordre économique », qui affecterait même les bouteilles de vodka et les thermomètres rectaux ? – Zuboff concède que les lois habituelles du capitalisme en matière de mouvement demeurent et sont simplement complétées par les nouveaux impératifs autour des données. Lu comme un exposé méticuleux de la thèse I, le livre est un mystère : pourquoi se donner tant de mal pour révéler les dommages occasionnels de Google et de Facebook – rien d’inédit en 2019 – sinon pour en tirer de plus larges et plus audacieuses conclusions ?

L’argument du livre de Zuboff selon lequel nous pourrions encenser la thèse II est donc peut-être plus pertinent. Tout d’abord, c’est une hypothèse correcte : elle postule que le capitalisme de surveillance non seulement produit des effets qui sont sans équivoque pires que ceux des régimes numériques alternatifs, mais qu’il devient aussi la forme hégémonique du capitalisme. Les anciennes lois du capitalisme s’appliquent, mais seulement formellement, la classe, le capital et les moyens de production ne conservant que peu d’emprise analytique. Pour s’adapter à l’environnement en mutation rapide, les capitalistes d’aujourd’hui doivent suivre les impératifs de la nouvelle logique fondée sur la surveillance ; ils doivent se préoccuper des moyens de modification du comportement, et non des moyens de production.

La thèse II a des implications révolutionnaires. Elle identifie l’extraction de données et la modification des comportements non pas comme des conséquences occasionnelles de la concurrence capitaliste, mais comme les causes sous-jacentes qui propulsent l’émergence du nouvel ordre économique, tandis que ses impératifs, à leur tour, en viennent à prendre le pas sur ceux du capitalisme lui-même. La thèse II augure une révolution copernicienne dans la façon dont nous comprenons l’économie numérique. Mais cette révolution repose sur des bases assez délicates, car Zuboff doit prouver, et pas seulement affirmer, son renversement de causalité sous-jacent. Si elle échoue, on en revient à la thèse I : les données sont appropriées – de manière extensive, rationnelle, infâme – et les efforts pour les monétiser ont parfois des effets sociaux délétères – un argument qui est certainement correct, mais quelconque.

La preuve critique et déterminante de la thèse II n’arrive jamais, ce qui n’est pas une grande surprise pour quiconque connaît la théorie commerciale de Chandler. Au contraire, la simplicité de la thèse I et l’ambition de la thèse II se confondent pour donner la tautologie de la thèse III, tout aussi bien connue des aficionados de Chandler : les capitalistes de surveillance s’engagent dans le capitalisme de surveillance parce que c’est ce que les impératifs du capitalisme de surveillance exigent. Zuboff fait régulièrement appel à cette thèse auxiliaire, qui facilite le postulat qu’elle doit prouver par ailleurs.

La thèse III, cependant, n’est pas une hypothèse à prouver mais un axiome impossible à falsifier : tout cas qui ne correspond pas à la théorie peut toujours être écarté comme se situant en dehors du capitalisme de surveillance tel que la théorie le définit, et donc, non soumis à ses impératifs. Ce qui peut être falsifié, c’est la thèse II, car elle pose des mécanismes de causalité réels.

Avant que vous, cher lecteur, ne soyez mal à l’aise en soupçonnant, non à tort, qu’un exercice ennuyeux et cruel de philosophie analytique est sur le point de se dérouler, soyons clairs sur sa raison d’être : sans une réaffirmation claire de la thèse de Zuboff dans un langage lucide et vérifiable, nous risquons toujours de nous noyer dans les marécages tautologiques de la thèse III. À cette condition, nous pouvons procéder avec notre propre Tractatus Logico-Philosophicus miniature.

La thèse II est un ensemble de plusieurs propositions :

- La civilisation de l’information pourrait choisir entre le capitalisme de surveillance et le capitalisme d’information ;

- Les deux tirent parti de l’extraction de données : l’un pour obtenir un surplus comportemental, l’autre pour améliorer les services ;

- Certaines caractéristiques de la civilisation de l’information ont rendu le capitalisme de surveillance hégémonique ;

- À mesure qu’il devient hégémonique, ses impératifs le deviennent aussi ;

- Dans ses effets sociaux, le capitalisme de surveillance est davantage néfaste que ses alternatives.

Les preuves fournies pour étayer chacune des affirmations de la thèse II ci-dessus sont souvent incomplètes et n’excluent pas d’autres explications. Dans de tels cas, la thèse III comble les lacunes. Abordons chacune de ces propositions selon ses propres termes.

La proposition ii est cruciale, car elle pose les relations de cause à effet entre l’extraction de données et les impératifs des deux ordres économiques : dans la civilisation de l’information, les données sont collectées soit parce qu’elles constituent un surplus comportemental (ce qui nous donne le capitalisme de surveillance), soit parce qu’elles améliorent les services (ce qui nous donne le capitalisme d’information). Cette proposition pourrait s’appliquer à des cas idéaux comme Google et Apple. Mais qu’en est-il des cas limites ? Dans quelle mesure l’accent mis sur la vie après la mort des données des utilisateurs explique-t-il la dynamique du « capitalisme de l’information » lui-même ?

Extraction secrète des données pour « améliorer les produits » : capitalisme de surveillance ou d’information ?

Prenons l’exemple d’Amazon. Les lecteurs électroniques Kindle collectent constamment des données – livres lus, pages tournées, paragraphes soulignés – qui aident Amazon à décider quels livres publier par ses propres moyens. Cela s’inscrit dans le cadre de la défense du capitalisme : les consommateurs finissent par obtenir des livres plus pertinents. Amazon, cependant, fabrique également des modèles Kindle moins chers qui contiennent de la publicité. Si la publicité est personnalisée, nous devons être dans un capitalisme de surveillance à part entière. Si elle est générique, nous devons être dans le no man’s land du capitalisme numérique, coincés entre la défense des intérêts et la surveillance. Si le capitalisme de surveillance est, en effet, diagnostiqué, alors un double mouvement d’un genre ou d’un autre devrait se produire et garantir que nous payons tous le prix fort pour ces lecteurs électroniques ; sinon, notre autonomie est menacée.

Remarquez que cette prescription normative, ainsi que l’explication de la raison d’être de la publicité personnalisée, sont fournies par les pouvoirs miraculeusement persuasifs de la thèse III. Mais n’avons-nous pas simplement postulé que les données améliorent les services ou modifient les comportements au lieu de montrer que ces résultats se produisent ? Et si ces publicités Kindle, personnalisées ou non, n’existaient que pour permettre à Amazon d’attirer les consommateurs sensibles aux prix ? Après tout, le fait que les tech leviathans collectent des données et diffusent des publicités recouvre différentes motivations. Et si Amazon voulait simplement inonder le marché avec des appareils moins chers, assurant ainsi sa position sur le marché ? Pourquoi est-il plus important « d’accaparer » l’offre de données que le marché lui-même ?

Pensez également à l’expansion d’Amazon dans nos foyers. Amazon pourrait en effet récolter nos conversations sur des appareils compatibles avec Alexa pour éventuellement modifier notre comportement ; il pourrait même modifier notre comportement pour extraire plus de données. Mais il est également possible qu’Amazon souhaite simplement améliorer sa capacité de reconnaissance vocale, qu’elle monétise ensuite par le biais d’Amazon Web Services, la principale source de ses bénéfices. Amazon, comme la plupart des grandes entreprises technologiques, dissimule ses activités d’extraction de données. Mais l’invisibilité de ses opérations prouve, tout au plus, qu’elles sont malhonnêtes. La définition de Zuboff du capitalisme de surveillance dépend de la question à savoir si le surplus de comportement est utilisé pour modifier le comportement, et non si l’extraction de données est visible. Les processus d’extraction de données inhérents à l’alternative positive de Zuboff (lorsque les données entrent dans le cycle de réinvestissement comportemental) sont, après tout, aussi opaques que ces mêmes processus sous le capitalisme de surveillance (lorsque les données produisent un surplus comportemental).

Alors, qu’est-ce qui motive Amazon : la rentabilité et la survie, ou l’extraction de données et la modification des comportements ? Si l’on s’en réfère à la révolution copernicienne que suggère Zuboff, ce dernier point a pris le pas sur l’entreprise numérique capitaliste. « Amazon est à la recherche d’un surplus comportemental », écrit-elle. « Cela explique pourquoi la société a rejoint Apple et Google, dans le concours pour le tableau de bord de votre voiture, en forgeant des alliances avec Ford et BMW. » Voici la même hypothèse, telle qu’elle aurait probablement été formulée avant la révolution copernicienne de Zuboff : « Amazon a rejoint Apple et Google dans le concours pour le tableau de bord de votre voiture, forgeant des alliances avec Ford et BMW. En conséquence, elle est à la recherche d’un surplus comportemental ».

La raison pour laquelle Amazon a rejoint Apple et Google dans cette mission mérite une investigation, et non une simple présomption. Pour le faire correctement, sans doute faudrait-il cesser de nous concentrer sur le rapport de ces entreprises aux consommateurs, pour examiner comment elles interagissent avec les autres entreprises et les gouvernements. Comme ces interactions n’incluent pas les consommateurs, Zuboff en fait peu de cas – bien qu’elles permettent souvent de réaliser des profits bien plus élevés que les agences de publicité des géants de la technologie.

Quoi qu’il en soit, Zuboff n’a pas besoin de chercher à savoir pourquoi Amazon se joindrait à Apple (Apple ?!) et à Google dans cette mission, puisque la thèse III fournit commodément toutes les réponses. Ainsi, la chasse au surplus comportemental devient la cause, et non l’effet, des pratiques des entreprises technologiques. Et bien que Zuboff concède que les impératifs plus généraux de la concurrence sur le marché façonnent leur lutte, ces entreprises ne font leur travail qu’après que l’objectif de la lutte – la récolte de données – ait été fixé, de l’extérieur, par la thèse III. Le capitalisme de surveillance est, sans surprise, davantage rattaché à la « surveillance » qu’au « capitalisme ».

Le critère selon lequel la proposition ii classifie les entreprises – en extrayant des données pour modifier les comportements ou améliorer les services – génère également des résultats étranges. Prenons l’exemple d’Uber, qui est à peine mentionné dans le livre – peut-être pour de bonnes raisons. Uber, qui ne dépend pas des revenus publicitaires, est confronté à des incitations qui diffèrent de celles de Google ou de Facebook. Pratique-t-il un capitalisme d’information ? Ses dirigeants le diraient : les tactiques agressives d’Uber garantissent que les passagers bénéficient de services meilleurs et moins chers. Cela correspond à la définition qu’en donne Zuboff : « Lorsqu’une entreprise recueille des données comportementales avec l’autorisation des consommateurs et uniquement dans le but d’améliorer un produit ou un service, elle s’engage dans un capitalisme mais pas dans le capitalisme de surveillance ».

Uber, cependant, effectue de nombreuses choses odieuses avec les données. Prenez par exemple le scandale Greyball découvert par le New York Times en 2017. Greyball était le système d’espionnage interne d’Uber qui rendait ses véhicules invisibles aux utilisateurs à proximité des bâtiments gouvernementaux tout en signalant leurs données, comme les détails des cartes de crédit, qui laissaient supposer qu’ils travaillaient dans les forces de l’ordre. Ici, l’objectif de l’extraction de données, même si elle est malveillante et invisible, n’était ni la modification du comportement des utilisateurs ni l’amélioration du service. Il s’agissait plutôt de créer une sous-classe permanente de non-utilisateurs afin d’échapper à la réglementation et de maintenir les coûts à un faible niveau.

Il existe une théorie plus simple et plus générale pour expliquer l’extraction de données et la modification du comportement que Zuboff ignore, piégée comme elle l’est dans le cadre de Chandler, avec son besoin brûlant de trouver un successeur au capitalisme managérial. Cette théorie plus simple va comme suit : les entreprises technologiques, comme toutes les entreprises, sont motivées par la nécessité d’assurer une rentabilité de long terme. Elles y parviennent en écrasant leurs concurrents par une croissance plus rapide, en externalisant les coûts de leurs opérations et en tirant parti de leur pouvoir politique. L’extraction de données et la modification des comportements qu’elle permet – ce qui est clairement plus important pour les entreprises dans des secteurs tels que la publicité en ligne – s’inscrivent dans ce contexte, là où elles le font.

“Revenons à Uber. Est-ce que l’entreprise extrait des données, et devrions-nous nous en inquiéter ? Certainement. Mais devrions-nous accepter la révolution copernicienne de Zuboff, et penser l’économie numérique à travers le prisme de l’extraction de données comme point nodal ?”

En d’autres termes, ils ne sont qu’un effet local d’une cause globale. C’est cette cause – la nécessité d’assurer une rentabilité à long terme face à la concurrence – qui détermine leur stratégie en matière de données. Cette explication parcimonieuse traite les cas de Google et d’Uber, sans qu’il soit nécessaire de poser de nouveaux « régimes » hybrides tels que, par exemple, le « capitalisme d’information ». En réalité, le régime à l’œuvre n’est que celui du capitalisme au sens strict – et l’utiliser comme catégorie analytique aide à compenser les nombreuses lacunes des concepts de capitalisme managérial et du capitalisme de surveillance.

Les récentes révélations sur les pratiques controversées de partage de données par Facebook confirment que les impératifs du « capitalisme de surveillance », s’ils existent, ne sont que secondaires par rapport à ceux du capitalisme lui-même. L’entreprise, préoccupée par sa croissance, a traité les données comme un actif stratégique : lorsque les impératifs d’expansion impliquaient qu’elles devaient être partagées avec d’autres entreprises technologiques, elle l’a fait sans hésiter, donnant accès à Microsoft, Amazon, Yahoo et même Apple (bien qu’Apple ait nié leur implication). Sous le capitalisme, la question de savoir qui s’approprie le surplus comportemental est secondaire ; ce qui compte, c’est de savoir qui s’approprie le surplus réel et peut continuer à le faire sur le long terme.

Généralisation du capitalisme de surveillance : conjoncture malheureuse ou effet de structure ?

La proposition iii, selon laquelle la conjoncture actuelle favorise le capitalisme de surveillance plutôt que le capitalisme d’information, semble plausible. Comme je l’ai noté ci-dessus, Zuboff évoque des « affinités électives » entre les impératifs du capitalisme de surveillance et ceux qui ont façonné les opérations militaires de l’après-11 septembre et les initiatives de déréglementation néolibérales. Cela n’explique toutefois que la prospérité du capitalisme de surveillance, et non pas sa prospérité aux dépens du capitalisme d’information. Pour ce faire, il aurait fallu montrer que les affinités électives favorables au capitalisme de surveillance n’étaient pas simultanément favorables au capitalisme d’information.

Est-ce le cas ? Apple, que l’on peinerait à dépeindre en victime du capitalisme, canalise l’argent via Braeburn Capital, un fonds spéculatif géant. Amazon, avec ses 600 000 employés, est l’un des principaux bénéficiaires de la faiblesse du droit du travail. Amazon liste la CIA comme un client majeur. Siri [l’application informatique de commande vocale créée par Apple NDLR] provient du Stanford Research Institute, bénéficiaire de fonds du Pentagone. À y regarder de plus près, ces affinités électives sont légions. Mais c’est ici que la thèse III surgit comme par magie, modifiant la proposition initiale : le capitalisme de surveillance s’est avéré hégémonique… dans les environnements où il s’est avéré hégémonique.

Cette hégémonie est simplement postulée par Zuboff, et non mise en évidence. La dynamique de la concurrence ne pousserait-elle pas Google et Facebook à suivre la voie d’Amazon et de Microsoft, en vendant des services tels que le cloud computing et l’intelligence artificielle ? C’est ce que l’on est en droit de supposer si l’on pose que les capitalistes courent après la rentabilité (et non l’efficacité ou le surplus comportemental), et si l’on garde à l’esprit que de tels projets informatiques promettent des marges bénéficiaires lucratives, alors que la publicité entraîne des coûts de plus en plus élevés. Ces services ne pourraient-ils pas supplanter la publicité et la modification des comportements comme modèle principal de l’économie numérique ? C’est évident, mais ce n’est pas un problème que Zuboff considère.

Certaines lacunes de la proposition iv – qui laisse entendre que les impératifs du capitalisme de surveillance l’emportent sur ceux du capitalisme lui-même – ont déjà été discutées. Rappelons que la thèse II explique la stratégie des capitalistes de surveillance par leur impératif premier d’accaparer les réserves de surplus comportemental. Depuis 2001, Alphabet, la société-mère de Google, a acquis plus de 220 entreprises ; Facebook en a acquis plus de soixante-dix. La chasse aux données a-t-elle été le moteur de ces acquisitions ? Ou certaines d’entre elles – l’acquisition d’Instagram par Facebook par exemple – étaient-elles motivées par la recherche d’un pouvoir de marché ? Il est impossible de répondre à cette question en se contentant de regarder ce qui est arrivé aux données des deux entreprises qui ont fusionné. La troisième thèse, en revanche, le peut.

Revenons à Uber. Est-ce que l’entreprise extrait des données, et devrions-nous nous en inquiéter ? Certainement. Mais devrions-nous accepter la révolution copernicienne de Zuboff, et penser l’économie numérique à travers le prisme de l’extraction de données comme point nodal ?

Dans le cas d’Uber, le récit « pré-copernicien » est d’une puissance explicative bien plus importante. En 2017, Uber a perdu 4,5 milliards de dollars ; sa perte prévue pour 2018 est d’une ampleur similaire. La société se maintient à flot sur un océan de dettes, en attendant une introduction en bourse qui pourrait injecter de nouveaux fonds d’investisseurs extérieurs, en brûlant les liquidités de l’Arabie saoudite et de la SoftBank du Japon – cette dernière ayant elle-même une dette de plus de 150 milliards de dollars. Pourquoi une entreprise si lourdement endettée investirait-elle dans une société déficitaire ? Pourquoi le financement de la dette de la SoftBank a-t-il été si bon marché ? Et pourquoi l’Arabie saoudite verse-t-elle des liquidités dans des entreprises technologiques ? Les réponses à ces questions n’éclaireront pas ce que fait Uber avec les données, mais elles révéleront le premier impératif de l’entreprise : écraser la concurrence. Il ne fait aucun doute que cette directive primordiale implique parfois l’extraction de données. Mais l’inverse n’est pas vrai.

Nous devrions, bien sûr, tendre vers une utilisation équilibrée des explications micro et macro. Mais la tentative de Zuboff en la matière est toujours tributaire de la cohérence logique interne à la thèse III. « La technologie est l’expression d’autres intérêts », écrit-elle. « À l’époque moderne, cela signifie les intérêts du capital, et à notre époque, c’est le capital de surveillance qui commande le milieu numérique et oriente notre trajectoire vers l’avenir ». Cette conclusion selon laquelle le capital de surveillance, et non le simple vieux capital, dicte le développement de la technologie aujourd’hui, est simplement postulée. Les catégories antérieures perdent leur importance analytique par décret. Le récit de Zuboff se fonde sur la présomption qu’elles n’ont pas d’importance. C’est également ce qu’elle faisait dans son premier livre ; à l’époque cependant, Zuboff n’avait pas poussé le courage jusqu’à reconnaître que ses propres choix analytiques avaient invalidé les cadres précédents.

Une telle vision étroite est monnaie courante dans la plupart des théories commerciales de Chandler ; ses praticiens, d’ailleurs, n’en font pas mystère. Chandler lui-même a été très explicite sur son objectif dans les premières pages de son ouvrage The Visible Hand : « Je ne traite des grandes évolutions politiques, démographiques et sociales que dans la mesure où elles ont une incidence directe sur la façon dont l’entreprise a mené à bien les processus de production et de distribution ». Nous pouvons tolérer, au prix d’efforts considérables, un tel prisme dans le récit de l’histoire des entreprises ; cependant, lorsqu’il devient le fondement d’une théorie, comme l’ont été les textes de Chandler pour les théories ultérieures de l’entreprise et comme pourraient le devenir ceux de Zuboff pour les théories de l’entreprise numérique, nous risquons de substituer le solipsisme des entreprises à la perspicacité théorique.

Il nous reste à analyser la proposition v : l’idée selon laquelle les méfaits du capitalisme de surveillance sont supérieurs à ceux des logiques alternatives. Il n’est pas interdit de se demander pourquoi consacrer tant de pages à ce que Zuboff appelle le « pouvoir instrumental » si ce n’est qu’un des nombreux pouvoirs du capitalisme numérique et peut-être même pas le pire ? Hélas, Zuboff couvre ses paris, en concédant que les « pratiques monopolistiques et anticoncurrentielles dans le cas d’Amazon » et « les stratégies de prix, les stratégies fiscales et les politiques d’emploi [dans le cas d’] Apple » sont également problématiques.

En l’absence d’un cadre permettant de comparer les méfaits du capitalisme de surveillance avec ceux de ses alternatives, il n’y a qu’une solution : demander au lecteur de supposer, à la suite de la proposition III, qu’il est hégémonique, de sorte que ses problèmes méritent plus d’attention. Si ce n’est pas le cas, pourquoi s’inquiéter davantage des consommateurs dans les maisons intelligentes gérées par Alexa que des travailleurs dans les entrepôts intelligents néo-tayloriques d’Amazon ?

Dépourvue d’une analyse solide sur le fonctionnement du pouvoir anonyme sous le capitalisme, Zuboff finit par opposer le « pouvoir instrumental » du capitalisme de surveillance au « pouvoir totalitaire » des dictatures. Là où « le totalitarisme opère par la violence », « le pouvoir instrumental opère par la modification des comportements » et « n’a aucun intérêt pour nos âmes ni aucun principe à instruire ».

Peut-être, mais qu’en est-il de la « morne contrainte des relations économiques » évoquée par Marx ? Ne représentait-elle aucun pouvoir ? Voici ce que Friedrich Hayek – l’anti-Marx par excellence – écrivait dans les années 1970 : « La concurrence produit… une sorte de contrainte impersonnelle qui oblige de nombreux individus à adapter leur mode de vie d’une manière qu’aucun ordre ou instruction délibérée ne peut provoquer ». Hayek ne fait-il pas référence ici à la modification des comportements, entreprise par les forces impersonnelles du capitalisme sans injonctions totalitaires ?

Traduit par Eugène Favier-Baron et Vincent Ortiz.