À chaque nouveau tour de vis numérique, ce sont les structures (sociales, économiques) du présent que l’on verrouille un peu plus. Ne sommes-nous pas en train d’assister à une révolution numérique conservatrice, impactant nos modes de vie, de pensée, voire nos modes de régulation sociale, au profit d’une gouvernance algorithmique dangereuse pour les libertés publiques et la démocratie ? L’urgence de développer des points de vue critiques sur ces transformations s’impose tous les jours un peu plus. Par Matthieu Belbèze.

Comment une photo de femme en bikini s’est-elle retrouvée classée dans la catégorie « souillon » par un algorithme de reconnaissance visuelle ? Comment le portrait d’un enfant portant des lunettes de soleil lui a-t-il valu de se voir affublé du qualificatif de « loser » ? Ce sont les résultats obtenus il y a quatre ans par Kate Crawford, chercheuse et professeure dans le domaine de l’intelligence artificielle, et Trevor Paglen, artiste, géographe et photographe. Ensemble, ils se sont intéressés à l’histoire de la reconnaissance d’images par des systèmes automatiques et des algorithmes.

Leur but : comprendre comment ces systèmes, à qui l’on accorde une confiance de plus en plus aveugle, sont entraînés à « voir » et « catégoriser » le monde. Le projet « Training Humans » a depuis été largement documenté. Sa conclusion : « il n’existe à ce jour aucune méthode « neutre », « naturelle » ou « apolitique » d’entraîner une intelligence artificielle ». La tendance systématique à collecter, catégoriser, qualifier des données soulève des questions cruciales. Qui décide de ce que ces images signifient ? Qui définit les catégories ? Quelles représentations sociales se retrouvent inévitablement embarquées dans un tel travail ?

Pour Kate Crawford et Trevor Paglen, vouloir s’affranchir des biais embarqués dans la création d’un modèle mathématique est une entreprise impossible. Les tentatives d’IBM pour « mathématiser la représentativité » leur semblent vaines et particulièrement alambiquées. En effet, utiliser un algorithme qui pondère les choix faits par des opérateurs humains pour entraîner un autre algorithme de reconnaissance visuelle par une méthode à mi-chemin entre poupée russe et Turc mécanique produit très souvent des résultats fragiles et dangereux d’un point de vue normatif. Cette pratique est symptomatique d’une course en avant qui semble à chaque étape amplifier un peu plus les erreurs du passé.

Les algorithmes, arme de reproduction massive

Après tout, comme l’écrit Marianne Bellotti, développeuse autodidacte et anthropologue passée notamment par le Département américain du numérique : « les gens ne prennent pas de meilleures décisions avec plus de données, alors pourquoi penser qu’il en serait différemment pour une intelligence artificielle ? ».

Comme Sisyphe, condamné par les dieux à remonter chaque matin un énorme rocher le long d’une pente raide avant qu’il ne la dégringole à nouveau chaque soir, les spécialistes passent 80% de leur temps à nettoyer les jeux de données dont ils disposent. Dans l’espoir que de « meilleures informations » permettent – enfin – d’obtenir de meilleurs résultats.

du Prado à Madrid

Or la rationalité dont nous entendons charger les systèmes informatiques que nous créons n’existe pas. En contexte réel, les décisions publiques, politiques, économiques, sont prises non pas dans un souci de précision et d’exactitude – mais de façon à minimiser l’effort requis. Marianne Bellotti encore : « la compréhension totale d’une situation est moins désirable que des outils permettant de prendre une décision plus rapide ». Une décision sera donc toujours le résultat d’une négociation entre les différents acteurs impliqués, compte tenu de leurs enjeux et de leur environnement. Un processus qu’aucun échantillonnage parfait de données (si tant est qu’il existe) ne pourra jamais contraindre.

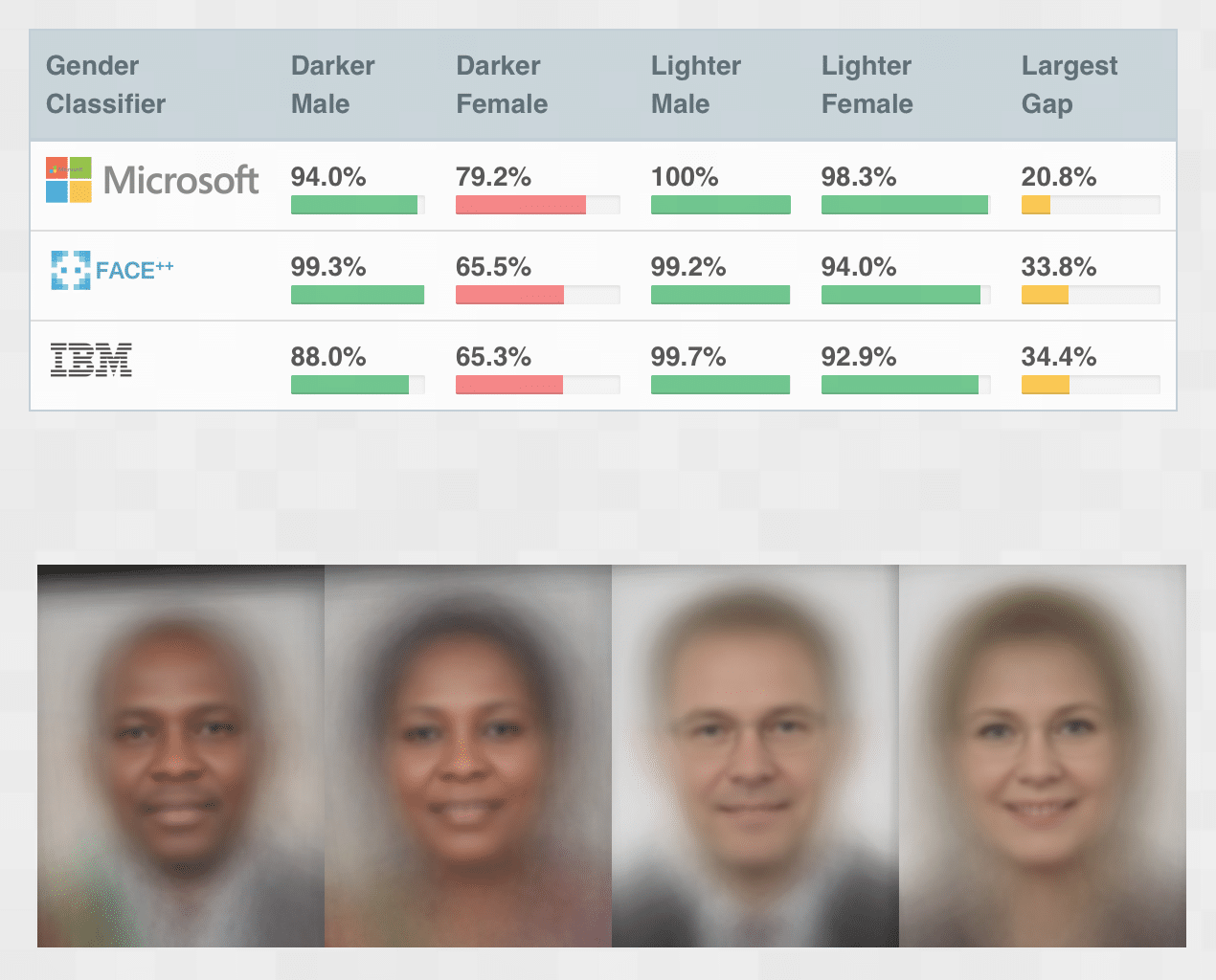

Les développements technologiques de l’intelligence artificielle (IA) seront toujours soumis aux biais et aux impératifs (personnels, financiers, mentaux) de celles et ceux qui les contrôlent. Une direction très largement héritée du passé – et qui explique sans doute que les systèmes de reconnaissance faciale vendus par Microsoft, IBM ou par le géant chinois Megvii se montrent particulièrement défectueux face à des femmes noires, alors qu’ils présentent de meilleurs résultats face à des hommes blancs… Mireille Hildebrandt, juriste et philosophe néerlandaise spécialiste des sciences informatiques, met derrière l’acronyme d’IA (Intelligence Artificielle) le concept particulièrement juste d’« Inférence Automatisée ». Ce qu’on nous présente comme une révolution n’est qu’une prolongation de systèmes de pensée déjà en place.

La numérisation du travail : nouveaux ingrédients, vieilles recettes

Une consolidation des structures existantes qui se retrouve largement dans le monde du travail. À commencer par la façon même dont les outils numériques de « productivité » sont codés. Le logiciel de visioconférence Zoom, qui a su tirer son épingle du jeu durant la pandémie en passant de 10 millions d’utilisateurs quotidiens à plus de 300 millions en quelques mois en est l’illustration parfaite. Hubert Guillaud, journaliste et infatigable arpenteur d’internet interviewé par Xavier de La Porte explique comment certaines fonctionnalités du logiciels ne sont accessibles qu’à l’organisateur de la réunion en ligne. L’« host » peut ainsi couper le micro d’un participant, autoriser ou interdire le partage d’écran, voire éjecter purement et simplement un utilisateur d’une réunion.

Revoilà le pouvoir hiérarchique du passé codé « en dur » dans les fonctionnalités de l’outil du futur. La collaboration horizontale née du confinement, qui devait mettre tout le monde sur un pied d’égalité, a fait long feu. Dans un fameux article paru en 2000 (Le code fait loi – De la liberté dans le cyberespace), le professeur de droit à Harvard et activiste Lawrence Lessig attirait déjà l’attention sur ce nouveau pouvoir qui émergeait, loin des yeux du grand public ou des instances représentatives. Car l’entreprise privée qui code un outil utilisé par des centaines de millions de personne contrôle pleinement ce qu’ils ou elles y feront – ou ne pourront pas y faire. « Code is law ».

« Le conservatisme, c’est estimer qu’il y a un groupe de personnes qui doit être protégé mais pas contraint, et qu’un autre doit être contraint mais pas protégé ». Les mots sont d’un commentateur de forum dont on ne connaît que le nom, Frank Wilhoit, mais ils sonnent terriblement juste : il faut donc qu’en renforçant les gagnants habituels, la technologie affaiblisse aussi les perdants usuels. Dans le monde du travail, l’irruption (la « disruption » ?) de la robotique, censée remplacer les emplois les moins qualifiés, n’a pas eu lieu (SoftBank, le géant japonais, vient de renoncer à la production de ses robots Pepper, destiné à prendre soin des populations vieillissantes). Mais elle a servi d’épouvantail à beaucoup d’entreprises, Amazon en tête, pour faire accepter son ersatz : le contrôle informatisé et constant des employés.

C’est ce que Callum Cant, journaliste, écrivain, auteur notamment de « Riding for Deliveroo » appelle le « management algorithmique ». Amazon, Uber, ont transformé le travail en une succession de micro-instructions mesurées, limitées dans le temps, qui retirent à l’employé toute autonomie et toute compréhension de ce qui est à l’œuvre. Il compare cette situation à celle du Détroit des années 50 et 60, où les ouvriers des lignes d’assemblage automobiles avaient la liberté pendant leur pause d’aller se promener dans les usines pour voir se dérouler sous leurs yeux l’ensemble de la chaîne de production. Une clarté qui paraît totalement inaccessible aujourd’hui.

Cette stratégie de contrôle vient de loin, et est tout sauf innovante. L’« organisation scientifique du travail » prônée par l’ingénieur américain Frederick Winslow Taylor au début du XXe siècle a donné le taylorisme, puis le fordisme. L’employé étant embauché pour sa force de travail potentielle, comment faire pour que ce potentiel soit utilisé à plein, tout le temps ? Autrement dit, pour en prendre le contrôle ? Pendant longtemps, l’ouvrier était celui qui connaissait le mieux son travail, une connaissance qui échappait à son employeur et qui lui permettait donc de garder la main sur son « potentiel » et sur son effort. Taylor entreprit d’étudier le travail, d’inverser la connaissance pour la mettre entre les mains de ceux qui l’organisent. De découper et de chronométrer les tâches pour en éliminer toute marge, latence, autonomie.

Du taylorisme à l’« amazonification » du travail, l’hérédité est flagrante. Dans les entrepôts de Jeff Bezos, votre « temps hors tâche » (« Time Off Task » ou « TOT ») est précisément mesuré, et un jeu vidéo maison appelé « Mission Racer » invite les employés à rentrer en compétition les uns avec les autres pour aller plus vite …

Les rentiers numériques

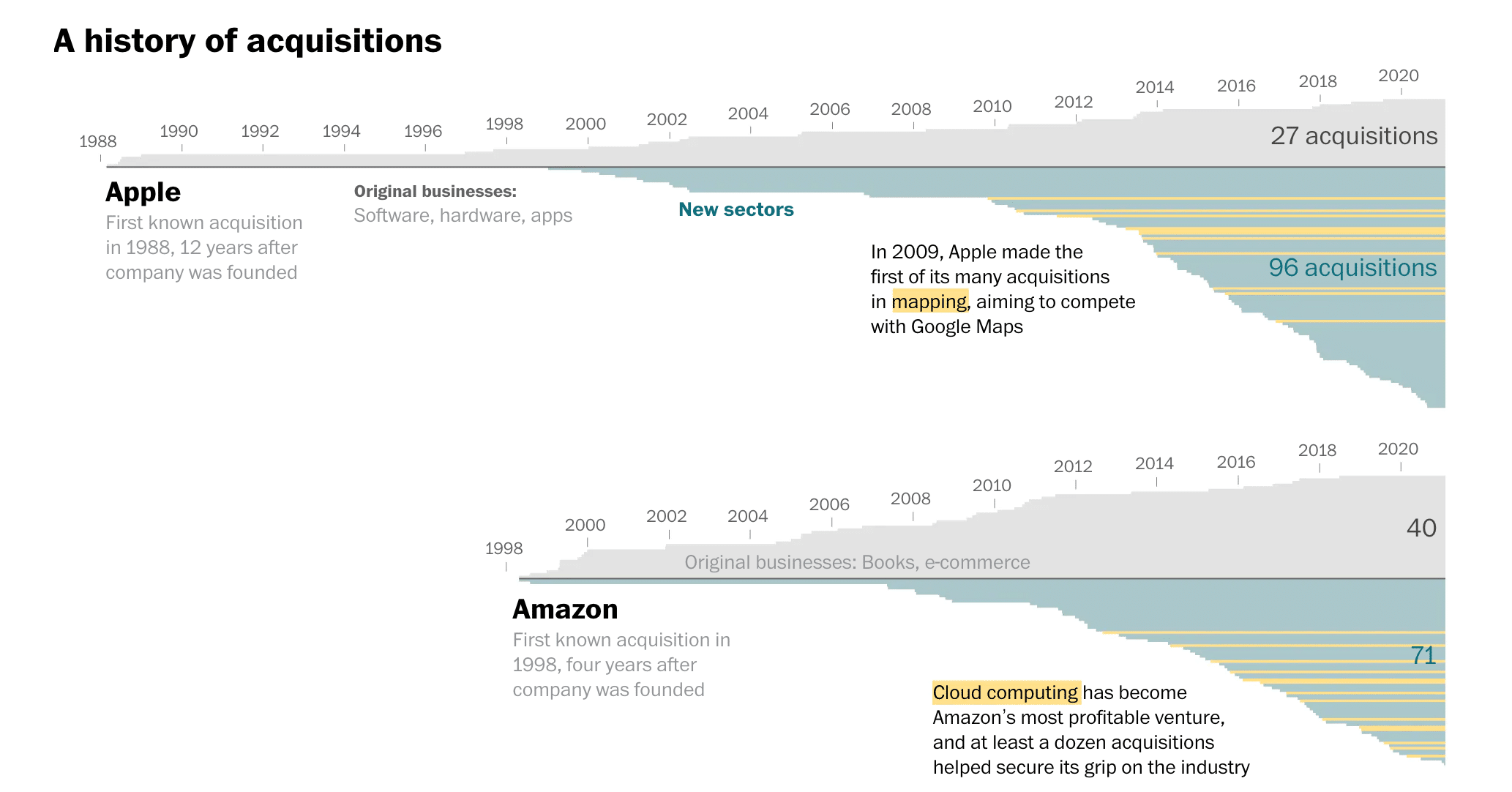

Au sommet de la pyramide conservatrice trônent celles et ceux « qui doivent être protégés mais pas contraints ». On a écrit ailleurs comment l’innovation, censée, dans la théorie économique du marché, bousculer les acteurs en place, avait dans les faits perdu son pouvoir de « briseuse de rente » pour la raison que les grandes entreprises innovent trop vite et ralentissent volontairement la diffusion technologique, disposent de données et de capitaux massifs qui les rendent impossibles à rattraper. En outre, Amazon, Apple, Facebook et Google consolident ainsi leur métier initial tout en avalant à un rythme effréné les acteurs des secteurs qu’ils convoitent. Le résultat ? Des monstres hybrides, qui ont fini par attirer l’attention de certains parlementaires américains, inquiets de leurs « conflits d’intérêts » et de l’« auto-promotion de leurs services. »

Kean Birch et D.T. Cochrane, professeur et chercheur au sein de l’université de York au Canada, parlent de la formation d’« écosystèmes » entiers dont la survie et la croissance reposent non plus sur la capacité à innover, mais sur la construction expertes de rentes qu’ils classent en quatre catégories :

Rentes d’enclaves

La majeure partie de ces écosystèmes est fermée, alors qu’ils sont devenus des passages obligés. Il est alors nécessaire pour cela de payer Apple pour diffuser des application aux détenteurs d’iPhones, ou accepter de partager les données d’utilisateurs pour proposer un service sur le casque de réalité virtuelle Oculus de Facebook.

Rentes liées aux anticipations positives des marchés

Grosses et particulièrement rentables, ces entreprises peuvent emprunter à bas prix sur les marchés financiers, ce qui leur permet de financer leur croissance et leurs achats externes tout en renforçant les anticipations positives… et ainsi de suite.

Rente d’engagement

Par l’ancienneté et la multiplicité de leurs points de contact (appareils connectés, logiciels professionnels, de santé, de musique…) les grands acteurs technologiques ont construit et continuent à élaborer en temps réel une connaissance sans égale des populations. Ce qui leur permet de vendre l’accès à des segments très fins, ou au contraire de développer eux-mêmes de nouveaux services sur des besoins qu’ils sont les seuls à anticiper.

Rente de réflexivité

Les auteurs désignent ainsi ce que nous évoquions plus haut (« code is law »), à savoir que ces entreprises, opérant hors de tout contrôle externe, peuvent établir voire tordre les règles du jeu à l’intérieur de leur propre écosystème. Facebook a ainsi longtemps menti sur la portée réelle de ses publicités auprès de ses clients, et Amazon a modifié les algorithmes de recherche sur sa plate-forme pour avantager ses propres produits.

Renverser le rapport de force

Algorithmes qui perpétuent les biais sociétaux à grande échelle, monde du travail plus hiérarchisé que jamais grâce au taylorisme numérique, géants technologiques qui construisent à grande vitesse des rentes indéboulonnables…

Le changement technologique est une bonne excuse pour ne rien changer du tout.

Nous voilà de plus en plus proches des visions techno-futuristes cauchemardesques de William Gibson, auteur notamment de Neuromancien et père du Cyberpunk. Un genre littéraire, cinématographique, visuel, qui dépeint une humanité qui s’est largement abandonnée à la technologie dans les moindres recoins de sa vie et même de ses corps (via des prothèses, ou des « augmentations » diverses et variées). Des mondes aussi très stratifiés, où l’écart entre « ceux d’en haut » (rappelez-vous, qu’il faut protéger sans contraindre) et ceux d’en bas est définitivement impossible à combler et assumé comme tel. Des mondes enfin où les grandes entreprises privées sont les nouvelles puissances politiques et régulatrices de nos vies. Or William Gibson le dit lui-même : « le changement technologique est une bonne excuse pour ne rien changer du tout ».

En temps de crise, il est tentant et (trop) humain de se raccrocher au passé, pour le faire vivre dans tout ce qu’il a de rassurant. Mais, écrit Eva Illouz, sociologue franco-israélienne, « vouloir illuminer le présent par le passé revient à chercher un objet perdu sous un lampadaire parce que c’est le seul endroit où il y a de la lumière ». L’usage actuel de la technologie s’assure de l’ordre (préserver celui en place) plutôt que de la justice (rééquilibrer les rapports), pour paraphraser une interview récente de l’acteur et réalisateur Jean-Pierre Darroussin.

Sous couvert de marche en avant progressiste, le néo-libéralisme technologique nous conduit tout droit à une mise en stase qui figerait la société actuelle. On peut alors, avec la philosophe Barbara Stiegler, faire appel à la grande figure du pragmatisme américain John Dewey. Rejetant « une adaptation passive des masses à l’environnement dégradé créé par la révolution industrielle, Dewey n’a cessé de lui opposer ce qu’il pensait être le véritable sens de la révolution darwinienne : le fait que les êtres vivants s’étaient toujours adaptés en modifiant activement leurs environnements ».

Plutôt que de figer les structures du passé, il faudrait par le travail expérimental de l’intelligence collective, multiplier les initiatives démocratiques, inventer « par le bas » un autre avenir commun. Un mouvement qui germe ça et là dans le développement technologique : défense du « design participatif », de la transparence, ou encore réappropriation des savoirs et des données face à la confiscation et l’asymétrie de l’information auxquelles nous soumettent les grands acteurs technologiques.