Chercheuse spécialiste des questions de modernisation numérique des administrations publiques françaises, Marie Alauzen revient avec nous sur l’histoire du concept d’« État-plateforme » aujourd’hui en vogue dans les milieux institutionnels, ainsi que sur les transformations socio-politiques qui l’accompagnent. L’émergence de la notion de « citoyen usager » constitue selon elle le principal acquis de la période de transformation actuelle du concept d’État à l’aune de la numérisation. Ces transformations, redoutées par de nombreux observateurs critiques en raison des sources parfois libertariennes de ces théories, nous obligent à nous mettre au niveau des bouleversements qu’elles imposent à nos conceptions politiques et nos modèles sociaux. Entretien réalisé par Simon Woillet.

LVSL – Pouvez-vous nous donner en quelques mots les aspects les plus saillants de ce que l’expression « État-plateforme » signifie pour vous, depuis votre point de vue de chercheuse ?

Marie Alauzen – Par l’enquête J’ai enregistré plusieurs significations de l’expression d’« État plateforme » dans ses rapports de superposition, de différence ou de cohabitation plus ou moins pacifiés et évidents. Autrement dit, je prends le terme comme une coquille vide, et regarde la manière dont elle est tour à tour est remplie de sens sur un terrain donné — en l’espèce, celui de la modernisation de l’État en France.

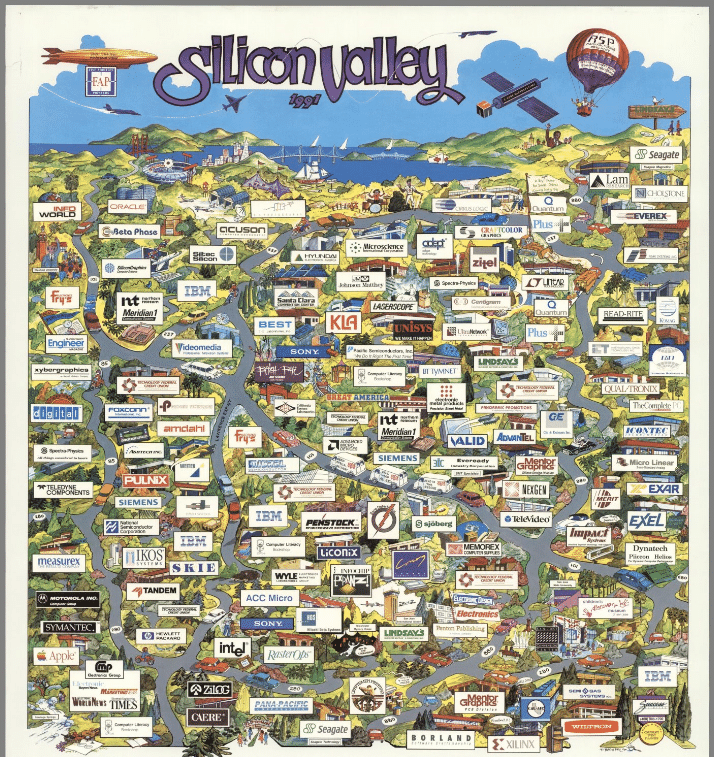

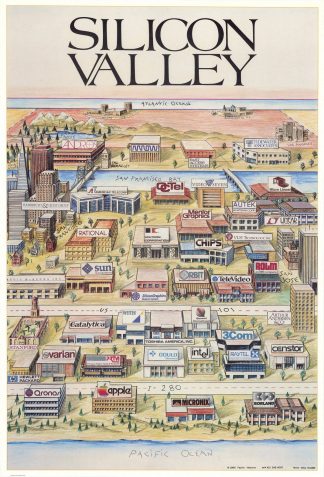

Le terme est apparu en France notamment avec la publication, en 2012, de l’essai de Nicolas Colin et Henri Verdier, L’Âge de la multitude. Entreprendre et innover après la révolution numérique1. Les auteurs y décryptent le succès du secteur numérique nord-américain comme le fruit d’une stratégie économique dans laquelle les entreprises les plus puissantes et les plus valorisées sont celles qui se sont « alliées » avec des individus « équipés, connectés et éduqués », formant une « multitude ». Le concept de multitude est alors emprunté Michael Hardt et Antonio Negri, Multitude. Guerre et démocratie à l’âge de l’Empire2.

Il désigne initialement la possibilité de formes nouvelles de démocratie contenues dans une entité fonctionnant en rhizomes tissés de collectifs humains hétérogènes et transnationaux rassemblés autour des « communs ». Comme le peuple, les masses ou la classe, la multitude esquisse une unité de la représentation politique ; la seule — selon les auteurs de L’Âge de la Multitude qui s’en font les ventriloques — en mesure de faire advenir des changements politiques et économiques dont la France aurait besoin. Parmi ces changements réputés inéluctables, les auteurs identifient l’émergence d’un « État plateforme », c’est-à-dire un renversement des rapports administratifs entre l’État et la société civile à l’issue duquel « l’administration ne se percevra plus seulement comme chargée de servir ou de contraindre le citoyen. Elle pourra également envisager de le doter en ressources, de stimuler sa créativité et de relayer ses efforts3 ».

Cette vision politique brièvement développée dans le dernier chapitre du livre va s’infiltrer parmi les mots d’ordre de la réforme de l’État (innovation, simplification, participation des usagers et des agents, expérimentation…) sous l’impulsion d’Henri Verdier, nommé quelques mois après la parution de l’ouvrage, en janvier 2013, chef de la mission d’ouverture des données publiques, Étalab, rattachée au Secrétariat général pour la modernisation de l’action publique (SGMAP), puis en septembre 2015, directeur interministériel du numérique et du système d’information et de communication de l’État, l’une des deux directions du SGMAP.

De ce point de vue sémiotique, l’État plateforme est donc une double traduction. Il est la traduction du slogan de Tim O’Reilly, « Government as a platform », dans un essai à succès sur les conséquences politiques de l’économie numérique en France, puis le transport de cette notion dans le programme d’action de la modernisation de l’État, auquel Henri Verdier, l’un des deux auteurs, a directement contribué entre 2013 et 2018, mais dont il ne conserve aucun monopole définitionnel, puisque le terme continue sa carrière dans le cours des actions ordinaires de la modernisation de l’État.

LVSL – La notion d’État plateforme nord-américaine, notamment introduite par Tim O’Reilly ne semble pas tout à fait recouvrir ce que les institutions françaises et européennes entendent par État plateforme (si l’on songe ici également au modèle estonien), quelles différences peut-on identifier entre ces deux usages du terme selon vous ?

M. A – N’ayant pas fait d’enquête spécifique sur ce point, je ne pourrais pas pousser l’analyse jusqu’à dégager une signification proprement européenne du terme. Toutefois, il existe bien une version étasunienne, première, qu’il faut examiner minutieusement. La formule du « government as a platform » est apparue sous la plume de Tim O’Reilly à partir de 2009. Cet entrepreneur et essayiste connu pour avoir forgé le terme de « web 2.0 » — autrement nommé internet participatif — a formulé cette expression à partir du printemps 20094 pour appeler de ses vœux une réforme de l’agir politique dans laquelle le gouvernement mettrait en place des infrastructures de services administratifs et techniques, qui seront ensuite mobilisés par les citoyens eux-mêmes pour assurer l’effectivité du service.

Le gouvernement se ferait ainsi techniquement « plateforme », dans le sens où il œuvrerait à la mise en relation d’une offre et d’une demande. Il ne faut pas y voir seulement l’appel à une économicisation des rapports politiques, l’originalité du « government as a platform » de Tim O’Reilly consiste à encourager, d’une part, une forte implication des citoyens à des fins d’altération du monopole des agents administratifs sur les affaires publiques et, d’autre part, inciter à la publicisation des problèmes administratifs et, en conséquence, rendre possible le recours à des ressources externes aux seules administrations.

Le slogan du « government as a platform » a gagné en popularité en étant intégré au programme démocrate lors de la campagne présidentielle de 2011, avant de devenir l’une des armatures conceptuelles du livre blanc sur le gouvernement numérique, publié peu après la réélection de Barack Obama5. Ce livre blanc fixe trois objectifs à la réforme des services numériques : l’accessibilité mobile de toute information ou tout service gouvernemental (anywhere, anytime, on any device), la création de services à la fois sécurisés et adaptés aux usages numériques ; ainsi que l’amélioration du service rendu aux citoyens (where every man feels that he is a participator in the government of affairs). Pour mettre en œuvre ces trois objectifs, l’administration est supposée faire « mieux avec moins », préférer des technologies dites « légères », des programmes d’action transversaux et coordonnés par des « intrapreneurs ».

Il est intéressant de noter qu’entre Tim O’Reilly et l’administration américaine enjointe à se réformer, il y a déjà de petits décalages : l’activation d’une offre et d’une demande par une plateforme technique et la focalisation sur la résolution collective de « problèmes publics » a cédé la place à une approche informationnelle, dans laquelle une couche infrastructurelle, incluant tous les systèmes et processus d’information (pêle-mêle données administratives, sondages, tweets ou articles de presse) permet à l’administration de veiller, de détecter, de vérifier et de transmettre des informations fiables aux citoyens.

Pour le dire en des termes anachroniques, la stratégie numérique du gouvernement était déjà orientée vers ce que nous appelons désormais les fake news et la responsabilité du gouvernement en matière de la circulation de l’information, là où Tim O’Reilly promouvait un expérimentalisme politique, familier de la tradition politique américaine, et ici largement colorié du « solutionnisme technologique » qu’Evegeny Morozov dénoncera quelques années plus tard6.

Ceci étant posé, comment mesurer la différence entre des abords conceptuels « français » et « nord-américains » ? Notons d’abord que la différence n’a pas échappé à Henri Verdier et Nicolas Colin. Ils attribuent la genèse étasunienne du mot d’ordre (et donc le « retard » européen et français) à une divergence dans la conception de l’État : « Il n’est pas étonnant que ce type d’attitude soit né plus rapidement aux États-Unis qu’en Europe. Comme le souligne[nt Michael Hardt et] Antonio Negri, il existe une nette différence entre la représentation européenne de l’État, perçu comme un souverain — quasiment transcendant, en tout cas surplombant la société — et la représentation américaine, où l’État est plus immanent et vu comme un dispositif équilibrant les différentes forces de la société7 ».

Autrement dit, c’est en considérant cette inclination historique nord-américaine à faire de l’État non pas la gigantesque entité métaphysique européenne, mais l’un des groupes secondaires d’une société politique faite de différents corps, le gouvernement, qu’ils auraient traduit « government as a platform » en « État plateforme ».

Outre cette différence dans l’interprétation de l’héritage contractualiste postulée par les importateurs du terme, il me semble qu’il y a sans doute plus de similitudes entre les significations dogmatiques et administratives de part et d’autre de l’Atlantique, qu’entre des significations proprement étasuniennes et françaises. Par exemple, l’État plateforme de L’Âge de la multitude et le « government as a platform » de l’article de Tim O’Reilly partagent l’ambition de créer « des services publics sans administrations, auto-organisés par des communautés de citoyens 8» ; la visée de démonopolisation n’est reprise ni par le livre blanc du gouvernement américain ni par les documents stratégiques sur la modernisation de l’État en France. De même, l’orientation vers la visibilité des problèmes administratifs et l’appel aux compétences de la multitude est largement gommée dans les documents stratégiques des administrations françaises et étasuniennes, aux prises avec d’autres montages, par exemple les règles des marchés publics.

LVSL – Vous avez pu observer sur plusieurs années les effets directs de cette notion et de ce discours sur les divers acteurs institutionnels engagés dans la transformation numérique de l’État et de sa relation avec le public, les citoyens, les entreprises, quels aspects les plus généraux de ces évolutions retiennent le plus votre attention ?

M. A – En France, le terme d’État plateforme en effet a été repris à l’automne 2014 par la Direction interministérielle du système d’information et de communication de l’État (DISIC, aujourd’hui Direction interministérielle du numérique). Il est venu conférer un abord conceptuel en même temps que renforcer l’intention qui était celle du décret de création9 : bâtir des infrastructures communes aux systèmes d’information ministériels, permettant à la fois des échanges de données sécurisées dans des formats interopérables, l’authentification des usagers ou encore le stockage d’applications. La doctrine assemblée dans les documents stratégiques de la DISIC a servi d’appui textuel, de référence, en mettant en avant des projets antérieurs ou en arrimant de nouveaux projets à un horizon de transformation désirable.

Elle est ainsi venue conférer une place de choix à la mission d’ouverture des données publiques, Étalab, qui mettait à disposition des réutilisateurs des jeux de données administratives — par exemple sur les mesures de la qualité de l’air des directions régionales de l’environnement, le financement du cinéma français du Centre national du cinéma ou encore les modèles de prévision climatique de MétéoFrance. Elle a aussi permis de stabiliser FranceConnect, l’application d’authentification des usagers des services publics en ligne que plusieurs millions de Français utilisent désormais dans leurs démarches courantes.

Cette application de rationalisation des identités numériques, pour les gestionnaires de sites et les usagers, est adossée à API-particulier, grâce à laquelle les usagers qui le souhaitent activent le partage de données avec les administrations auprès desquelles ils entreprennent des démarches — par exemple, pour éviter de fournir une pièce justificative par courrier ou de se rendre au guichet.

On aurait pu allonger la liste, mais notons déjà que l’ouverture des données publiques, l’authentification et l’échange de données grâce à API particulier (et son pendant, API entreprise) constituent trois matérialisations de l’État plateforme, ayant participé à stabiliser les cadres de la modernisation numérique de l’État qui sont encore les nôtres à un moment où l’expression a largement perdu de son attrait et n’est plus que prononcée du bout des lèvres à la Direction interministérielle du numérique.

LVSL – La notion d’État-plateforme semble associée de manière générale à deux postures interprétatives, l’une critique, lisant ce terme de manière critique et associée à la volonté de renforcer les politiques d’austérité et de réduction des effectifs des services publics ; l’autre plus nuancée, voire enthousiaste, faisant de ce terme le symbole d’une amélioration et d’une fluidification des rapports entre les administrations et les citoyens, notamment à travers des initiatives de facilitation telles que France Connect. Comment percevez-vous cet antagonisme ?

M. A – L’antagonisme que vous esquissez pour l’État plateforme actualise des approches classiques de la réforme administrative de l’État ; d’un côté, la mutation et ce que Philippe Bezes et Patrick Le Lidec ont justement appelé durant la réforme de l’administration territoriale de l’État « la forme fusion »10, de l’autre l’amélioration de l’expérience administrative de l’État pour certains types de populations. Ces tensions peuvent évidemment coexister dans un même projet de transformation de l’État et au sein d’un même répertoire d’action ; cela a été le cas durant une partie de la Révision générale des politiques publiques, qui a marqué le quinquennat de Nicolas Sarkozy.

Au cours de la période où j’ai suivi l’activité quotidienne de modernisation de l’État, qui correspond plus ou moins au quinquennat socialiste, ces deux aspects étaient nettement découplés. Réduire les coûts de fonctionnement du service public ne faisait pas partie du mandat confié aux modernisateurs de l’État ; cela ne signifie pas qu’après plusieurs années de diagnostic de l’administration comme intérieur malade ou dispendieux de l’État, l’impératif de réduction des dépenses publiques n’ait pas été tellement incorporé qu’il ait continué à vivre au sein de l’État. On le voit surgir dans certaines obsessions comptables, comme les exercices de connaissances des coûts consistant à ramener les coûts des services publics à l’unité individuelle de consommation, patient ou à étudiant par exemple.

Il faut toutefois nuancer ce que j’avance, car la Direction interministérielle du numérique a progressivement repris à son compte cet impératif de réduction des coûts. Elle ne s’est pas contentée de mettre en place les infrastructures que j’évoquais précédemment, elle a promu de nouvelles manières de concevoir les services publics, visant avec les méthodes agiles un certain idéal d’amincissement. Le changement de posture consacré par une circulaire de janvier 2015 requérant de réduire « la dépense informatique annuelle de 500 à 800 millions d’euros en trois à cinq ans 11» est devenu tangible à partir du moment où cette dernière s’est dotée de son propre exercice de connaissance des coûts : le remplissage d’un tableau de bord interministériel des grands projets informatiques, lui conférant un point de vue de superviseur sur la dépense des crédits informatiques. Cette pente s’est sans doute accrue depuis.

Toutefois, le pilotage des dépenses et les grands débats autour des projets informatiques paralysés, coûteux ou controversés (par exemple, le système d’alerte et d’information des populations du ministère de l’Intérieur [SAIP] ou plus récemment l’application StopCovid) n’emportent pas nécessairement des effets sur le travail quotidien des agents. Ces derniers continuent d’ouvrir les données et les algorithmes publics, de concevoir des produits numériques, d’accompagner les administrations en portant haut l’idée de fluidité de l’expérience et de facilitation du travail administratif des usagers, sans être mécaniquement liés à l’impératif économiste qui meut par ailleurs leur administration.

LVSL – Comment la France s’insère-t-elle dans l’ambition politique de la Commission européenne de numérisation administrative et de mise en commun des données des États membres en vue d’aider la croissance technologique de la zone ?

M. A – Il ne me semble pas que l’idée de « croissance technologique » soit un moteur du partage de données, notamment parce que les aspirations du début des années 2010 autour de « l’or noir des données » et des promesses d’innovation de la multitude ont en partie été déçues et reformulées. Pour vous répondre rigoureusement, il faudrait examiner de près ce que fait la DINUM et la manière dont le Secrétariat général aux Affaires européennes et l’Ambassadeur pour le Numérique s’en font le relai auprès des instances européennes.

En revanche, l’une des ambitions promues par la France depuis plusieurs mois s’articule autour de la notion de souveraineté numérique, pensée à l’échelle d’une future zone réglementaire européenne. Il est moins question de mise en commun de données, que de la constitution d’un territoire de gouvernement européen unifié, qui obligerait les plateformes au respect d’un certain nombre de règles (en matière de modération de contenus en ligne par exemple), dont le manquement entraînerait des sanctions mieux adaptées à la taille et au caractère déterritorialisé des plateformes de services numériques. C’est du moins la cible du Digital Service Act, en cours de négociation.

LVSL – Certains observateurs semblent identifier un glissement conceptuel de la notion de « citoyen » vers la notion de « citoyen-usager » dans le processus de numérisation des services publics, adhérez-vous à cette analyse et qu’implique-t-elle selon vous ?

M. A – Vous venez là à un point fondamental, dont nous n’avons, je crois, pas fini de penser les implications. En effet, le concept classique de la modernité politico-administrative hérité de la philosophie contractualiste lie l’existence de l’État moderne au sujet politique individuel : si cet individu apparaît comme une condition de l’État, celui-ci est en retour, par la protection et les possibilités d’expression qu’il lui offre, son garant. Les sciences sociales, et la sociologie politique en particulier, ont accueilli cet héritage, en ôtant la caractérisation métaphysique et juridique à la fois de l’individu et de l’État, pour montrer au contraire leurs couches de sociologisation. On pense par exemple à la sociologie historique de Norbert Elias dans le Procès de civilisation qui est parvenue à tenir ces deux pans de transformations de la modernité politique. Dans les travaux ultérieurs comme postérieurs, l’individu existe dans son lien à l’État, essentiellement sous les traits du citoyen ; ce citoyen héritier de la Révolution française qui vote, descend dans la rue et que l’on décrypte, une fois agrégé en « opinion publique » grâce à une instrumentation sondagière.

Or, je crois en effet que l’on peut repérer dans la mise en œuvre du programme d’État plateforme et au-delà dans les recompositions liées aux services numériques un glissement, non plus vers la figure du citoyen telle qu’elle a été configurée historiquement, mais vers celle d’un citoyen-usager des services étatiques. C’est un changement repéré empiriquement par certains observateurs des relations administratives, mais ils n’avaient pas poussé l’enquête jusqu’aux lieux où ces relations entre l’État et la société politique sont conceptualisées – même faiblement – et coordonnées ; en l’espèce l’administration de la modernisation de l’État. De tels lieux n’existaient d’ailleurs sans doute pas avant une date récente. Après plusieurs années d’observation de ce terrain, il me semble qu’il s’agit moins d’un dessein idéologique, d’un projet finalisé de réforme du rapport entre l’État et la société politique repérable dans les succès du programme d’État plateforme, qu’un effet des transformations interactionnelles et scripturales précipitées par l’expansion des technologies numériques, de choix infrastructurels et des métamorphoses des savoirs de gouvernement dont le design, l’informatique et les sciences comportementales.

L’une des conséquences immédiatement repérables de ces métamorphoses porte sur la politisation. La politisation des agents modernisateurs est très nette ; elle est lisible dans leur inclination à s’emparer — y compris au corps défendant des administrations légitimes — de sujets de politiques sociales (les aides et prestations sociales, le droit du travail, l’embauche, la recherche d’emploi, etc.). Ces derniers relaient une critique virulente de la place conférée à un droit peu soucieux de ses conditions de félicité et fustigent la mise en œuvre de politiques publiques à laquelle ils reprochent leur incapacité à se déployer jusqu’aux usagers concernés.

Au nom de cet usager, et même en se faisant usagers, ils adoptent une attitude militante. Par exemple, ils reprennent, bénévolement, un simulateur de prestations sociales, fermé à la demande du ministère de la Santé et des Solidarités, continuent d’y ajouter, les soirs et les week-ends, de nouvelles aides et payent de leur poche l’achat du nom de domaine (mes-aides.org). Cette idée d’une citoyenneté d’usagers s’observe également dans certains phénomènes comme le non-recours volontaire aux droits sociaux (qui constitue une version individuelle de politisation) ou dans certaines mobilisations sociales. Je crois que nous n’avons pas encore pris la mesure de ce que porte avec lui ce phénomène et je suis convaincue de l’intérêt de tracer, par l’enquête, ces recompositions numériques.

Notes :

1 Nicolas Colin et Henri Verdier, L’Âge de la multitude. Entreprendre et innover après la révolution numérique, Paris, Armand Colin, 2012 (1ère édition).

2 Michael Hardt et Antonio Negri, Multitude, Guerre et démocratie à l’âge de l’Empire, trad. Nicolas Guilhot, Paris, La Découverte, 2004.

3 Nicolas Colin et Henri Verdier, L’Âge de la multitude. Entreprendre et innover après la révolution numérique, ; ris, Armand Colin, 2012 (2e édition), p. 246.

4 Plus précisément, la première mention de cette formule par Tim O’Reilly remonte au printemps 2009 et a été présentée au public début septembre de la même année lors du sommet Gov 2.0 à Washington D.C., puis dans un billet publié sur le site d’information spécialisé dans l’innovation numérique TechCrunch. Tim O’Reilly, « Gov 2.0: It’s all about the platform, Techcrunch », 4 septembre 2009, en ligne : https://techcrunch.com/2009/09/04/gov-20-its-all-about-the-platform/?guccounter=1. L’argumentaire est repris et déployé dans un article qui deviendra une référence : Tim O’Reilly, “Government as a Platform”, Innovations, vol. 6, no 1, 2011, p. 13-40.

5 Maison blanche, “Digital Government: Building a 21st-century Platform to Better Serve the American People”, Washington, DC, 23 May 2012

6 Evegeny Morozov, To save everything, click here: The folly of technological solutionism. New-York, Public Affairs, 2013.

7 Nicolas Colin et Henri Verdier, L’Âge de la multitude. Entreprendre et innover après la révolution numériqueParis, Armand Colin, 2012 (2e édition), p. 243.

8 Idem, p. 254.

9 Décret n° 2011-193 du 21 février 2011 portant création d’une direction interministérielle des systèmes d’information et de communication de l’Etat ; puis article 5 du décret n° 2015-1165 du 21 septembre 2015 relatif au secrétariat général pour la modernisation de l’action publique.

10 Philippe Bezes et Patrick Le Lidec, « Politiques de la fusion. Les nouvelles frontières de l’État territorial », Revue française de science politique, vol. 66, no. 3-4, 2016, pp. 507-541.

11 Circulaire no5764/SG du 20 janvier 2015