Entamée pendant la campagne présidentielle, la conversion de la Silicon Valley au trumpisme semble désormais achevée. Les principaux leaders de la tech figuraient au premier rang des invités à la cérémonie d’investiture de Donald Trump, qui a donné des gages à cette industrie au cours de son discours. Ce ralliement a surpris de nombreux observateurs, tant la Silicon Valley est généralement associée au progressisme et au Parti démocrate. Loin d’être une bifurcation idéologique en forme de réaction aux prétendus excès de la gauche américaine, cette conversion est motivée par des enjeux économiques et des questions de pouvoir bien identifiables. Reste à savoir si les contradictions qui opposent les géants de la tech à la base électorale de Donald Trump finiront par faire imploser cette alliance bancale.

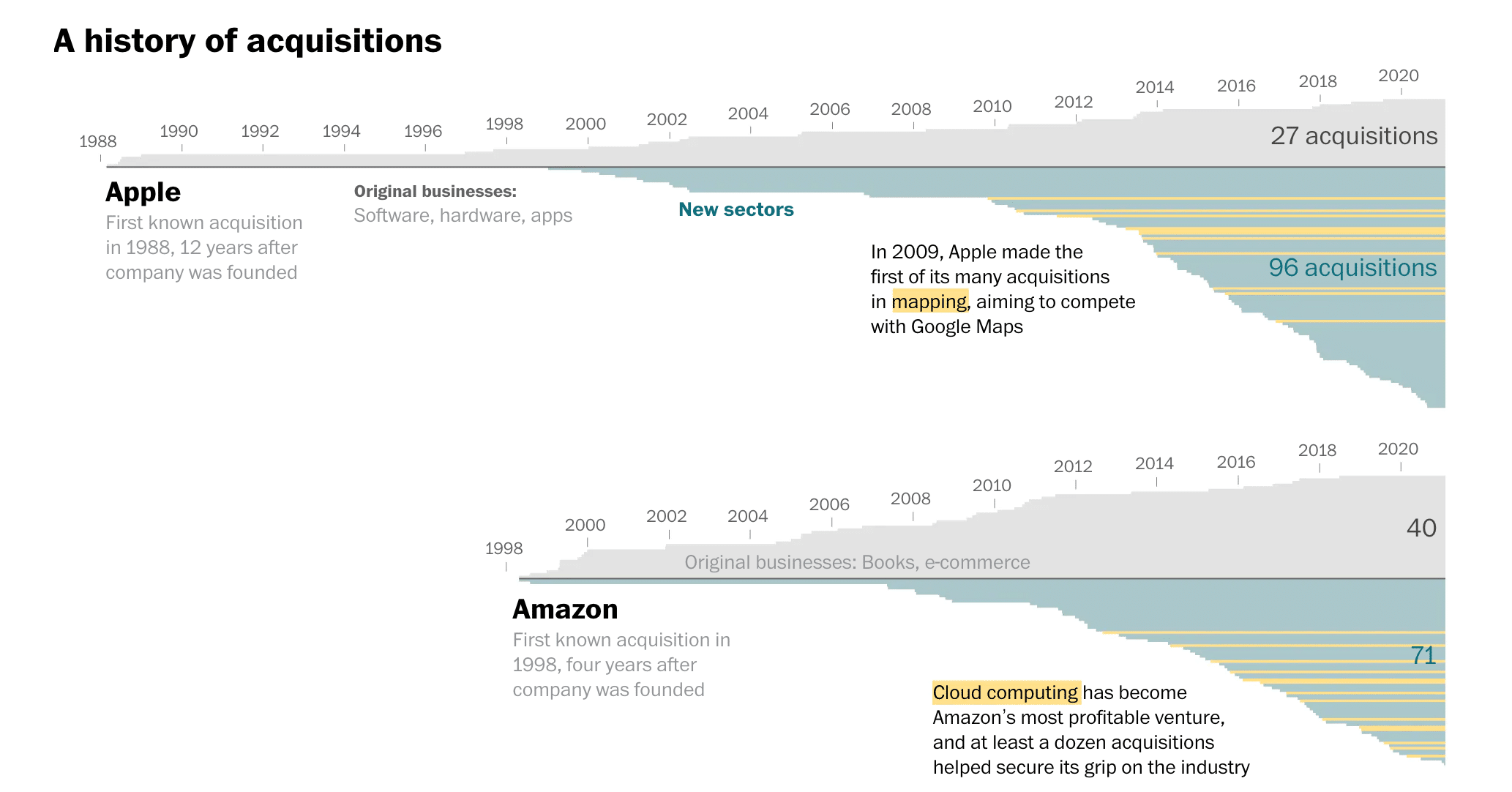

À la fin du film Le Parrain, lorsque Michael Corleone vient d’éliminer ses rivaux, les lieutenants de la mafia américaine le retrouvent dans son bureau pour lui baiser la main et prêter allégeance. Le triomphe électoral de Donald Trump a provoqué une réaction similaire au sein de la Silicon Valley. Dès l’annonce des résultats, les grands patrons de la tech se sont précipités pour féliciter le « Don ». Même Tim Cook, PDG d’Apple, y est allé de sa courbette. Tous ont donné entre 1 et 2 millions de dollars au fonds d’organisation de sa cérémonie d’investiture. Amazon, Microsoft, Google, Meta, Tim Cook, Sam Altman (OpenAI), Elon Musk, Uber, Spotify… il ne manquait personne à l’appel. La plupart de ces entreprises et milliardaires n’avaient rien donné à Joe Biden quatre ans plus tôt. Mais les signes d’allégeance ne se sont pas limités à des versements vers un fonds opaque, non régulé et dont le surplus de trésorerie pourra être utilisé à la discrétion du Président.

Opération séduction

Le ralliement d’Elon Musk et de nombreux gros investisseurs de la Silicon Valley (Marc Andresseen, Peter Thiel, SoftBank, Chamath Palihapitiya, David Sacks, Larry Ellison…) est antérieur à sa victoire électorale. Il prenait la forme de déclarations de soutien, participation à la campagne et dons financiers conséquents. Mais d’autres grands noms de la tech et entreprises majeures avaient soutenu Kamala Harris ou pris soin de rester neutres. Cela a changé dès l’annonce des résultats.

Jeff Bezos a probablement été le premier à ouvrir la danse. Quelques jours avant l’élection, il a censuré la publication du traditionnel éditorial de son journal, le Washington Post, qui devait appeler à voter Kamala Harris. Une fois l’élection passée, Bezos a bloqué la publication d’un dessin de presse caricaturant les patrons de la tech s’agenouillant devant Trump. Puis Amazon Prime, le service de streaming de l’entreprise dont il est resté le principal actionnaire, a offert 40 millions de dollars à Melania Trump pour produire un documentaire sur la première dame. Documentaire dont la réalisation a été confiée à un réalisateur déchu et très proche de Trump. Si cela ne suffisait pas, Amazon vient de mettre fin à ses politiques d’inclusion et antidiscriminatoires (DEI).

Jeff Bezos a probablement été le premier à ouvrir la danse. Quelques jours avant l’élection, il a censuré la publication du traditionnel éditorial de son journal, le Washington Post, qui devait appeler à voter Kamala Harris.

Mark Zuckerberg a suivi les pas de Marc Andresseen en donnant un interview-fleuve à Joe Rogan, soutien de Donald Trump et premier podcasteur du pays. Le patron de Meta (Facebook, Instagram, WhatsApp) en a profité pour critiquer les démocrates et valider les obsessions de la droite trumpiste. Il avait déjà fait un appel du pied à Trump pendant la campagne en le qualifiant de « badass » suite à la tentative d’assassinat dont il avait été victime. Un compliment curieux lorsqu’on sait que Trump avait menacé Zuckerberg de prison pour avoir suspendu son compte Facebook pendant deux ans, suite à sa tentative de subvertir le résultat des élections de 2020.

Pour officialiser son ralliement, Zuckerberg ne s’est pas contenté du don financier mentionné en introduction. Il a calibré la décision portant sur la suppression de la modération du contenu sur ses réseaux sociaux avec les équipes de Trump et mis fin à de nombreuses politiques internes visant à protéger les minorités ou encourager la diversité. Une manière de rejoindre en grande pompe le camp réactionnaire dans sa guerre culturelle contre le « wokisme » et la « cancel culture ». Ce revirement revient probablement à mettre Facebook et Instagram au service de Trump. Il s’est accompagné d’un accord élaboré avec les avocats de Trump pour que Meta verse 25 millions de dollars de dommage et intérêt à ce dernier. Il poursuivait Facebook au civil en espérant obtenir des dédommagements suite à la suspension de son compte. Trump avait peu de chance de gagner son procès, cet accord à l’amiable tombe à pic.

Le PDG de Tik Tok, interdit aux Etats-Unis quelques jours auparavant, s’inscrit dans une démarche révérencieuse similaire, au point d’utiliser son réseau social pour chanter les louanges de Donald Trump, afin d’espérer un retour en grâce. Lui aussi était présent à l’inauguration. Tout cela a débouché sur une photo digne du Parain, où les pontes de la Silicon Valley trustaient le premier rang de la cérémonie d’investiture, devant les soutiens historiques et élus assurant des fonctions protocolaires.

En 2017, pour éviter de s’aliéner leurs employés, perdre leurs clients et nuire à leur image de marque, ces dirigeants avaient pris soin de garder leurs distances avec Donald Trump, au moins publiquement. Ce changement de comportement peut en partie s’expliquer par les récentes difficultés du secteur et plans de licenciement, qui ont inversé le rapport de force employé-employeur, dans un contexte où les consommateurs sont devenus captifs de ces grands monopoles et peu susceptibles de renoncer à leurs services.

Un ralliement plus opportuniste qu’idéologique

À en croire des personnalités comme Elon Musk, Mark Zuckerberg ou Marc Andresseen, la principale cause du ralliement de la Silicon Valley à Donald Trump serait à chercher du côté des démocrates. La gauche américaine et les libéraux sont accusés d’avoir cédé aux sirènes du « wokisme » tout en s’attaquant à la liberté d’expression. Les soi-disant persécutions judiciaires du DOJ (Departement of Justice, l’équivalent du ministère de la Justice) et du FBI contre Donald Trump sont parfois également citées. Tout comme la tentative d’assassinat à son encontre, qui serait le produit de la complaisance du FBI et de l’extrémisme de la gauche américaine, accusés d’avoir injustement repeint l’ancien Président en dangereux putschiste autocrate. C’est après l’inculpation de Donald Trump que l’influent David Sacks (ex-PayPal) avait appelé à voter pour lui. Et après la tentative d’assassinat que son vieil ami Elon Musk avait officialisé son soutien.

L’idée d’un ralliement idéologique contraint par la radicalisation du camp démocrate est défendue en France par des « experts » comme Fabrice Epelboin (dans Le Point, sur C Ce Soir…) et reprise par de nombreux commentateurs. Elle ignore superbement les faits.

La Silicon Valley n’en est pas à son premier revirement réactionnaire. À ses origines, l’Université de Stanford, située au cœur de la vallée, jouait un rôle central dans la diffusion des thèses eugénistes qui eurent une emprise durable sur la tech. En particulier dans l’entre-deux guerre. William Shockley, l’un des inventeurs du transistor, était un eugéniste et raciste bien connu. Si la contre-culture hippie des années 1960 a donné une coloration progressiste aux géants de la tech, les années 1990 ont été marquées par un retour de la pensée réactionnaire. Des politiciens comme Newt Gingrich, un temps numéro un du Parti républicain et élu de Californie, avaient pris appui sur des figures aussi influentes que Georges Gilder pour poser les jalons d’un internet néolibéral et conservateur. La Hoover Institution et de nombreux think tanks conservateurs ont par ailleurs exercé une influence importante sur cette période cruciale, avant que des individus comme Peter Thiel reprennent le flambeau.

Avant son rachat contraint de Twitter, Musk méprisait déjà la liberté d’expression, par ses attaques répétées contre les journalistes, critiques et lanceurs d’alertes. Suite à cette acquisition, il ne s’est pas contenté de diffuser les Twitter files qui ont montré que démocrates comme républicains contactaient régulièrement la plateforme pour demander la suppression de certains contenus. Il a surtout entrepris d’imposer sa propre censure avant d’interférer publiquement en faveur de Donald Trump au cours de la campagne 2024.

Elon Musk a multiplié les déclarations publiques polémiques bien avant son rachat de Twitter. Rappelons qu’il avait traité un secouriste de pédophile, minimisé l’épidémie de Covid, soutenu publiquement le coup d’État de l’extrême droite bolivienne en 2020 pour empêcher la nationalisation du lithium et qu’il profère des vues eugénistes depuis longtemps. Son usine Tesla californienne était surnommée « la plantation » à cause du racisme systémique qu’il y tolérait. En 2017, malgré le tollé provoqué par le « muslim ban » de Trump, Musk avait refusé de critiquer le président et défendu sa participation à son Conseil économique. L’idée que Musk serait un progressiste libéral soudainement converti à l’extrême droite est plutôt contestable. En 2014, il proclamait « Fuck la Terre. Sérieusement, on s’en fout de la Terre ». Et son obsession pour le « virus wokiste » qui « va détruire la civilisation » débute fin 2021, douze mois avant son rachat de Twitter.

De même, Zuckerberg partage depuis longtemps des opinions conservatrices. Il était déjà proche de l’administration Trump pendant son premier mandat. Son entreprise Meta est connue pour sa pratique d’une forme de censure et la promotion arbitraire de contenus favorables à l’extrême droite américaine et au gouvernement israélien.

Certains pontes de la Silicon Valley, comme Peter Thiel et Larry Ellison, ont toujours soutenu Trump. D’autres ont pris le train en marche au moment qui leur semblait le plus opportun. Chez Elon Musk, la rupture avec les démocrates est concomitante avec les premières tentatives de syndicalisation dans ses usines Tesla, en 2017. L’administration Biden a soutenu ces efforts, promu le syndicalisme (en particulier dans l’industrie automobile) et poursuivi ou entamé de nombreuses enquêtes ciblant les abus et multiples violations de la loi dont est accusé Tesla (droit du travail, normes environnementales, discriminations, sécurité routière…). La Californie est en passe d’interdire les ventes de Tesla sur son territoire du fait des abus constaté avec la fonction Autopilot, faussement présenté comme un système de conduite autonome.

Autrement dit, Musk a tombé le masque progressiste lorsque ses intérêts économiques l’exigeaient. Certains autres géants de la Silicon Valley basculent plus tardivement (Sam Altman) et prudemment (Tim Cook). Mais, quel que soit le degré de proximité idéologique de ces patrons, ce n’est pas par ce prisme qu’on peut comprendre une telle cascade de ralliements.

Ce que les barons de la Silicon Valley espèrent obtenir de Donald Trump

Interrogé par l’ancienne vedette de Fox News, Tucker Carlson, Musk avait déclaré « si Trump perd, je suis foutu ». Il faisait référence aux nombreuses enquêtes fédérales ciblant ses entreprises, dans le contexte d’une baisse des ventes et d’un effondrement des marges de Tesla, de plus en plus concurrencé par les constructeurs chinois comme BYD. Désormais à la tête du Ministère de l’efficacité publique (Department of Government Efficiency, nommé ainsi pour coller à l’acronyme DOGE, du nom de sa cryptomonnaie favorite, initialement conçue comme une parodie du Bitcoin), Musk va pouvoir purement et simplement supprimer les instances gouvernementales enquêtant sur ou chargées de réguler ses activités.

Pour les milliardaires de la tech, le ralliement à Donald Trump présente de nombreuses opportunités : baisses d’impôts anticipées (sur les multinationales et les individus), dérégulations ciblées et contrats publics gargantuesques. Musk et Bezos dépendent de la NASA et du Pentagone pour rentabiliser leurs entreprises spatiales (Blue Origin et SpaceX), dans lesquelles ils ont investi des sommes considérables. Mark Zuckerberg espère que Donald Trump va tuer son principal concurrent (Tik Tok) et protéger Facebook des amendes encourues à l’étranger. Sam Altman et Larry Ellison ont obtenu un coup de pouce inespéré de Trump pour leur projet « Stargate » à 500 milliards.

Amazon est menacé par le regain de syndicalisme que l’administration Biden soutenait et que Trump a déjà promis d’écraser. Google est ciblé par des procès antitrust conduits par la FTC de Biden. Peter Thiel compte sur la politique anti-immigration et militariste pour continuer d’obtenir des contrats juteux pour ses sociétés de surveillance, Palantir et Anduril. Google, Amazon, Oracle et Microsoft comptent parmi les principaux bénéficiaires de contrats de défense chiffrés en dizaine de milliards de dollars. Au minimum, ils ont intérêt à ne pas trop froisser la nouvelle administration pour éviter que le flot d’argent public ne se tarisse.

Pour les milliardaires de la tech, le ralliement à Donald Trump présente de nombreuses opportunités : baisses d’impôts, dérégulation et contrats publics gargantuesques.

Mais les géants de la tech comptent aussi sur Trump pour poursuivre l’impérialisme économique dont ils bénéficient depuis des années, que ce soit en faisant pression sur les autres pays pour empêcher le prélèvement d’impôts sur le chiffre d’affaires, défaire les régulations, obtenir des clauses particulières dans les accords commerciaux ou atténuer le montant des amendes et sanctions auxquelles ils s’exposent. Lors de sa rencontre avec Trump, Tim Cook a évoqué les difficultés d’Apple avec la justice européenne, par exemple.

Par le passé, l’État américain a aidé ses champions de la tech à s’imposer sur la scène internationale tout en empêchant autant que possible l’émergence de concurrents. Le constructeur chinois de smartphones Huawei a été largement banni des États-Unis et l’Union européenne a été contrainte de renoncer à ses services pour mettre en place son réseau 5G. Les diplomates américains sont également souvent intervenus auprès des gouvernements européens en faveur de nombreuses entreprises technologiques, comme l’ont révélé les Uber files.

Le tour d’horizon ne serait pas complet sans mentionner l’industrie des cryptomonnaies, qui a dépensé des sommes colossales et inédites pour faire élire Trump, dans l’espoir d’obtenir des dérégulations et législations favorables. Or, de nombreux gros investisseurs de la Silicon Valley cités plus haut détiennent des intérêts importants dans ce secteur. De manière générale, se rapprocher de Trump permet d’éviter ses foudres potentielles tout en se positionnant pour profiter de sa politique. Apple et Amazon l’ont bien compris, et augmentent de nouveau leurs achats d’espaces publicitaires sur le réseau social de Musk, l’autre homme fort de Washington.

Au-delà des intérêts particuliers, une nouvelle vision pour la Silicon Valley

En pleine campagne électorale, le plus gros fonds d’investissement en capital risque, Andresseen Horowitz, a détaillé une vision alternative à celle proposée de manière souvent incohérente par les démocrates. Intitulé « The little tech agenda », ce manifeste pro-startup dénonce une régulation et une taxation excessives. En résumé, il s’agit de libérer les énergies créatrices des startups en dérégulant le secteur et en mettant en place des baisses d’impôts et exonérations fiscales. Loin de défendre uniquement les « petits », il s’agit surtout de supprimer toute entrave au développement accéléré des dernières lubies de la Silicon Valley : l’Intelligence artificielle, les cryptomonnaies, la blockchain et le commerce des données.

Il s’agit de supprimer toute entrave au développement accéléré des dernières lubies de la Silicon Valley : l’Intelligence artificielle, les cryptomonnaies, la blockchain et le commerce des données.

Parmi les cibles principales, on retrouve deux des agences gouvernementales les plus populaires de l’administration Biden : la FTC (Federal Trade Commission) et le CFPB (Consumer Financial Protection Bureau). Sous la direction de Lina Khan, le premier a tenté de briser les monopoles des Big Tech via les lois antitrust, au nom de la compétitivité et de la protection des consommateurs. Le second, mis en place par Elizabeth Warren lors du premier mandat de Barack Obama à la suite de la crise des subprimes, lutte contre les fraudes financières et vise à protéger les consommateurs des abus des organismes de crédits prédateurs. Sous Biden, cet organisme a restitué plus de 6 milliards de dollars aux consommateurs américains victimes des abus, et infligé près de 4 milliards de dollars d’amendes. Ce n’est pas tout à fait par hasard que des patrons comme Zuckerberg, Musk et Marc Andresseen se sont succédés au micro de Joe Rogan pour dire tout le mal qu’ils pensaient du CFPB et de Lina Khan. Depuis, Trump a limogé les directeurs de ces deux agences.

Les questions de sécurité, de défense et de surveillance constituent un autre front commun assumé de plus en plus publiquement. En septembre dernier, Larry Ellison (Oracle) détaillait sa vision d’une société sous surveillance généralisée. Une idée qu’il défend depuis trois décennies, remise au gout du jour en vantant les nouvelles capacités permises par l’IA. Microsoft, Google et OpenAI ont été critiqués pour leur implication dans le génocide à Gaza. La société Anduril de Thiel vient de signer des partenariats avec OpenAI pour obtenir des contrats militaires. Sam Altman franchit ainsi une ancienne ligne rouge d’OpenAI, initialement conçue comme une entreprise à but non lucratif, fonctionnant sur le principe open source du logiciel libre en se tenant à l’écart du secteur militaire.

Toutes ces initiatives s’inscrivent dans un projet global et publiquement assumé. Marc Andresseen admet, comme les patrons des géants de l’IA, avoir pour but de remplacer un maximum d’emplois par de l’IA pour provoquer un affaissement généralisé des salaires. À cette vision dystopique s’ajoute la promotion de la surveillance de masse, de la monétisation à outrance de nos données personnelles et de la privatisation de l’espace. Un développement qui, à en croire tant l’ancien patron de Google que Bill Gates, doit s’accélérer malgré la crise climatique, qui ne sera résolue que par la technologie et le développement d’une IA supra-humaine…

Premières victoires, premières difficultés

Avec l’élection de Donald Trump, les patrons et financiers de la Silicon Valley ont obtenu ce qu’ils voulaient. L’appréciation des valeurs boursières sur lesquelles reposent leurs fortunes leur a assuré un retour sur investissement immédiat, tout comme la flambée du Bitcoin auquel nombre d’entre eux sont exposés. Au même moment, Trump offrait aux principaux barons de la tech un accès sans précédent aux cercles de pouvoir de Washington.

Marc Andresseen place de nombreux alliés à des postes clés. Peter Thiel dispose de son protégé au cœur du pouvoir, en la personne du vice-président JD Vance, dont il finance la carrière depuis des années. Mais c’est Elon Musk qui est parvenu à tirer des bénéfices sans précédent de son rapprochement avec Donald Trump. Non content d’être le seul individu extérieur à avoir été inclus sur la photo de famille post-électorale, il a obtenu un quasi-ministère sans avoir à se soumettre au processus de nomination sanctionné par le Congrès, avec les auditions sous serment qui l’accompagne. En effet, Trump a renommé par décret l’agence responsable du numérique créé par Obama, le « DOGE ». Ses prérogatives sont larges et définies de manière floue, mais permettent à Elon Musk d’obtenir un accès privilégié aux informations détenues par les administrations fédérales. Il a déjà commencé à utiliser cette agence pour réaliser une sorte de mini-putch inspiré de sa prise de contrôle désastreuse de Twitter et placer des alliés au cœur de l’administration, en plus de jeunes gens non diplômés et inexpérimentés. Sans provoquer de protestation au sein du Parti républicain.

Fin décembre 2024, alors que Trump n’était pas encore investi président, le Congrès devait voter une loi de financement de l’État fédéral pour éviter un gel du fonctionnement de l’État. Le texte budgétaire résultait de plusieurs mois de négociations entre démocrates et républicain. Sous prétexte de vouloir « réduire le gaspillage de l’argent public », Musk a mené une intense campagne de lobbying pour faire échouer le vote, utilisant sa plateforme X pour demander à ses abonnés de téléphoner à leurs élus tout en menaçant ces derniers de trouver des adversaires bien financés face à eux lors des primaires aux élections de mi-mandats. Trump, qui espérait obtenir par ce chantage la levée du plafonnement de la dette et ainsi affaiblir la capacité de blocage des démocrates pour la suite de son mandat, s’est rangé derrière Musk.

Suite à la capitulation des élus républicains, le texte a été bloqué au Congrès. Pour éviter un « shutdown » du gouvernement la veille des fêtes de fin d’année, démocrates et républicains se sont rapidement mis d’accord pour voter un prolongement du budget incluant les priorités négociées auparavant. Mais de nombreux compromis qui avaient été inclus dans le texte initial ont été abandonnés. Dont l’amendement protectionniste vis-à-vis de la Chine qui menaçait directement les intérêts de Tesla, et donc d’Elon Musk. Ce dernier a obtenu ce qu’il voulait, contrairement à Donald Trump.

Le second point de tension a concerné le débat sur le sort des visas H1B, ces permis de travail soumis à un quota et réservés aux travailleurs diplômés sponsorisés par une entreprise désirant les embaucher. La Silicon Valley utilise ces visas pour importer de la matière grise à moindres frais, exerçant au passage une pression à la baisse sur les salaires des ingénieurs américains. Parce que l’essentiel des bénéficiaires de ce programme est issu de l’Inde et de l’Asie, les idéologues d’extrême droite proches de Trump veulent supprimer le programme. Inversement, Musk a pris position en faveur de ce dispositif, dont il a bénéficié lui-même par le passé. Sur X (ex-Twitter), il a argumenté que le secteur de la tech américain en dépend pour son succès, avant d’ajouter qu’il se battrait de toutes ses forces pour ce programme.

Le second point de tension concerne les visas H1B. La Silicon Valley utilise ces visas pour importer de la matière grise à moindres frais ; les idéologues d’extrême droite proches de Trump veulent supprimer le programme.

Cette sortie lui a attiré les foudres de la base militante pro-Trump et d’idéologues comme Stephen Miller (le monsieur immigration de Trump) et Steve Bannon. Musk s’est pris un retour de bâton inhabituel par l’intensité et la violence, bien que Trump soit intervenu dans le débat en faveur du programme H1B. Depuis, Musk a tenté de se réconcilier avec la base MAGA en soutenant des figures d’extrême droite au Royaume-Uni et en Allemagne, tout en commençant à censurer méthodiquement de nombreux comptes X qui l’avaient pris à parti.

La dernière friction interne est intervenue dès l’annonce en grande pompe d’un plan d’investissement de 500 milliards dans l’Intelligence artificielle, lors d’une conférence de presse organisée le lendemain de la passation de pouvoir. Flanqué des PDG d’OpenAI (le grand rival de Musk), Oracle et SoftBank, Trump a vanté le projet « Stargate ». Musk s’en est aussi pris au consortium via X. Si les conseillers de Trump étaient furieux de l’attitude du patron de Tesla, accusé de « saboter Trump », ce dernier a balayé ce conflit interne d’un haussement d’épaules en concédant simplement que « Musk déteste un des dirigeants qui fait partie du deal ».

Ces quelques exemples montrent à quel point l’alliance entre Trump et la Silicon Valley revêt un caractère inédit, tout en soulignant la fragilité de l’attelage. La coalition Trump est constituée de factions aux intérêts souvent contradictoires, lorsqu’ils ne sont pas des concurrents majeurs.

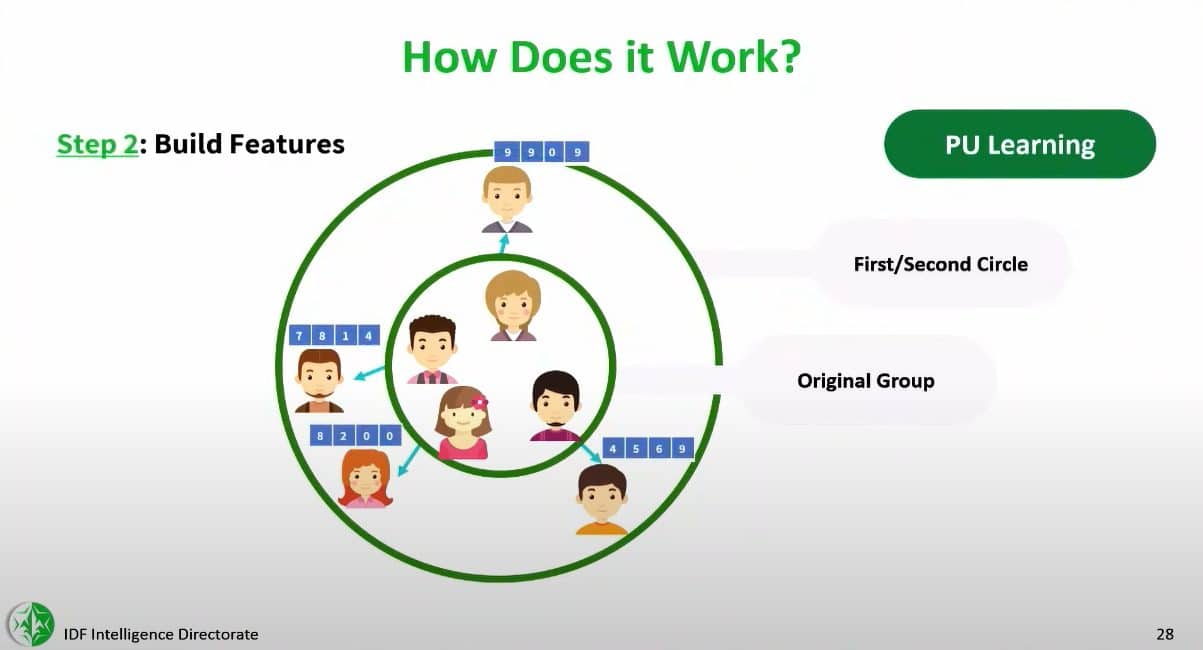

Tous conservent néanmoins un but commun : dépecer l’État social et démanteler les agences de régulation fédérales, tout en accaparant l’argent public via des contrats juteux et mobiliser la doctrine « America First » de Trump à leurs avantages. À ce titre, la récente directive produite par la direction du renseignement pour demander aux différentes agences (CIA, NSA, FBI…) de coopérer plus étroitement et en prenant davantage de risques avec les entreprises de la Silicon Valley confirme que l’on entre dans une nouvelle ère. Celle de la fusion entre l’extrême droite trumpiste et la Silicon Valley.