À l’occasion de la sortie du livre du théoricien critique Ben Tarnoff, Internet for the people, the fight for the future (Verso, 14 juin 2022), le journaliste spécialiste des conséquences politiques du numérique Hubert Guillaud nous propose de mieux comprendre les enjeux de la privatisation de nos biens sociaux (espaces de communications, services publics, industries…) par la numérisation à l’américaine et d’en retracer le fil historique. Un texte essentiel pour se repérer dans les grands enjeux contemporains d’internet (centralisation, décentralisation, articulation des différents réseaux et des différentes échelles, gouvernance privée versus gouvernance publique et intervention des citoyens dans ces transformations). (Partie 2/2)

Coincés dans les plateformes

Les années 90 sont les années du web. En 1995, l’internet ne ressemble plus tout à fait à un réseau de recherche. Avec 45 millions d’utilisateurs et 23 500 sites web, l’internet commence à se transformer. Chez Microsoft, Bill Gates annonce qu’internet sera leur priorité numéro un. Jeff Bezos lance Amazon. Pierre Omidyar AuctionWeb, qui deviendra eBay. C’est le début des grandes entreprises de l’internet, de celles qui deviendront des « plateformes », un terme qui mystifie plus qu’il n’éclaircit, qui permet de projeter sur la souveraineté qu’elles conquièrent une aura d’ouverture et de neutralité, quand elles ne font qu’ordonner et régir nos espaces digitaux. Si la privatisation d’internet a commencé par les fondements, les tuyaux, au mitan des années 90, cette phase est terminée. « La prochaine étape consistera à maximiser les profits dans les étages supérieurs, dans la couche applicative, là où les utilisateurs utilisent l’internet ». C’est le début de la bulle internet jusqu’à son implosion.

eBay a survécu au crash des années 2000 parce qu’elle était l’une des rares exceptions aux startups d’alors. eBay avait un business model et est devenu très rapidement profitable. eBay a aussi ouvert un modèle : l’entreprise n’a pas seulement offert un espace à l’activité de ses utilisateurs, son espace a été constitué par eux, en les impliquant dans son développement, selon les principes de ce qu’on appellera ensuite le web 2.0. La valeur technique de l’internet a toujours été ailleurs. Sociale plus que technique, estime Tarnoff (pour ma part, je pense que ce n’est pas si clair, l’industrialisation inédite qui s’est construite avec le numérique, n’est pas uniquement sociale, elle me semble surtout économique et politique).

En 1971, quand Ray Tomlinson invente le mail, celui-ci devient très rapidement très populaire et représente très vite l’essentiel du trafic du premier réseau. L’e-mail a humanisé le réseau. Les échanges avec les autres sont rapidement devenu l’attraction principale. Avec eBay, Omidyar va réussir à refondre sa communauté en marché. Le succès des plateformes du web 2.0 va consister à «fusionner les relations sociales aux relations de marché », par trois leviers : la position d’intermédiaire (entre acheteurs et vendeurs), la souveraineté (la plateforme façonne les interactions, écrits les règles, fonctionne comme un législateur et un architecte) et bien sûr les effets réseaux (plus les gens utilisent, plus l’espace prend de la valeur). La couche applicative de l’internet va ainsi se transformer en vastes centres commerciaux : des environnements clos, qui vont tirer leurs revenus à la fois de la rente que procurent ces espaces pour ceux qui veulent en bénéficier et de la revente de données le plus souvent sous forme publicitaire (mais pas seulement). La collecte et l’analyse de données vont d’ailleurs très vite devenir la fonction primaire de ces « centres commerciaux en ligne ». « La donnée a propulsé la réorganisation de l’internet », à l’image de Google qui l’a utilisé pour améliorer son moteur, puis pour vendre de la publicité, lui permettant de devenir, dès 2002, profitable. C’est la logique même du Capitalisme de surveillance de Shoshana Zuboff. Une logique qui préexistait aux entreprises de l’internet, comme le raconte le pionnier des études sur la surveillance, Oscar H. Gandy, dans ses études sur les médias de masse, les banques ou les compagnies d’assurances, mais qui va, avec la circulation des données, élargir la surface de sa surveillance.

« Quand le capitalisme transforme quelque chose, il tend à ajouter plus de machinerie »

Malgré toutes ses faiblesses (vous atteignez surtout les catégories produites par les systèmes que la réalité des gens, c’est-à-dire la manière dont le système caractérise les usagers, même si ces caractères se révèlent souvent faux parce que calculés), la surveillance des utilisateurs pour leur livrer de la publicité ciblée va construire les principaux empires des Gafams que nous connaissons encore aujourd’hui. Si la publicité joue un rôle essentiel dans la privatisation, les «Empires élastiques » des Gafams, comme les appels Tarnoff, ne vont pas seulement utiliser l’analyse de données pour vendre des biens et de la publicité, ils vont aussi l’utiliser pour créer des places de marché pour les moyens de production, c’est-à-dire produire du logiciel pour l’internet commercial.

« Quand le capitalisme transforme quelque chose, il tend à ajouter plus de machinerie », rappelle Tarnoff avec les accents de Pièces et Main d’œuvre. Avec les applications, les pages internet sont devenues plus dynamiques et complexes, « conçues pour saisir l’attention des utilisateurs, stimuler leur engagement, liées pour élaborer des systèmes souterrains de collecte et d’analyse des données ». « Les centres commerciaux en ligne sont devenus les lieux d’un calcul intensif. Comme le capitalisme a transformé l’atelier en usine, la transformation capitaliste d’internet a produit ses propres usines », qu’on désigne sous le terme de cloud, pour mieux obscurcir leur caractère profondément industriel. Ces ordinateurs utilisés par d’autres ordinateurs, rappellent l’enjeu des origines du réseau : étendre le calcul et les capacités de calcul. Tarnoff raconte ainsi la naissance, dès 2004, de l’Elastic Compute Cloud (EC2) d’Amazon par Chris Pinkham et Christopher Brown, partis en Afrique du Sud pour rationaliser les entrailles numériques de la machine Amazon qui commençait à souffrir des limites de l’accumulation de ses couches logicielles. EC2 lancé en 2006 (devenu depuis Amazon Web Services, AWS, l’offre d’informatique en nuage), va permettre de vendre des capacités informatiques et d’analyse mesurées et adaptables. Le cloud d’Amazon va permettre d’apporter un ensemble d’outils à l’industrialisation numérique, de pousser plus loin encore la privatisation. Le Big Data puis les avancées de l’apprentissage automatisé (l’intelligence artificielle) dans les années 2010 vont continuer ces accélérations industrielles. La collecte et le traitement des données vont devenir partout un impératif.

La tech est désormais le dernier archipel de super-profit dans un océan de stagnation. Pire, la privatisation jusqu’aux couches les plus hautes d’internet, a programmé la motivation du profit dans tous les recoins du réseau.

Dans le même temps, les utilisateurs ont conquis un internet devenu mobile. L’ordinateur devenant smartphone n’est plus seulement la machine à tout faire, c’est la machine qui est désormais partout, s’intégrant non seulement en ligne, mais jusqu’à nos espaces physiques, déployant un contrôle logiciel jusque dans nos vies réelles, à l’image d’Uber et de son management algorithmique. L’industrialisation numérique s’est ainsi étendue jusqu’à la coordination des forces de travail, dont la profitabilité a été accrue par la libéralisation du marché du travail. La contractualisation des travailleurs n’a été qu’une brèche supplémentaire dans la gestion algorithmique introduite par le déploiement sans fin de l’industrie numérique, permettant désormais de gérer les tensions sur les marchés du travail, localement comme globalement. La force de travail est elle-même gérée en nuage, à la demande. Nous voilà dans le Human Cloud que décrit Gavin Mueller dans Breaking things at Work ou David Weil dans The Fissured Workplace.

Coincés dans les profits !

Les biens réelles abstractions de ces empires élastiques ont enfin été rendues possibles par la financiarisation sans précédent de cette nouvelle industrie. Tout l’enjeu de la privatisation d’internet, à tous les niveaux de la pile, demeure le profit, répète Tarnoff. La financiarisation de l’économie depuis les années 70 a elle aussi profité de cette industrialisation numérique… Reste que la maximisation des profits des empires élastiques semble ne plus suffire. Désormais, les entreprises de la tech sont devenues des véhicules pour la pure spéculation. La tech est l’un des rares centres de profit qui demeure dans des économies largement en berne. La tech est désormais le dernier archipel de super-profit dans un océan de stagnation. Pire, la privatisation jusqu’aux couches les plus hautes d’internet, a programmé la motivation du profit dans tous les recoins du réseau. De Comcast (fournisseur d’accès), à Facebook jusqu’à Uber, l’objectif est resté de faire de l’argent, même si cela se fait de manière très différente, ce qui implique des conséquences sociales très différentes également. Les fournisseurs d’accès vendent des accès à l’internet, au bénéfice des investisseurs et au détriment des infrastructures et de l’égalité d’accès. Dans les centres commerciaux en ligne comme Facebook, on vend la monétisation de l’activité des utilisateurs ainsi que l’appareillage techno-politique qui va avec… Dans Uber ou les plateformes du digital labor, on vend le travail lui-même au moins disant découpé en microtranches et micro-tâches… Mais tous ces éléments n’auraient pas été possibles hors d’internet. C’est la promesse d’innovation technologique qui persuade les autorités de permettre à ces entreprises à déroger aux règles communes, qui persuade les investisseurs qu’ils vont réaliser une martingale mirifique. Mais dans le fond, toutes restent des machines non démocratiques et des machines à produire des inégalités. Toutes redistribuent les risques de la même façon : « ils les poussent vers le bas, vers les plus faibles » (les utilisateurs comme les travailleurs) « et les répandent autour d’eux. Ils tirent les récompenses vers le haut et les concentrent en de moins en moins de mains ».

Pourtant, rappelle Tarnoff, l’action collective a été le meilleur moyen pour réduire les risques, à l’image des régulations qu’ont obtenues dans le passé les chauffeurs de taxis… jusqu’à ce qu’Uber paupérise tout le monde. L’existence des chauffeurs est devenue plus précaire à mesure que la valorisation de l’entreprise s’est envolée. Le risque à terme est que la machine néolibérale programmée jusqu’au cœur même des systèmes, ubérise tout ce qui reste à ubériser, de l’agriculture à la santé, des services public à l’école jusqu’au développement logiciel lui-même.

Pourtant, les centres commerciaux en ligne sont très gourmands en travail. Tous ont recours à une vaste force de travail invisible pour développer leurs logiciels, les maintenir, opérer les centres de données, labéliser les données… La sociologue Tressie McMillan Cottom parle d’« inclusion prédatrice » pour qualifier la dynamique de l’économie politique d’internet. C’est une logique, une organisation et une technique qui consiste à inclure les marginalisés selon des logiques extractives. C’est ce que montrait Safiya Umoja Noble dans Algorithms of oppression : les « filles noires » que l’on trouve dans une requête sur Google sont celles des sites pornos, les propositions publicitaires qui vous sont faites ne sont pas les mêmes selon votre niveau de revenu ou votre couleur de peau. Les plus exclus sont inclus, mais à la condition qu’ils absorbent les risques et renoncent aux moindres récompenses. L’oppression et les discriminations des espaces en ligne sont désormais le fait d’une boucle de rétroaction algorithmique qui ressasse nos stéréotypes pour ne plus s’en extraire, enfermant chacun dans les catégories que spécifie la machine. Nous sommes désormais pris dans une intrication, un enchevêtrement d’effets, d’amplification, de polarisation, dont nous ne savons plus comment sortir.

« L’exploitation des travailleurs à la tâche, le renforcement des oppressions sexistes ou racistes en ligne, l’amplification de la propagande d’extrême-droite… aucun de ces dommages sociaux n’existeraient s’ils n’étaient pas avant tout profitables. »

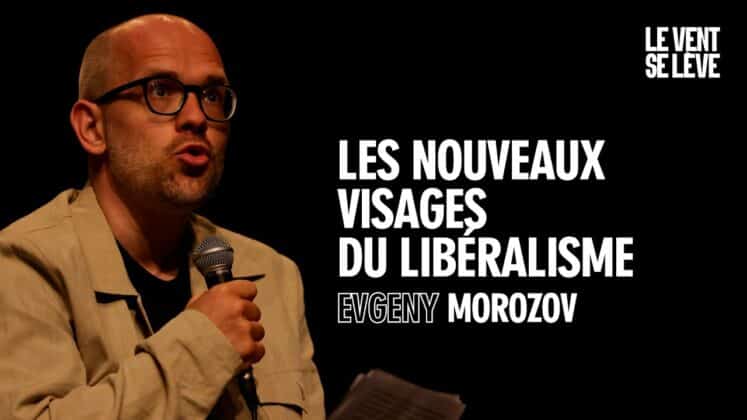

Les inégalités restent cependant inséparables de la poursuite du profit pour le profit. La tech est devenuel’équivalent de l’industrie du Téflon. Pour l’instant, les critiques sont mises en quarantaine, limitées au monde de la recherche, à quelques activistes, à quelques médias indépendants. Le techlash a bien entrouvert combien la tech n’avait pas beaucoup de morale, ça n’empêche pas les scandales des brèches de données de succéder aux scandales des traitements iniques. Réformer l’internet pour l’instant consiste d’un côté à écrire de nouvelles réglementations pour limiter le pouvoir de ces monopoles. C’est le propos des New Brandeisians (faisant référence à l’avocat américain Louis Brandeis, grand réformateur américain) qui veulent rendre les marchés plus compétitifs en réduisant les monopoles des Gafams. Ces faiseurs de lois ont raison : les centres commerciaux en ligne ne sont pas assez régulés ! Reste qu’ils souhaitent toujours un internet régi par le marché, plus compétitif que concentré. Pourtant, comme le souligne Nick Srnicek, l’auteur deCapitalisme de plateforme, c’est la compétition, plus que la taille, qui nécessite toujours plus de données, de traitements, de profits…

Pour Tarnoff, il y a une autre stratégie : la déprivatisation. « Que les marchés soient plus régulés ou plus compétitifs ne touchera pas le problème le plus profond qui est le marché lui-même. Les centres commerciaux en ligne sont conçus pour faire du profit et faire du profit est ce qui construit des machines à inégalités ».« L’exploitation des travailleurs à la tâche, le renforcement des oppressions sexistes ou racistes en ligne, l’amplification de la propagande d’extrême-droite… aucun de ces dommages sociaux n’existeraient s’ils n’étaient pas avant tout profitables. » Certes, on peut chercher à atténuer ces effets… Mais le risque est que nous soyons en train de faire comme nous l’avons fait avec l’industrie fossile, où les producteurs de charbon se mettent à la capture du CO2 plutôt que d’arrêter d’en brûler ! Pour Tarnoff, seule la déprivatisation ouvre la porte à un autre internet, tout comme les mouvements abolitionnistes et pour les droits civiques ont changé la donne en adressant finalement le coeur du problème et pas seulement ses effets (comme aujourd’hui, les mouvements pour l’abolition de la police ou de la prison).

Mais cette déprivatisation, pour l’instant, nous ne savons même pas à quoi elle ressemble. Nous commençons à savoir ce qu’il advient après la fermeture des centres commerciaux (les Etats-Unis en ont fermé beaucoup) : ils sont envahis par les oiseaux et les mauvaises herbes ! Sur l’internet, bien souvent, les noms de domaines abandonnés sont valorisés par des usines à spam ! Si nous savons que les réseaux communautaires peuvent supplanter les réseaux privés en bas de couche technologique, nous avons peu d’expérience des alternatives qui peuvent se construire en haut des couches réseaux.

Nous avons besoin d’expérimenter l’alternet !

Nous avons besoin d’expérimenter. L’enjeu, n’est pas de remplacer chaque centre commercial en ligne par son équivalent déprivatisé, comme de remplacer FB ou Twitter par leur clone placé sous contrôle public ou coopératif et attendre des résultats différents. Cela nécessite aussi des architectures différentes. Cela nécessite d’assembler des constellations de stratégies et d’institutions alternatives, comme le dit Angela Davisquand elle s’oppose à la prison et à la police. Pour Tarnoff, nous avons besoin de construire une constellation d’alternatives. Nous devons arrêter de croire que la technologie doit être apportée aux gens, plutôt que quelque chose que nous devons faire ensemble.

Comme le dit Ethan Zuckerman dans sa vibrante défense d’infrastructures publiques numériques, ces alternatives doivent être plurielles dans leurs formes comme dans leurs buts, comme nous avons des salles de sports, des bibliothèques ou des églises pour construire l’espace public dans sa diversité. Nous avons besoin d’une décentralisation, non seulement pour combattre la concentration, mais aussi pour élargir la diversité et plus encore pour rendre possible d’innombrables niveaux de participation et donc d’innombrables degrés de démocratie. Comme Zuckerman ou Michael Kwet qui milite pour un « socialisme numérique » avant lui, Tarnoff évoque les logiciels libres, open source, les instances distribuées, l’interopérabilité…, comme autant de leviers à cet alternumérisme. Il évoque aussi une programmation publique, un cloud public comme nous avons finalement des médias publics ou des bibliothèques. On pourrait même imaginer, à défaut de construire des capacités souveraines, d’exiger d’Amazon de donner une portion de ses capacités de traitements, à défaut de les nationaliser. Nous avons besoin d’un secteur déprivatisé plus gros, plus fort, plus puissant.

C’est oublier pourtant que ces idées (nationaliser l’internet ou Google hier, AWS demain…) ont déjà été émises et oubliées. Déconsidérées en tout cas. Tarnoff oublie un peu de se demander pourquoi elles n’ont pas été mises en œuvre, pourquoi elles n’ont pas accroché. Qu’est-ce qui manque au changement pour qu’il ait lieu ?, semble la question rarement posée. Pour ma part, pourtant, il me semble que ce qui a fait la différence entre l’essor phénoménal de l’internet marchand et la marginalité des alternatives, c’est assurément l’argent. Même si on peut se réjouir de la naissance de quelques coopératives, à l’image de Up&Go, CoopCycle ou nombre de plateformes coopératives, les niveaux d’investissements des uns ne sont pas les niveaux d’investissements des autres. Le recul des politiques publiques à investir dans des infrastructures publiques, on le voit, tient bien plus d’une déprise que d’une renaissance. Bien sûr, on peut, avec lui, espérer que les données soient gérées collectivement, par ceux qui les produisent. Qu’elles demeurent au plus près des usagers et de ceux qui les coproduisent avec eux, comme le prônent les principes du féminisme de donnéeset que défendent nombre de collectifs politisés (à l’image d’InterHop), s’opposant à une fluidification des données sans limites où l’ouverture sert bien trop ceux qui ont les moyens d’en tirer parti, et plus encore, profite à ceux qui veulent les exploiter pour y puiser de nouveaux gains d’efficacité dans des systèmes produits pour aller à l’encontre des gens. Pour démocratiser la conception et le développement des technologies, il faut créer des processus participatifs puissants, embarqués et embarquants. « Rien pour nous sans nous », disent les associations de handicapés, reprises par le mouvement du Design Justice.

« Écrire un nouveau logiciel est relativement simple. Créer des alternatives soutenables et capables de passer à l’échelle est bien plus difficile », conclut Tarnoff. L’histoire nous apprend que les Télécoms ont mené d’intenses campagnes pour limiter le pouvoir des réseaux communautaires, comme le pointait à son tour Cory Doctorow, en soulignant que, du recul de la neutralité du net à l’interdiction des réseaux haut débit municipaux aux US (oui, tous les Etats ne les autorisent pas, du fait de l’intense lobbying des fournisseurs d’accès privés !), les oppositions comme les régulateurs trop faibles se font dévorer par les marchés ! Et il y a fort à parier que les grands acteurs de l’internet mènent le même type de campagne à l’encontre de tout ce qui pourra les déstabiliser demain. Mais ne nous y trompons pas, souligne Tarnoff, l’offensive à venir n’est pas technique, elle est politique !

« Pour reconstruire l’internet, nous allons devoir reconstruire tout le reste ». Et de rappeler que les Ludditesn’ont pas tant chercher à mener un combat d’arrière garde que d’utiliser leurs valeurs pour construire une modernité différente. Le fait qu’ils n’y soient pas parvenus doit nous inquiéter. La déprivatisation à venir doit être tout aussi inventive que l’a été la privatisation à laquelle nous avons assisté. Nous avons besoin d’un monde où les marchés comptent moins, sont moins présents qu’ils ne sont… Et ils sont certainement encore plus pesants et plus puissants avec le net que sans !

***

Tarnoff nous invite à nous défaire de la privatisation comme d’une solution alors qu’elle tient du principal problème auquel nous sommes confrontés. Derrière toute privatisation, il y a bien une priva(tisa)tion, quelque chose qui nous est enlevé, dont l’accès et l’enjeu nous est soufflé, retranché, dénié. Derrière l’industrialisation numérique, il y a une privatisation massive rappelions-nous il y a peu. Dans le numérique public même, aux mains des cabinets de conseils, l’État est plus minimal que jamais ! Même aux États-Unis, où l’État est encore plus croupion, les grandes agences vendent l’internet public à des services privés qui renforcentl’automatisation des inégalités.

Malgré la qualité de la synthèse que livre Ben Tarnoff dans son essai, nous semblons au final tourner en rond. Sans investissements massifs et orientés vers le bien public plutôt que le profit, sans projets radicaux et leurs constellations d’alternatives, nous ne construirons ni l’internet de demain, ni un monde, et encore moins un monde capable d’affronter les ravages climatiques et les dissolutions sociales à venir. L’enjeu désormais semble bien plus de parvenir à récupérer les milliards accaparés par quelques-uns qu’autre chose ! Si nous avons certes besoin de constellations d’alternatives, il nous faut aussi saisir que ces constellations d’alternatives en sont rarement, en tout cas, que beaucoup ne sont que des projets politiques libéraux et qu’elles obscurcissent la nécessité d’alternatives qui le soient. Le secteur marchand produit nombre d’alternatives mais qui demeurent pour l’essentiel des formes de marchandisation, sans s’en extraire, à l’image de son instrumentation de la tech for good, qui conduit finalement à paupériser et vider de son sens la solidarité elle-même. Comme il le dit dans une interview pour The Verge, nous avons besoin de politiques et de mobilisations sur les enjeux numériques, pas seulement d’alternatives, au risque qu’elles n’en soient pas vraiment ! La constellation d’alternatives peut vite tourner au techwashing.

Il manque à l’essai de Ben Tarnoff quelques lignes sur comment réaliser une nécessaire désindustrialisation du numérique (est-elle possible et comment ?), sur la nécessité d’une définanciarisation, d’une démarchandisation, d’une déséconomisation, voire d’un définancement de la tech, et donc pointer la nécessité d’autres modèles, comme l’investissement démocratique qu’explorait récemment Michael McCarthy dans Noema Mag. Et même ce changement d’orientation de nos investissements risque d’être difficile, les moyens d’influence et de lobbying des uns n’étant pas au niveau de ceux des autres, comme s’en désolent les associations de défense des droits américaines. C’est-à-dire, comme nous y invitait dans la conclusion de son dernier livre le sociologue Denis Colombi, Pourquoi sommes-nous capitalistes (malgré nous) ?, à comment rebrancher nos choix d’investissements non pas sur la base des profits financiers qu’ils génèrent, mais sur ce qu’ils produisent pour la collectivité. C’est un sujet que les spécialistes de la tech ne maîtrisent pas, certes. Mais tant qu’on demandera à la tech de produire les meilleurs rendements du marché pour les actionnaires (15% à minima !), elle restera le bras armé du capital. Pour reconstruire l’internet, il faut commencer par reconstruire tout le reste !

Hubert Guillaud

A propos du livre de Ben Tarnoff, Internet for the people, the fight for our digital future, Verso, 2022.

Journaliste, blogueur, Hubert Guillaud, longtemps rédacteur en chef d’InternetActu.net, décrypte comme nul autre nos vies dans les outils du numérique. @hubertguillaud