Alors que s’est ouverte une concertation autour de l’instauration d’une consigne sur les bouteilles afin d’augmenter leur taux de collecte, les débats font de nouveau rage sur la pertinence de cet outil. En effet, la consigne pour recyclage promue par le gouvernement depuis près de quatre ans ne parvient à convaincre ni les collectivités locales, ni les associations environnementales. Ces dernières prônent une consigne pour réemploi, à laquelle les industriels sont réticents. Derrière un débat en apparence technique, différents intérêts et différentes visions de la politique écologique s’y expriment. Le sociologue Vincent Jourdain, auteur d’une thèse sur le sujet, revient sur cet affrontement entre industriels, Etat, collectivités et associations.

Le 30 janvier dernier, la Secrétaire d’Etat auprès du ministre de la Transition écologique et de la Cohésion des territoires chargée de l’Ecologie, Bérangère Couillard, annonçait la mise en place d’une concertation autour de la consigne, rassemblant producteurs, distributeurs, collectivités locales et associations environnementales. L’objectif de cette concertation ? Obtenir l’adhésion des parties prenantes au projet gouvernemental de rendre obligatoire la consigne pour les emballages de boisson, ouvert en 2019 mais qui n’a guère avancé depuis. Mais le 23 février dernier, des associations d’élus ont annoncé la constitution d’un groupe de travail parallèle, portant un coup à la légitimité de la concertation. Le 18 avril dernier, elles ont insisté sur leur opposition, en dévoilant 14 propositions alternatives à la consigne lors d’une conférence de presse. En parallèle, la commission du développement durable du Sénat s’est exprimée contre la concertation et le projet de consigne.

La consigne est réputée populaire : en 2019, une enquête de l’IFOP rapportait que 88% des français seraient favorables à la mise en œuvre d’une consigne obligatoire pour le réemploi des emballages de boisson. Pourtant, selon les collectivités locales et associations environnementales, le projet du gouvernement porterait un intérêt environnemental limité, puisqu’il est en réalité un projet de consigne pour le recyclage des bouteilles en plastique, et non pour leur réutilisation. Le recyclage consistant à broyer la matière pour en recréer une nouvelle, cette technique est en effet moins vertueuse pour l’environnement que la réutilisation, qui consiste à réutiliser les produits en fin de vie.

Selon les collectivités locales et associations environnementales, le projet du gouvernement porterait un intérêt environnemental limité, puisqu’il est en réalité un projet de consigne pour le recyclage des bouteilles en plastique, et non pour leur réutilisation.

De plus, les collectivités luttent contre une mesure qui réduirait leurs financements pour la collecte des déchets d’emballage et mettraient en péril leurs investissements passés dans des capacités de collecte et de tri des déchets. En outre, le plébiscite populaire concernant une consigne pour recyclage des bouteilles plastique n’a, lui, pas été démontré par sondage. Aussi, le droit européen indique depuis 2008 explicitement une préférence pour la réutilisation ou le réemploi devant le recyclage [1].

Dans le même temps, le gouvernement argue que la hausse des objectifs de collecte des déchets de bouteilles plastiques rend nécessaire l’adoption de nouveaux modes de collecte. La loi relative à la lutte contre le gaspillage et à l’économie circulaire (AGEC), promulguée le 10 février 2020, fixe en effet un objectif de taux de collecte des bouteilles plastiques de boissons de 77 % en 2025 et de 90 % en 2029, s’alignant ainsi sur la directive européenne « plastique à usage unique » (SUP) publiée en 2019. Or, ce taux n’atteignait que 61% en 2021, selon l’ADEME.

En 2019, un premier échec

Pour parvenir à augmenter ce taux de collecte, Brune Poirson, alors secrétaire d’Etat à l’économie circulaire, défend dès 2019 l’idée de l’instauration obligatoire d’une consigne pour les emballages de boissons en plastique. Initialement, cette mesure devait être introduite dans la loi AGEC pour une entrée en vigueur dès l’année suivante. Mais ce projet suscite nombre de mécontentements.

Les premiers acteurs à réagir officiellement au projet de loi, qui avait alors fuité dans la presse, sont les recycleurs qui, à travers un communiqué de presse publié le 24 juin 2019, proposent un « plan Marshall » d’investissement dans les capacités de collecte et de tri des plastiques plutôt qu’une consigne pour venir à bout des objectifs posés par la directive SUP. Dans les semaines qui suivent, les collectivités locales, à travers le réseau AMORCE et l’association des maires de France (AMF), publient elles aussi des communiqués à charge contre ce projet.

Lorsque le projet de loi arrive en première lecture devant le Sénat à l’été 2019, la consigne est bien présente. Toutefois, elle est présentée comme un outil indifférencié, pouvant aussi bien contribuer au recyclage qu’au réemploi des bouteilles plastiques. Une forte mobilisation des élus locaux auprès des sénateurs conduit toutefois au resserrement de la mesure : le texte transmis à l’Assemblée nationale, mentionne que la consigne ne peut être mise en œuvre que pour le réemploi ou la réutilisation, et non pour le recyclage.

Face à cette levée de boucliers, Emmanuel Macron tente alors de corriger le tir. Lors du congrès annuel de l’AMF en novembre 2019, il affirme que « rien ne sera fait sans l’accord des maires ». Son Premier ministre Edouard Philippe enfonce le clou deux jours plus tard, pour assurer aux maires qu’ils étaient, sur ce sujet, un contre-pouvoir réel. En fin de compte, le statu quo est privilégié : le gouvernement dépose et fait adopter à l’Assemblée nationale un amendement au projet de loi AGEC repoussant à 2023 la prise de décision concernant la consigne. Le lendemain, un communiqué de presse des représentants des collectivités s’aligne sur cette proposition.

« Rien ne sera fait sans l’accord des maires. »

Emmanuel Macron, congrès de l’AMF, 2019

Ce « moratoire » sur la consigne s’accompagne d’une demande d’expertise à l’ADEME (Agence de l’environnement et de la maîtrise de l’énergie), pour évaluer les avantages relatifs de la consigne sur les autres solutions de collecte. Cette expertise prend deux formes : un suivi régulier des performances du système actuel, paru annuellement, et la production d’une étude de comparaison avec un système de consigne, parue en février 2021. Mais comme bien souvent lorsque le pouvoir demande un rapport aux institutions spécialisées, une question en apparence technique masque de vrais enjeux politiques.

La consigne, menace du modèle existant

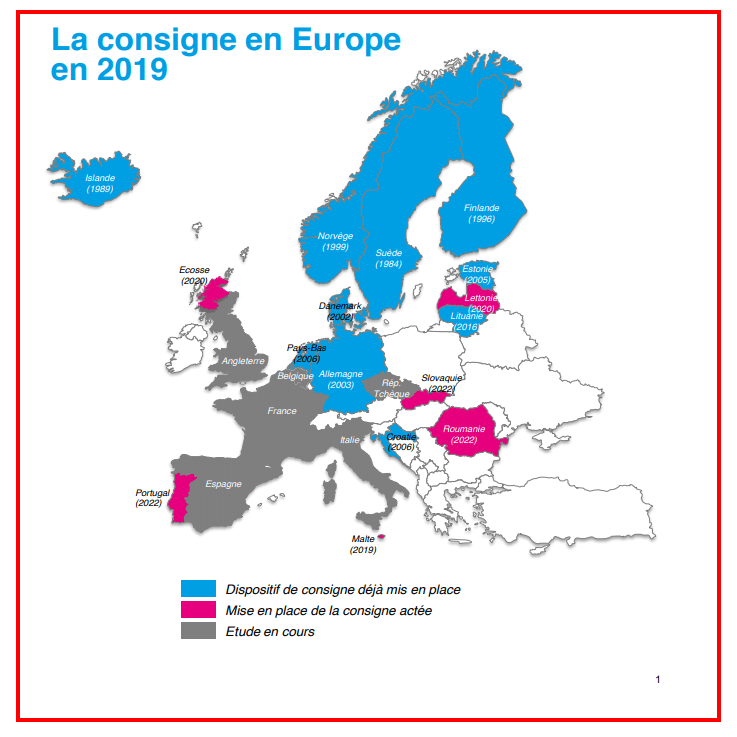

Si la consigne suscite tant d’opposition auprès des collectivités locales, c’est qu’elle remet en question un système de financement et de gestion des déchets d’emballages déjà trentenaire. Il s’agit du principe de la « responsabilité élargie des producteurs » (REP), qui demande aux metteurs sur le marché d’emballages de contribuer à la gestion des déchets issus de leurs produits. Ce système a d’abord été mis en œuvre dans les années 1990 par l’Allemagne, dans un contexte de menace de retour de la consigne obligatoire, instaurée au Danemark voisin dans les années 1980.

Si la consigne suscite tant d’opposition auprès des collectivités locales, c’est qu’elle remet en question un système de financement et de gestion des déchets d’emballages déjà trentenaire.

En 1992, la France, emboîte le pas à l’Allemagne, sous l’impulsion de Brice Lalonde, qui construit avec les industriels (Jean Louis Beffa, de Saint-Gobain et Antoine Riboud, de Danone) et les collectivités (représentées par Jacques Pélissard, de l’AMF) un système autour d’Eco-emballages. Cette entité privée, appelée « éco-organisme », est chargée de collecter auprès des industriels une somme pour chaque emballage mis sur le marché, et de reverser le produit de ces sommes aux collectivités locales, afin de financer leur valorisation [2]. Le pouvoir de collecter cette somme, appelée « éco-contribution » est accordé à l’éco-organisme par un agrément des pouvoirs publics.

Si la France a construit ce modèle, coincé entre interventionnisme et laissez-faire [3], c’est qu’elle cherchait avant tout à éviter de reproduire le modèle allemand qui donnait plus de libertés aux industriels, mais aussi des objectifs de collecte et de valorisation plus élevés [4]. En somme, la REP s’est donc constituée indirectement contre la consigne. Elle est présentée comme une alternative crédible et efficace, qui favorise la valorisation des déchets d’emballages (notamment de boisson) et légitime ainsi leur consommation.

Dans les faits, la REP française a effectivement permis d’accroître la collecte, la valorisation et même l’importance du recyclage dans le « mix » de la gestion des déchets. Elle n’a en revanche jamais atteint les objectifs qui lui étaient fixés dès 2002 par l’Etat français, à savoir de recycler 75% des emballages ménagers, soit 14 points de plus que le taux effectivement observé sur les bouteilles plastiques en 2021. L’imposition de nouveaux objectifs de collecte au niveau européen en 2019 oblige donc le gouvernement à imaginer un nouveau système. La remise en cause de la REP n’est d’ailleurs pas spécifique à la France : l’Espagne, la Belgique, qui ont des systèmes similaires, connaissent les mêmes critiques.

Pour le gouvernement et sa majorité, seule la consigne permettait d’atteindre ces nouveaux objectifs. Ainsi, Stéphanie Kerbarh, rapporteure du texte, affirme le 25 novembre 2019 que : « la consigne est actuellement la seule méthode permettant d’atteindre des taux de collecte supérieurs à 90 % pour les emballages, qu’ils soient en verre, en plastique ou en aluminium. Dix et bientôt quinze pays européens ont adopté des mécanismes de consigne et cinq ont déjà dépassé les 90 % de bouteilles en plastique collectées et recyclées. Aucun système sans consigne ne fait aussi bien. »

En réaction, les collectivités locales et les opposants à la consigne, ont insisté sur l’existence de « trajectoires » d’augmentation de la collecte des emballages de boisson, via l’activation de « leviers d’amélioration » en lien avec la REP [5]. Qu’en est-il vraiment ?

La bataille des chiffres

Dans les deux cas – la mise en œuvre d’une consigne ou l’intensification de la REP – les discussions techniques portent sur des projets de collecte pour recyclage des emballages de boisson. Il s’agit d’évaluer le rapport coûts-bénéfices de chaque solution, tant d’un point de vue économique qu’environnemental.

L’aspect économique est le premier abordé, à travers un rapport confidentiel remis par les industriels de la boisson au gouvernement dès 2019. Il chiffre à 182 millions d’euros les pertes de revenus pour les collectivités du fait de la « sortie » des bouteilles plastiques du système de collecte des déchets d’emballages. Ces pertes sont des éco-contributions qui ne seraient plus versées par l’éco-organisme. Les collectivités, elles, évaluent ce coût à 250 millions d’euros, puisque les gains mis en avant par les industriels (moins de collecte) seraient en fait quasiment nuls, du fait de la forte proportion de coûts fixes dans la collecte des déchets d’emballages. Depuis, les études de l’ADEME concluent toutes à l’existence d’un coût élevé.

Sur les aspects environnementaux, il faut relever que la REP comme la consigne pour recyclage sont construits comme des outils d’« internalisation des externalités environnementales ». Autrement dit, ils sont agnostiques en ce qui concerne l’extraction de ressources, ou la consommation d’énergie nécessaire à leur production [6]. Dans les deux cas, les emballages récupérés ne sont en effet pas réutilisés mais détruits par recyclage ou par incinération. Faire du réemploi, à travers la REP ou la consigne, permettrait de dépasser ces insuffisances. Ainsi, la critique environnementale de la consigne vise non pas le procédé de collecte en lui-même, mais l’usage des emballages récupérés.

Pour les associations environnementales, il a été délicat de se positionner contre la consigne pour recyclage tout en maintenant un plaidoyer pour la consigne pour réemploi, les deux options étant aisément confondues dans le débat.

Si les associations environnementales se sont opposées en 2019 à l’introduction de la consigne pour recyclage dans la loi AGEC, leur positionnement était malaisé. De leurs propres dires, il a été délicat de se positionner contre la consigne pour recyclage tout en maintenant un plaidoyer pour la consigne pour réemploi, les deux options étant aisément confondues dans le débat. Au niveau européen, le réseau Zero Waste Europe a opté pour une autre stratégie et a au contraire soutenu la consigne indistinctement, en faisant paraître un communiqué commun avec des industriels de la boisson appelant à la mise en place d’une cadre européen pour la consigne des emballages de boisson.

Dans le même temps, les industriels de la boisson s’opposent fermement à l’hypothèse de la généralisation d’une consigne pour réemploi sur les emballages en verre. Ils disent douter de son intérêt environnemental et de sa faisabilité. En particulier, ils rejettent en bloc l’idée d’une standardisation des contenants, nécessaire pour mettre en œuvre une consigne pour réemploi à grande échelle. Cette standardisation des bouteilles nuirait en effet à la possibilité de distinguer leurs produits de ceux de leurs concurrents à travers le design des bouteilles.

L’analyse coûts-bénéfices, tant sur le plan économique qu’environnemental, reste donc incertaine. Elle repose à la fois sur les connaissances existantes et sur leur mobilisation par les acteurs. Or, l’analyse dépend des effets de « cadrage » de la question de la consigne, c’est-à-dire de « comment pose-t-on la question ? ». Ces effets de cadrage sont par exemple l’idée qu’il faut atteindre les objectifs européens dans les délais impartis ou que la standardisation des contenants est difficilement envisageable dans une économie libérale.

Les écueils de la rationalité instrumentale

La consigne ne serait qu’un « mode de collecte » ? C’est en tous cas la façon dont elle est appréhendée dans le débat technique. Le « deposit-refund system » (ou DRS) et ainsi pensé comme un simple outil, neutre, que les dirigeants politiques auraient à choisir et à paramétrer en fonction des objectifs poursuivis [7]. Selon ce mode de pensée technique, emprunté à la discipline économique, les « outils économiques », à l’instar de la taxe carbone, auraient l’avantage d’être plus efficaces que d’autres modes d’intervention de l’Etat [8].

C’est dans ce cadre intellectuel qu’une grande partie de la controverse s’est déroulée. Qu’ils s’agissent des rapports qui précèdent la loi, comme celui du collectif boisson ou de Jacques Vernier, ancien président de l’ADEME et expert reconnu sur ces questions, ou ceux de l’ADEME qui lui succèdent, les auteurs s’efforcent de rationaliser la décision politique. Il s’agit alors de mettre en équation les différentes projections et les différents moyens mobilisés, afin d’évaluer leur capacité à atteindre les objectifs fixés.

Pourtant, derrière les débats économiques, certaines formes de moralisation de l’économie reviennent fréquemment dans la controverse. Il faut d’abord noter les appels à la prise en compte des effets sociaux de la consigne : elle serait susceptible de générer des comportements « déviants », comme le fait de favoriser les dépôts sauvages déculpabilisés. Concrètement, les consommateurs ne se souciant pas de récupérer la consigne sur leurs bouteilles les abandonneraient ainsi en pleine rue, afin que des personnes à faible revenu les récupèrent pour arrondir leurs fins de mois. Certains parlementaires disent craindre l’émergence de ces « marchés parallèles » de récupération d’emballages consignés [9]. Les collectivités locales dénoncent elles la « monétisation » d’un geste citoyen, le tri étant jusqu’à présent effectué gratuitement [10].

Aussi, et surtout, les débats autour de la consigne débordent les cadrages techniques comme « mode de collecte ». Pour un certain nombre de commentateurs, une consigne pour recyclage ne serait pas une « vraie » consigne. Ainsi, Loïc Prud’Homme, député La France Insoumise, affirme que :

« Le mot « consigne » a un sens qu’il s’agirait de ne pas détourner : cela consiste à rapporter des objets, notamment des bouteilles en verre, non pour les refondre et dépenser de l’énergie pour en fabriquer de nouvelles, mais pour les renvoyer à leurs producteurs, les laver et les réutiliser. La « consigne », comme vous en faites la publicité, n’est que du recyclage déguisé. »

Loic Prud’Homme, lors des discussions sur le projet de loi AGEC à l’Assemblée Nationale.

A l’inverse de la disjonction opérée par les experts, cette définition de la consigne lie l’outil à son objectif. Cette interprétation « liée » d’un instrument (penser en même temps ses moyens et ses fins) constitue la règle plutôt que l’exception. Une comparaison avec le cas du consentement à l’impôt [11] peut ici s’avérer pertinente. En effet, un impôt répond bien souvent autant à des exigences morales et politiques qu’à des critères d’efficacité [12].

Bien que la consigne ne soit pas, juridiquement, un impôt, elle consiste en réalité en un prélèvement de ressources auprès des individus – bien que ceux-ci soient des consommateurs – créé pour poursuivre des objectifs politiques, en l’occurrence environnementaux. Il faut également noter que la consigne n’est pas tout à fait conçue comme un outil neutre : dans l’ensemble des discussions qui entourent sa mise en œuvre, il est estimé que les consignes non récupérées par les usagers (en cas de mauvais « tri ») seront affectées au financement de la logistique du système. Autrement dit, une part résiduelle de l’outil est un instrument budgétaire : on prélève des ressources auprès des consommateurs pour financer la collecte et la gestion des déchets.

Enfin, la réflexion sur la consigne est constamment prise dans un débat portant sur d’autres outils fiscaux alloués à la collecte et à la gestion des déchets. Parmi les « leviers » considérés pour accélérer la collecte des emballages de boisson, on trouve l’accélération du déploiement de la « tarification incitative », soit le fait de payer la taxe d’enlèvement des ordures ménagères en fonction du poids des ordures ménagères jetées dans la poubelle grise, tout en laissant la collecte sélective « gratuite » pour en augmenter l’intérêt. Cette mesure, plébiscitée par les experts [13], est toutefois sujette à une forte politisation chez les élus locaux [14].

Les conséquences des choix hérités du passé, notamment en termes de pertes financières pour les collectivités en cas de mise en place d’une consigne, et l’opposition des industriels à l’instauration d’une consigne pour réemploi sur le verre (ou le plastique), risquent de peser lourd face à la proposition d’instauration d’une « vraie » consigne pour réemploi, comme le réclament notamment les associations environnementales.

Parler de la consigne, c’est donc directement et indirectement parler d’imposition, ou en tous cas d’allocation collective des ressources économiques. Ainsi, derrière l’apparence d’un débat technique et neutre reposant uniquement sur des expertises, l’opposition entre REP et consigne renvoie à des antagonismes entre les intérêts de différents acteurs, mais aussi à des visions « morales » de la politique environnementale, relatives au choix des modes de traitement. Les conséquences des choix hérités du passé, notamment en termes de pertes financières pour les collectivités en cas de mise en place d’une consigne, et l’opposition des industriels à l’instauration d’une consigne pour réemploi sur le verre (ou le plastique), risquent de peser lourd face à la proposition d’instauration d’une « vraie » consigne pour réemploi, comme le réclament notamment les associations environnementales.

Si ces dernières ont déjà gagné la bataille de l’opinion sur ce sujet, l’enjeu pour elles est de parvenir à rendre leur message compréhensible et de différencier le mode de collecte et le devenir des emballages collectés. A rebours de l’image consensuelle du processus de concertation lancé par le gouvernement, ces différents intérêts et visions de l’écologie vont donc de nouveau s’affronter.

Notes :

[1] Aussi appelé « hiérarchie des modes de traitement », ce principe est présent dans la directive 2008/98/CE du Parlement européen et du Conseil du 19 novembre 2008 relative aux déchets.

[2] La valorisation a été plébiscitée lors de la création du dispositif, pour intégrer à la fois le recyclage et l’incinération, qui sont ainsi mis sur un pied d’égalité.

[3] En réalité, la REP française correspond à un accord privé-public de type nouveau, que les économistes ont pu appeler « engagements volontaires » et les gestionnaires désigner comme une « régulation hybride ». Voir à ce titre : BORKEY, P., GLACHANT, M., « Les engagements volontaires de l’industrie : un mode original de réglementation environnementale ». Revue d’économie industrielle 83, 1998, ou encore MICHEAUX, H., AGGERI, F., « The emergence of hybrid co-regulation: empirical evidence and rationale in the field of e-waste management », Présenté au colloque EGOS en 2016.

[4] En effet, si le taux de « réutilisation » (c’est-à-dire de recyclage ou de réemploi) des emballages tombait en-dessous de 72%, il était ainsi prévu que l’Etat fédéral Allemand oblige tous les producteurs à mettre en place une consigne

[5] Ces leviers sont multiples (collecte des déchets consommés hors-foyer, augmentation des points d’apport volontaires, amélioration de la communication) et impliquent généralement une hausse des moyens alloués par Citeo. Voir VERNIER, J., Rapport sur la consigne des emballages de boissons, 2019.

[6] S’il est anticipé que le recyclage des déchets peut, indirectement, contribuer à diminuer le taux d’extraction des ressources vierges, cette relation causale n’a jamais été observée empiriquement. Surtout, elle prend mal en compte le fait que le recyclage comporte nécessairement des pertes énergétiques ou matérielles, qui l’empêchent ainsi d’être tout à fait neutre d’un point de vue environnemental.

[7] WALLS, M, « Deposit-refund systems in practice and theory ». Resources for the future discussion paper n°11-47, 2011.

[8] « Les incitations économiques ou autres visant à favoriser les choix durables du consommateur et à promouvoir des habitudes de consommation responsables peuvent être un outil efficace pour atteindre les objectifs de la présente directive » (considérant n°22 de la directive SUP).

[9] Voir l’intervention de Valérie Beauvais dans le rapport des sénatrices : RIOTTON, V., KERBARH, S., Rapport fait au nom de la commission du développement durable et de l’aménagement du territoire sur le projet de loi, adopté par le Sénat après engagement de la procédure accélérée, relatif à la lutte contre le gaspillage et à l’économie circulaire (n° 2274), Tome II, Assemblée nationale, 2019.

[10] Qui repose d’ailleurs sur une « mise au travail » des usagers. Voir à ce titre : BARBIER, R., « La fabrique de l’usager. Le cas de la collecte sélective des déchets », Flux 48/49, 2002. CAILLAUD, K., « Les conditions de mise au travail des usagers. Le cas de la gestion des déchets » Gouvernement et action publique 7, 2018.

[11] DELALANDE, N., SPIRE, Alexis., Histoire sociale de l’impôt. La Découverte, 2010, ainsi que BLAVIER, P., « Que nous apprennent les sciences sociales sur les Gilets jaunes, et ceux-ci sur la société française ? Une entrée par les enjeux socio-économiques », Revue Française de Socio-Économie 24, 2020.

[12] Si l’on peut rétorquer que les critères d’efficacité qu’on y intègre peuvent être suffisamment bien choisis et paramétrés pour parfaitement prendre en compte les exigences morales, cette optimisation semble encore difficile à atteindre et surtout requiert l’acquisition, par toutes les parties concernées par l’impôt en question, d’une connaissance suffisante de ses mécanismes.

[13] Voir la thèse de Renaud Nougarol, sur la mise à l’agenda et la traduction politique de la tarification incitative comme outil économique : NOUGAROL, R., La tarification incitative des déchets ménagers comme processus d’économisation ? : sociologie des cadrages et des débordements d’une politique publique, Université Toulouse le Mirail, 2017.

[14] CAILLAUD, K., NOUGAROL, R., « La triple politisation de la tarification incitative. Rapports de force, réagencements et effets d’un instrument politique », Géocarrefour 95, 2021.