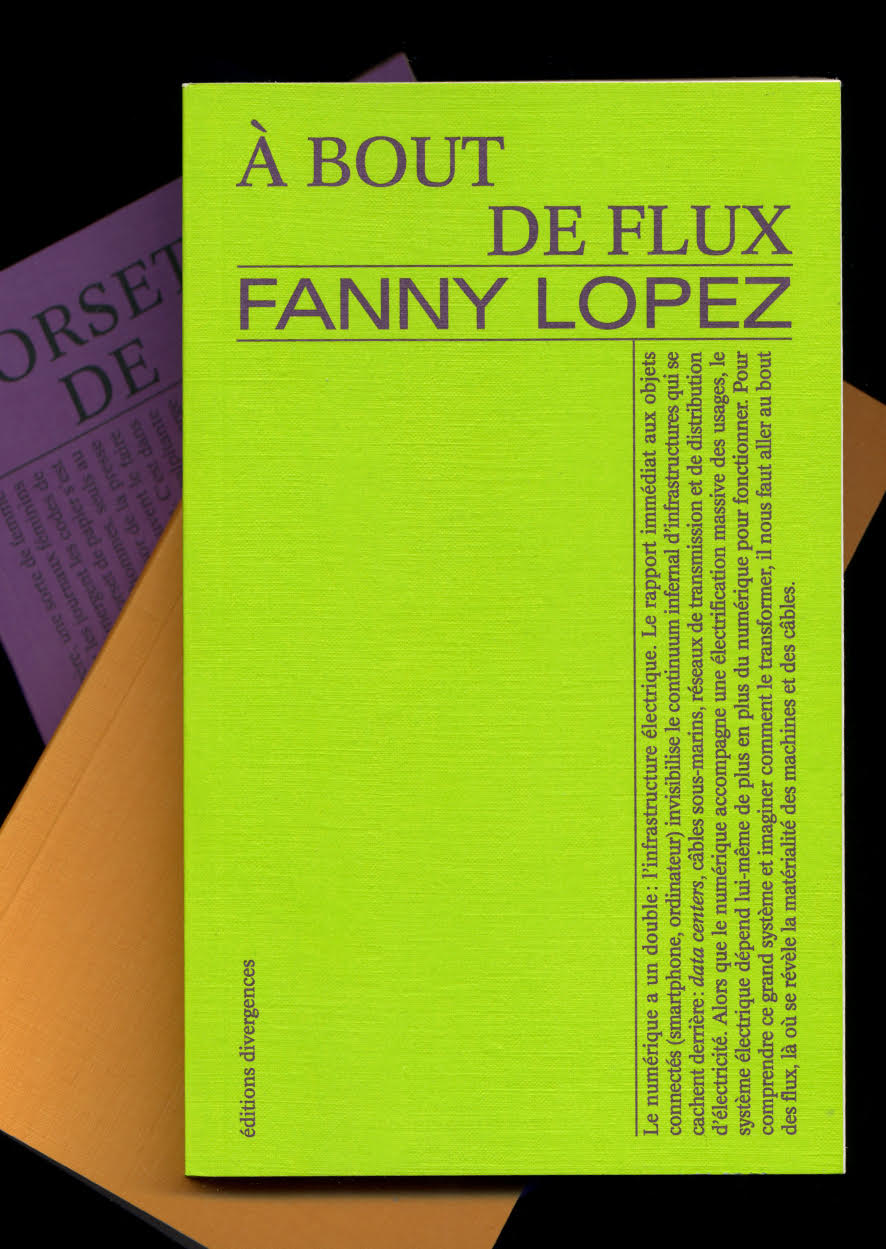

D’abord cantonnée à la sphère professionnelle, la numérisation a fini par s’étendre à toutes les facettes de l’existence humaine, y compris les plus intimes. Un processus qui ouvre sans cesse de nouveaux marchés pour une poignée d’entreprises, tend à uniformiser nos comportements et à transformer l’être humain en support publicitaire, à l’image des influenceurs. Derrière l’illusion de gratuité et de liberté, le numérique exploite notre attention et nous transforme en simples produits sur un marché global, niant notre intériorité. C’est du moins ce que défend Baptiste Detombe, dans sa critique anticapitaliste du numérique L’homme démantelé. Comment le numérique consume nos existences. Extraits.

La marchandisation du monde tendait à arriver à bout de souffle. Les animaux étaient réduits au rang d’objets dans des élevages industrialisés, les poissons élevés en barrique avec le développement de la pisciculture, les journaux, eux, s’occupaient de faire de l’information une marchandise. L’économie mondiale, en cette fin de XXe siècle, nécessitait de nouvelles sources de profits et de rentabilité, et pour ce faire une seule solution : ouvrir de nouveaux marchés et générer des débouchés. Le numérique s’est fait poule aux œufs d’or et a ainsi délivré la croissance capitaliste d’une agonie certaine. Le désir a pu être sur-stimulé par le développement des réseaux sociaux puis de la publicité ciblée, le non-quantifiable a pu être mesuré (l’attractivité sociale, la beauté physique, le temps d’attention) afin d’être mieux commercialisé, l’homme ordinaire a pu se transformer en marchandise ambulante et devenir influenceur de son prochain. Le fétichisme de l’écran n’a plus qu’une seule finalité : transformer l’homme en produit standardisé et lui faire oublier sa propre aliénation.

La vérité sur notre génération, c’est que nous avons été les victimes d’une OPA. Autrement dit, le marché a vu dans nos cerveaux plastiques la possibilité d’engranger des profits encore jamais atteints. Une nouvelle ressource avait été découverte à l’insu du monde. Le problème, c’est qu’il n’est pas question d’exploiter un filon, un champ ou des bras, mais bien notre attention. Notre mémoire, notre imaginaire, notre temps, tout cela devenait la cible d’une nouvelle industrie : l’industrie numérique. Les entreprises étaient prêtes à payer cher pour accéder à ces cervelles prépubères. Elles savaient que le désir est infini à l’enfant qui n’a pas conscience des limites, et que les parents sont sensibles aux appels de leur progéniture. Et il faut bien le comprendre, nous, jeunes, sommes ou étions un « super marché », un super marché car nous disposions d’un temps incalculable. Nous n’étions pas astreints à la monotonie du métro-boulot-dodo et exemptés de la plupart des tâches ménagères. C’est alors pleinement disposés que nous pouvions utiliser notre attention à engraisser les GAFAM. Et notre ressource attentionnelle était d’autant plus précieuse que nos désirs et habitudes n’étaient pas encore ancrés. Les suggestions des pubs, des proto-influenceurs pouvaient alors encore changer nos modes de vie et de consommation. Il faut le comprendre, pour tout capitaliste, nous étions des poules aux œufs d’or. Mais le poulailler en a pris un coup.

La jeunesse ne le sait pas, mais elle est la principale victime du numérique. Si les géants d’internet se jettent sur elle, c’est parce qu’elle dispose de ce temps en abondance. N’étant pas enserrée dans les griffes du salariat, elle peut allègrement participer à la société de consommation en donnant son attention et ses données. Notre temps est ainsi l’une des premières (mais aussi des dernières dans cette proportion) ressources du capitalisme. L’attention correspond à ce que l’économie de marché n’arrivait pas encore à quantifier et à marchander, la révolution numérique aura eu le mérite de nous transformer intégralement en objet de consommation. Pourtant, c’est bien l’esprit qui est ici victime de la capture : « attention » vient du latin « ad tensio » qui signifie « tension de l’esprit vers quelque chose ». Aujourd’hui, l’esprit est encore en nous, mais il s’abstient de faire l’effort de tendre vers quoi que ce soit. Il butte sur la surface lisse de l’écran et n’a plus aucune rugosité sur laquelle s’accrocher et croître. L’attention ainsi ne nous appartient plus. Elle est vampirisée par l’industrie numérique. Nous la déléguons contre des sommes onéreuses, qui nous servent en réalité à financer notre consommation de contenu virtuel.

Jusqu’à présent, l’homme avait résisté à ce devenir de marchandise : il était difficile de quantifier son aura sociale, ses opinions politiques, sa capacité à générer de la sympathie et à influencer ses pairs. Il semble que cela appartienne désormais au passé.

Jusqu’à présent, l’homme avait résisté, malgré lui, à ce devenir de marchandise : il était difficile de quantifier son aura sociale, ses opinions politiques, sa capacité à générer de la sympathie et à influencer ses pairs. Il semble que désormais l’affaire appartienne au passé. La quantification de l’existence permise par le numérique est totale. Du nombre de pas effectué en une journée en passant par sa popularité, sans oublier sa beauté physique, aucun aspect de la vie humaine n’échappe au merveilleux devenir de marchandise objectivable ! Plus rien désormais ne peut arrêter le développement du marché, l’extension ad nauseam de ce qu’il englobe. Tout doit pouvoir générer du profit, offrir de nouvelles mannes financières. L’homme est alors un nouveau produit de consommation, et une batterie de nouveaux acteurs en témoignent : des coachs en développement personnel que nous avons vus venant faire grimper notre valeur sociale et marchande, en passant par les influenceurs qui orientent nos désirs de consommation. Pour devenir un produit d’appel attractif, pour gagner en cotation sur le marché de la désirabilité sociale, une seule solution : standardiser l’homme. L’homologuer afin de le diffuser sur tous les marchés : l’homme démantelé est aussi un produit de l’uniformisation. Nos relations sociales se trouvent alors aseptisées pour mieux correspondre aux critères d’attractivité de l’époque : le crédit s’achète au prix de la profondeur d’être.

Les réseaux sociaux sont bien de grands marchés. Des immenses marchés de sociabilité et de rayonnement social. Ils sont parfaitement décloisonnés et mettent ainsi fin aux limitations géographiques. Chaque individu est accessible sur l’ensemble des plateformes, ce qui lui confère une visibilité pouvant être exponentielle. Cette absence de limites, c’est la porte ouverte à des individus au « pouvoir de marché » considérable, dont l’influence est peu commensurable. Les valeurs de référence elles aussi sont uniformisées : le nombre d’abonnés ou d’amis sont des indicateurs fiables de notre valorisation sur ce nouveau marché social. Il appartient alors à chacun de savoir se démarquer sans trop dépasser les frontières de l’acceptable. Certains ainsi constatent leur succès, d’autres, face à cette transparence du marché numérique, ont le privilège de constater leur solitude, leur faible valeur aux yeux de leurs pairs.

L’homme est ainsi continuellement quantifié, jugé à l’aune de son attractivité. Il intègre dans sa psyché le marché. De la qualité de « sujet » nous ne devenons que des « objets » dont la valeur n’est que fonction du nombre de regards se posant sur nous. « Je » n’est pas cette expression de la magnifique dignité humaine, mais un bien de consommation à la disposition d’autrui. C’est tout l’idéal des Lumières d’un individu à la dignité inestimable qui s’effondre. Loin de l’idéal kantien de l’homme auquel on ne saurait apposer un prix, nous nous trouvons dans le lieu du quantifiable, de l’estimable. Or, rien n’est plus valeureux que le sans-prix, rien n’est plus estimable que ce qui ne s’estime pas. La quantification monétaire nivelle l’homme, le ramène aux sphères du marché. Nous vivons dans l’ignorance de notre réduction au rang d’objet de consommation et d’outil de production par l’empire industriel du numérique. Constamment anxieux face à l’évolution du chiffrage de notre popularité, nous faisons la difficile expérience de l’homme-marchandise.

Les derniers versants de l’homme encore protégés de la marchandisation du monde tombent. La donnée produite lors de nos déplacements géolocalisés, nos préférences affichés sur les réseaux par un like posé afin d’orienter le ciblage publicitaire, notre temps d’attention monnayé, la sexualité encore plus largement soumise au marché… L’industrie du numérique a eu cette malice que de rendre possible des extensions pharamineuses des profits tout en laissant l’impression au consommateur moyen que ses actions étaient gratuites, sans incidences. Nous vivons dans une naïveté confondante qui nous laisse croire que le virtuel est la liberté et la gratuité, alors qu’il est le temple transformé en marché.

Or, le problème du marché, c’est qu’il institue une éternelle relativité des choses : tout n’a de valeur qu’au regard de la qualité de l’offre et de la quantité de demande générée. Rien n’a donc plus de valeur en soi. Tout est conditionnel. L’homme ne repose plus alors sur aucune valeur intrinsèque. La fragilité de l’individu contemporain repose dans cette instabilité permanente imposée par l’idée marchande. Notre conscience individuelle de nous-mêmes est alors friable. Nous savons que nous existons, mais nous déplorons la relativité de la valeur de nos existences. Nous n’avons, à vrai dire, plus le choix. Toute réalité doit être garantie. Il faut pour cela qu’elle soit adossée à des institutions qui peuvent affirmer que ce que nous vivons est réel et indubitable. Cette institution, aujourd’hui, c’est le marché. Nous sommes suspendus à ses lèvres. Il nous permet d’évaluer la pertinence d’une idée, la qualité d’un livre, l’attractivité d’une personnalité, l’originalité d’une œuvre d’art. Il est notre référentiel, notre focale, ainsi que le marqueur de notre insignifiance.

L’industrie du numérique a eu cette malice que de rendre possible des extensions pharamineuses des profits tout en laissant l’impression au consommateur moyen que ses actions étaient gratuites, sans incidences.

Ainsi, pour plaire à ce marché, une seule solution : la standardisation. Nous devons nous conformer aux critères d’attractivité de l’époque. Si cela a toujours été, notre temps est marqué par l’exacerbation de cette pression. Nous avons désormais besoin de nous rassurer face à la fragilité de notre valeur sociale. Plus encore, il nous faut rendre désirable l’homme public que nous sommes, mais aussi notre intimité, tout doit pouvoir être visible et attractif. Alors, si je veux réussir sur YouTube, il me faudra privilégier les contenus courts, à forte teneur en divertissement afin de maximiser leur accessibilité, avec un montage rapide et un faible contenu réflexif de sorte à ne pas perdre l’attention du consommateur. De même, si je veux que mon profil fonctionne sur Instagram, il importe que je sois prêt à publiciser à un rythme régulier des pans toujours plus importants de mon existence, à surjouer une certaine comédie qui attire les regards et suscite des émotions, à faire preuve d’une grande expressivité pour générer l’empathie, etc.

L’homme a accès à ces standards qui ne l’englobent plus seulement dans une sphère dite professionnelle, mais bien dans l’entièreté de son être, de son existence. C’est son mode d’existence social qui est ici conditionné par le numérique. En bout de course nous assistons à « la standardisation du semblable – un monde où l’opacité de l’autre serait finalement balayée[1]. » En somme, nous nous ennuyons des autres, nous les savons prévisibles, et ils le sont d’autant plus que nous n’attendons d’eux ni plus ni moins que cette prévisibilité. Cette exigence de standardisation amène à la simplification des hommes. Une simplicité confondante qui laisse une certaine amertume à ceux qui cherchent encore une certaine profondeur dans les rapports humains. En bout de course, se trouve la consécration de la « vacuité » humaine, qui est l’aboutissement de toute civilisation technicienne ne cherchant que des hommes malléables.

Les réseaux sociaux en publicisant l’existence ont fait de chacun de nous des publicités ambulantes, soit pour notre propre entreprise individuelle que nous incarnons malgré nous, soit pour les biens de consommation qui nous environnent ou le mode de vie qui est le nôtre. Pour être vendu tout produit doit répondre à une certaine homologation. Cette homologation permet de rassurer le consommateur, il ne dérive pas ainsi en terres inconnues. Plus nous sommes homologués, autrement dit, standardisés, et moins l’incertitude sur le contenu montré est grande. En cela, elle rassure et fait gagner du temps, au détriment de la disparité et de la singularité des diversités humaines inscrites dans les schèmes culturels. Tout marché impose donc une marchandise standardisé. Et l’homme, s’il est considéré comme telle, n’y échappe pas. Cette tendance donne ainsi crédit à Jacques Ellul qui considère que « Le grand mot des techniques de l’homme, c’est : adaptation[2]. » Il nous appartient alors de constamment nous adapter afin de rester désirable sur le grand marché numérique dont l’émergence est encore récente. Cette désirabilité est la condition de notre succès mais aussi la seule voie possible afin d’éviter une frustration génératrice de déprime.

Face à la déliquescence des lieux de convivialité, l’amour a été rapidement pris d’assaut par le marché. Les maisons matrimoniales ont été remplacées par les applications de rencontre, et avec elles les bars, discothèques et bals populaires sont devenus secondaires. Les mécanismes de marché inscrits dans ces applications sont apparus comme des solutions au regard des difficultés croissantes à faire des rencontres, du caractère plus instable des unions et de la recherche d’une plus grande compatibilité[3].

Autre exemple d’affadissement des rapports humains par le marché numérique : le covoiturage. Alors que pendant longtemps cette pratique relevait de l’économie collaborative, du partage, amenant à ne concevoir les frais que pour indemniser les coûts de l’essence et des péages, ceci a été transformé par l’essor des applications numériques. Blablacar est venu monopoliser le marché, augmenter progressivement les frais des commissions. La plus grande publicité faite au covoiturage a amené alors de nouveaux profils, qui y voient plus une manne financière qu’un moment de partage en société. Progressivement, ce qui était spontané, franc et joyeux, est devenu aseptisé, fade et prévisible. Nous n’étions plus là pour nous découvrir, faire connaissance le temps d’un trajet, mais seulement pour soutenir financièrement le conducteur. Les passagers ont alors été libres de rester sur leurs écrans ou de dormir tout le long du voyage. L’interaction s’est mortifiée face au règne du marché. Les avis sur l’application ont ainsi participé à uniformiser les comportements, afin de les normaliser et ainsi de rassurer. Toute la curiosité d’un moment de partage s’est envolée à mesure que la prévisibilité et la standardisation exigées par le marché numérique se sont instaurées.

Désormais il est même possible de rendre profitable le seul fait de se séparer du monde qui nous entoure, de nous éloigner de nos proches. Si le temps d’attention a toujours été monnayé, il peut l’être aujourd’hui explicitement. « TikTok Lite » propose ainsi de rémunérer les individus à regarder des vidéos. Il n’y a pas de vente de soi-même plus explicite, il n’y a pas de plus grands mépris faits à la vie, que de donner son temps pour alimenter une passivité stérile. Notre attention, notre mémoire, notre imaginaire : tout se trouve corrompu, que le numérique agisse explicitement comme ici, ou insidieusement comme à son habitude. Mais pour la première fois des voix s’élèvent, craignant que les enfants ne soient en première ligne face à cette marchandisation assumée. Il semblerait que la superficie compte plus que la profondeur. La marchandisation de notre temps d’attention a toujours été, et il est bien hypocrite de s’en inquiéter le jour où une plateforme ne s’en cache plus. Un peu de courage aurait néanmoins permis de comprendre que le phénomène n’est pas nouveau et qu’il n’est pas plus grave aujourd’hui qu’il est su.

Le rôle du marché numérique est de trouver des solutions aux problèmes que nous rencontrons. Face à la solitude relationnelle existe l’opportunité d’émergence d’une nouvelle application.

Mais le rôle du marché numérique est bien de trouver des solutions aux problèmes que nous rencontrons. Face à la solitude relationnelle, face à un nouveau problème, existe l’opportunité d’émergence d’une nouvelle application. L’application « Timeleft » s’est ainsi donnée pour mission d’organiser des dîners entre inconnus pour les célibataires débarqués à Paris. Face à l’anomie créée par d’immenses métropoles techniciennes la solution toute trouvée a donc été de créer une plateforme de rencontres. La technique crée ainsi les solutions aux problèmes qu’elle engendre. Elle crée de la sorte des marchés infinis sans jamais cesser d’alimenter un capitalisme toujours à bout de souffle. La misère (sociale, humaine, amoureuse…) permet ainsi de faire croître de nouveaux marchés, à condition que les consommateurs aient le pouvoir d’achat suffisant…

Dans ce capitalisme numérique, l’influenceur est une figure centrale. Cette vedette mécanique est censée, par la sympathie qu’elle génère, inciter ses abonnés à l’imitation. Pour imiter une personne qu’on ne connaît point rien de plus simple : il faut singer son apparence, son mode de vie, qu’importe si cela ne nous convient pas. Ils servent alors de diffuseurs de modes, de tendances. Leurs larges communautés, si elles ne se conforment pas à l’instant aux modèles véhiculés, ne tardent pas à observer une modification de leur perception. Certains objets qui ne les intéressaient pas deviennent désirés, d’autres qui suscitaient déjà une certaine attraction se transforment en besoins. Les placements de produits sont à ce titre centraux, ils permettent d’expliciter l’objectif de ces stars de la consommation. Mais ils sont aussi trompeurs : ils laissent suggérer un objectif de vente unique et bien délimité, alors que dans les faits, c’est tout le lifestyle, le mode de vie, de la vedette qui stimule le marché.

L’avènement de ces stars numériques n’est autre qu’une excroissance logique de la modernité qui après avoir fait tomber toutes les sources de vénération (le roi, Dieu…) cherche partout où elle le peut à se raccrocher à la première idole venue. Le vide créé par un environnement relativiste implique, en effet, de sacraliser quelques pans de nos vies, quelques personnes de renom, afin de donner un peu d’aspérité à une existence qui serait, autrement, trop plate pour être vécue. Le philosophe Fabrice Hadjadj avait ainsi anticipé ce biais de notre temps : « l’un des traits propres à la modernité est autant son iconoclasme que sa propension à fabriquer des icônes, sinon des idoles[4]. » Le « sacré » lui-même est ainsi victime d’un processus de consommation, les idoles, influenceurs, sont adorées puis vouées aux gémonies en un temps record, elles sont ainsi éternellement renouvelées, éternellement recyclées. Les esprits sont occupés à adorer des veaux d’or pour mieux pouvoir les faire s’effondrer.

L’enjeu n’est plus tant de tendre vers un absolu, de s’adosser à des croyances structurantes, mais bien plutôt d’occuper un temps morne. Leur influence est d’autant plus forte que tous les référentiels se sont, un à un, effondrés, ne laissant à l’individu contemporain qu’un néant auquel s’accrocher. La perspective de faire partie d’un groupe, d’une communauté, si stérile soit-il est alors une opportunité rêvée. Suivre un influenceur c’est l’assurance de ne plus être seul et de pouvoir interagir avec d’autres fans, de vivre par procuration une aventure, ce sont des ersatz face à une solitude contemporaine chronique. Tout devient monétisable, et chaque influenceur se fait l’égérie de son secteur d’activité : un influenceur se proclame référent de l’industrie du sport, un autre de l’industrie crypto-financière. Un autre préfèrera se spécialiser dans les produits de beauté voire dans le matériel artistique. Toute l’économie, même dans ses niches les plus microscopiques, est ainsi en partie soumise au rôle central d’influenceurs, même l’entomologie (l’étude des insectes !) dispose désormais de ses référents en la matière. Il peut tant s’agir d’une paire de bottines que de lunettes de soleil, ou bien d’une décoration d’intérieure et de jeux de société ou d’alcool à pratiquer en couple. Absolument tous les marchés ont choisi dans le monde numérique leurs égéries pour pénétrer les désirs de chacun.

Il se pourrait pourtant bien que cette même civilisation occidentale ait préparé sa propre perte. Autrement dit, l’Occident a rendu possible le sabotage de son idéal. Nous portions en germe la fin d’un humanisme qui avait pourtant été moteur pendant des siècles. Comment en sommes-nous arrivés là ? D’abord en consacrant la suprématie de l’intérêt particulier et de la propriété privée. Ces institutions libérales, essentielles à toute économie de marché, ont formé un environnement protecteur et souple pour le développement de la technique. Les brevets pour protéger les inventions ont fait florès, l’idée que l’enrichissement était une vertu s’est épanouie. La primeur de la liberté individuelle a inhibé l’intervention de l’État. L’innovation a ainsi pu germer, l’idée d’autonomie humaine a pu s’épanouir. Nous n’avions pas anticipé que de cette technique rendue profitable par le marché ferait flancher les fondements de la civilisation occidentale. Nous n’avions pas vu que le numérique serait instrumentalisé par des multinationales pour leurs profits, contre notre idéal. L’humanisme s’en trouve ébranlé, abîmé. Nous avions alors oublié que l’exigence de l’homme n’était envisageable que dans un contexte favorable, dans lequel l’individu n’était pas aliéné à un smartphone décidant de sa propre vie.

L’exigence humaniste de l’Occident et la valeur donnée à l’individu ont malheureusement lié les mains de sociétés entières face à l’industrie numérique. Le mantra selon lequel la liberté des uns s’arrête là où celle des autres commence devait mettre à arme égale la dignité des citoyens et les intérêts lucratifs des géants du numérique. Le poids donné à la liberté des individus s’appliquant aussi au commerce et aux logiques du marché, aucun État ne pouvait envisager des restrictions, sans sombrer dans de fameux travers totalitaires. Empêcher le règne du marché permis par le virtuel ne pouvait être autre chose qu’un crime contre la liberté humaine. C’est ainsi que l’Occident tout entier s’est livré aux appétits financiers, a délaissé ses ouailles pour servir une liberté qui détruisait toutes les autres. Heureuses ces firmes qui monopolisent les plus grands experts pour détruire la cognition de générations entières ! Pourquoi leur en vouloir ? Elles ne font que se saisir de notre candeur et de notre naïveté. Nous les laissons ainsi ravager notre liberté, notre singularité, notre pensée et notre terreau culturel… afin de rester conforme à ce qui fait le suc de notre culture : la liberté.

Le rapport gouvernemental d’avril 2024 intitulé « Enfants et écrans, à la recherche du temps perdu », incarne ce paradoxe ancré dans notre culture. Il résume en quelques mots l’impasse libérale d’un modèle occidental impotent face à l’industrie numérique. Il associe alors toute contrainte législative à un retour au totalitarisme en assimilant les restrictions collectives à la mise en place de « policiers devant chaque maison ». Manque de courage politique, perte d’ambition de l’action publique, tout cela est certainement vrai. Mais nous avons surtout une foi aveugle dans la liberté laissée à chacun de régir sa vie. Foi qui serait envisageable si tout notre environnement n’était pas fait pour nous faire sombrer dans l’addiction facile et destructrice. Il revient alors aux « parents » de « se saisir de ces recommandations ». La liberté prime, le marché gagne, les générations, elles, y passent. Nous ne pouvons, en effet, nous en remettre exclusivement aux parents. La question ici est systémique et économique, faire reposer cet enjeu de santé publique sur les seules épaules individuelles est une erreur terrible condamnant au sentiment d’impuissance.

Quel terrible paradoxe finalement que celui de ces nations victimes de leurs propres enfants. Nous choyons la liberté et ne voyons pas grandir en son sein une industrie numérique qui nous promet l’asservissement. Nous avions érigé le marché en outil de puissance et d’expansion, mais refusons de le contrôler maintenant qu’il a pris son indépendance, s’est émancipé. Nous nous trouvons alors face à un géant, le numérique allié au marché, qui n’a plus de limites et peut – sans autre aval que sa propre volonté – envahir l’imaginaire et la psyché de populations entières. L’industrie numérique gagne la bataille en se servant des armes de l’Occident. Notre naïveté nous a coûté et continuera d’être l’objet d’une dette dont les générations futures auront à s’acquitter. Peut-être aurions-nous dû, pour protéger l’homme, arrêter le marché. Non pas le supprimer, mais lui imposer un périmètre, des limites. Lui annoncer qu’il peut s’étendre dans la mesure où il ne menace pas des équilibres civilisationnel et anthropologique. Le renoncement aux contraintes collectives semble être aujourd’hui le cheval de Troie par lequel toute une civilisation se trouve prise en otage. Triste tragédie que celle de l’érection de l’homme dans toute sa noblesse dont on refuse le droit d’exister.

L’Occident est ainsi le serpent qui se mord la queue. C’est bien parce qu’il en porte en lui l’idéal de singularisation humaine, qu’il ne se sent pas capable d’interdire, de limiter les forces du marché. La liberté individuelle doit pouvoir tout justifier, et donc ne pas s’arrêter, même quand l’industrie numérique ravage l’idéal d’un humanisme en pleine désertion. Alors, se libérer du poison numérique, dans un Occident acquis à la cause de la liberté individuelle, risque encore d’être long. Pour reprendre Benjamin Constant, ce qui compte pour nous Modernes, c’est la jouissance privée. Tout ce qui pourra être fait pour la limiter est criminel. Même si cette jouissance est utilisée pour nous asservir et empêcher la réalisation de l’homme.

L’urgence n’est autre que de dompter le numérique, de faire de l’État le « maître et possesseur » du monde virtuel. Son expansion ne doit plus revenir aux lois du marché mais bien aux décisions des peuples. L’objectif est simple : repolitiser le numérique. Il faut admettre qu’il n’est pas une donnée technique qui nous dépasse. Nous n’avons pas nécessairement à nous soumettre à sa course. Il nous revient désormais de lui donner son rythme. La technique crée un monde sans limite, il revient au pouvoir démocratique de la redéfinir. Son invasion des moindres interstices encore épargnés de nos vies doit cesser. Et le plus ironique dans tout cela, c’est que nous n’aurons pas d’autres choix que de dire « stop » au numérique.

Notes :

[1] Pierre Legendre, Ce que l’Occident ne voit pas de l’Occident, France, Les Quarante Piliers, 2023, p. 26.

[2] Ibid, p. 316.

[3] Zygmunt Bauman, La Vie liquide, Paris, Fayard, 2013.

[4] Fabrice Hadjadj, Puisque tout est en voie de destruction, Paris, Points, 2014, p. 65.